En un post publicado la semana pasada, Meta pregunta, «¿Dónde están los robots?» La respuesta es simple. Están aquí. Solo hay que saber dónde buscar. Dejando de lado las conversaciones sobre automóviles y asistencia al conductor y concentrándose en cosas que todos tendemos a estar de acuerdo que son robots. Para empezar, esa entrega de Amazon no te llega sin asistencia robótica.

Una pregunta más pertinente sería: ¿Por qué no hay más robots? Y más concretamente, ¿por qué no hay más robots en mi casa ahora mismo? Es una pregunta compleja con muchos matices, muchos de los cuales se reducen al estado actual de las limitaciones de hardware en torno al concepto de un robot de «propósito general». Roomba es un robot. Hay muchos Roombas en el mundo, y eso se debe en gran parte a que los Roombas hacen una cosa bien (una década adicional de I+D ha ayudado a que las cosas avancen desde un estado «bastante bueno»).

No es tanto que la premisa de la pregunta sea defectuosa, es más una cuestión de reformularla ligeramente. “¿Por qué no hay más robots?” es una pregunta perfectamente válida para alguien que no sea robotista.

La versión de Meta está basada en software, y eso es bastante justo. En los últimos años, ha habido de una explosión de nuevas empresas que abordan varias categorías importantes, como el aprendizaje robótico, la implementación/gestión y las soluciones sin código y con poco código. Mención especial a las casi dos décadas de investigación y desarrollo que se dedicaron a crear, mantener y mejorar ROS (Robot Operating System, de código abierto). Oportunamente, los lìderes de siempre, Open Robotics fueron adquiridos por Alphabet, que ha estado haciendo su propio trabajo en la categoría a través de los esfuerzos locales, Intrinsic y Everyday Robots (aunque se vieron afectados de manera desproporcionada por la reducción de recursos en toda la organización).

Sin duda, Meta/Facebook tiene su propia parte de los proyectos de skunkworks que surgen de vez en cuando. No he visto nada hasta ahora que sugiera que están a la altura de lo que Alphabet/Google ha explorado a lo largo de los años, pero siempre es interesante ver algunos de estos proyectos asomándose. En un anuncio que sospecho firmemente que está relacionado con la proliferación de debates sobre IA generativa, el gigante de las redes sociales ha compartido lo que llama «dos avances importantes hacia agentes de IA incorporados de propósito general capaces de realizar habilidades sensoriomotoras desafiantes».

Citando directamente aquí:

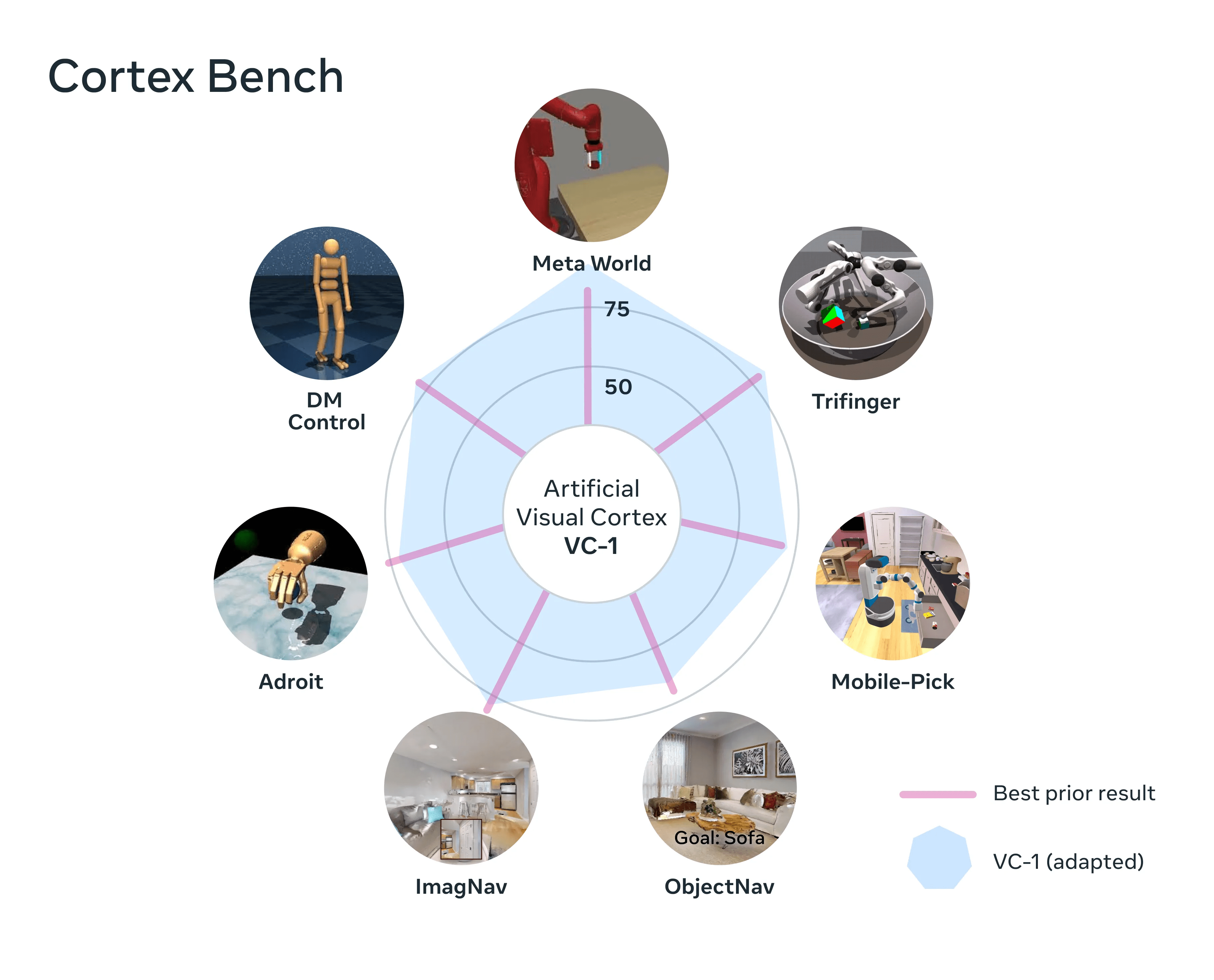

Una corteza visual, Cortex Bench, artificial (llamada VC-1): un modelo de percepción único que, por primera vez, admite una amplia gama de habilidades sensoriomotoras, entornos y encarnaciones. VC-1 está capacitado en videos de personas que realizan tareas cotidianas a partir del innovador conjunto de datos Ego4D creado por Meta AI y socios académicos. Y VC-1 iguala o supera los resultados más conocidos en 17 tareas sensoriomotoras diferentes en entornos virtuales.

Un nuevo enfoque llamado coordinación de habilidades adaptativas (sensomotoras) (ASC), que logra un rendimiento casi perfecto (98 por ciento de éxito) en la desafiante tarea de la manipulación móvil robótica (navegar a un objeto, levantarlo, navegar a otra ubicación, colocar el objeto, repetición) en entornos físicos.

Imagen: Meta

Investigación interesante, sin duda, y emocionante para profundizar potencialmente en algo de esto. La frase «propósito general» está siendo utilizada mucho en estos días. Es un tema de conversación perpetuamente interesante en robótica, pero ha habido una proliferación masiva de robots humanoides de uso general que salen de la carpintería a raíz de la presentación del bot Tesla. Durante años, la gente ha dicho cosas como: «Di lo que quieras sobre Musk, pero Tesla ha despertado un interés renovado en los vehículos eléctricos», y así es más o menos lo que siento por Optimus en este momento. Cumplió una importante función dual al renovar la discusión sobre el factor de forma, al tiempo que proporciona una imagen clara para señalar al explicar lo difícil que es esto. ¿Es posible elevar dramáticamente las expectativas del público y moderarlas al mismo tiempo?

Una vez más, esas conversaciones encajan muy bien con todos estos avances de GPT. Todo esto es muy impresionante, pero Rodney Brooks planteó el peligro de combinar las cosas bastante bien en este hace unas semanas: “Creo que la gente es demasiado optimista. Están confundiendo desempeño con competencia. Ves un buen desempeño en un ser humano, puedes decir en qué es competente. Somos bastante buenos modelando personas, pero esos mismos modelos no se aplican. Ves un gran rendimiento de uno de estos sistemas, pero no te dice cómo va a funcionar en el espacio adyacente o con datos diferentes”.

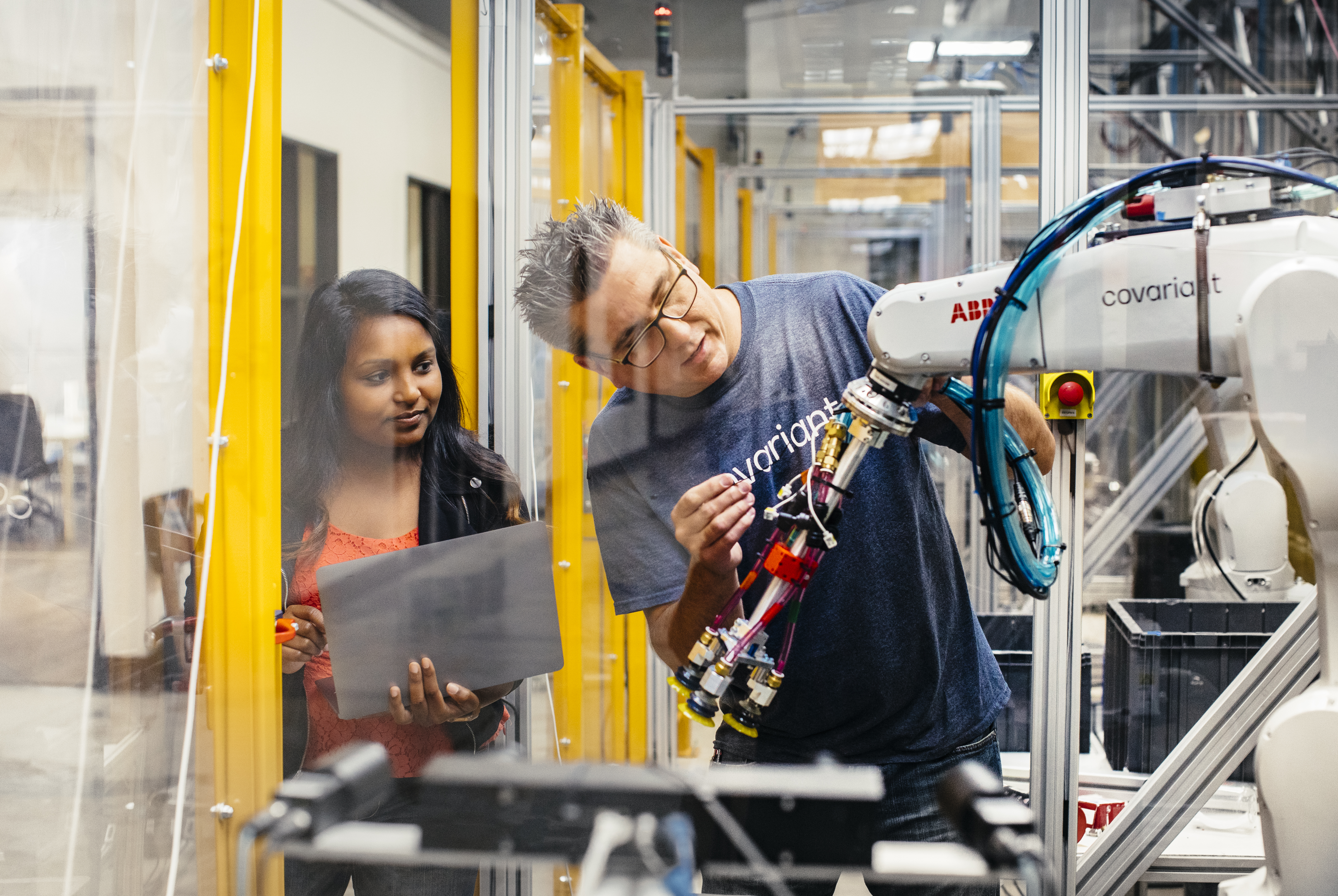

Imagen: Covariant

Obviamente, esto no impide preguntarle a la mayoría de las personas en ProMat sobre su opinión sobre el futuro papel de la IA generativa en la robótica. Las respuestas fueron de amplio rango Algunos se encogen de hombros, otros ven un papel muy reglamentado para la tecnología, y otros son extremadamente optimistas sobre lo que todo esto significa para el futuro. Peter Chen, el CEO de Covariant (que acaba de recaudar $75 millones), ofreció un contexto interesante en lo que respecta a la IA generalizada:

Antes del reciente ChatGPT, había muchas IA de procesamiento de lenguaje natural. Buscar, traducir, detección de sentimientos, detección de spam: había un montón de IA de lenguaje natural por ahí. El enfoque antes de GPT es, para cada caso de uso, entrenar una IA específica, utilizando un subconjunto de datos más pequeño.

Viendo los resultados ahora, GPT elimina el campo de la traducción, y ni siquiera está capacitado para traducir. Básicamente, el enfoque del modelo de base es, en lugar de usar pequeñas cantidades de datos que son específicos para una situación o entrenar un modelo que es específico para una circunstancia, entrenemos un gran modelo generalizado de base con muchos más datos, por lo que la IA es más generalizada.

Por supuesto, Covariant actualmente está muy centrado en elegir y colocar. Francamente, es un desafío lo suficientemente grande como para mantenerlos ocupados durante mucho tiempo. Pero una de las promesas que ofrecen los sistemas como este es la capacitación en el mundo real. Las empresas que realmente tienen robots reales que realizan trabajos reales en el mundo real están construyendo bases de datos y modelos extremadamente poderosos sobre cómo las máquinas interactúan con el mundo que las rodea.

No es difícil ver cuántos de los bloques de construcción aparentemente dispares que están fortaleciendo los investigadores y las empresas podrían unirse algún día para crear un sistema verdaderamente de propósito general. Cuando el hardware y la IA estén en ese nivel, habrá un tesoro aparentemente inagotable de datos de campo para entrenarlos.

Por el momento, el enfoque de plataforma tiene mucho sentido. Con Spot, por ejemplo, Boston Dynamics vende efectivamente a los clientes un modelo de iPhone. Primero, produce la primera generación de una impresionante pieza de hardware. A continuación, ofrece un SDK a las partes interesadas. Si las cosas salen según lo planeado, de repente tiene este producto haciendo cosas que su equipo nunca imaginó. Suponiendo que eso no implique montar una pistola en la parte posterior del producto (según las pautas de BD), es una propuesta emocionante.

Imagen: 1X

Es demasiado pronto para decir algo definitivo sobre El robot NEO de 1X Technologies, más allá del hecho de que la firma claramente espera vivir justo en esa sección transversal entre la robótica y la IA generativa. Ciertamente tiene un poderoso aliado en OpenAI. El Startup Fund del gigante de la IA generativa lideró una ronda de $23,5 millones, que también contó con Tiger Global, entre otros.

Dice el fundador y CEO de 1X, Bernt Øivind Børnich, “1X está encantado de que OpenAI lidere esta ronda porque estamos alineados en nuestras misiones: integrar cuidadosamente la tecnología emergente en la vida diaria de las personas. Con el apoyo de nuestros inversores, continuaremos logrando avances significativos en el campo de la robótica y aumentando el mercado laboral mundial”.

Una nota interesante sobre eso (al menos para mí) es que 1X ha estado dando vueltas durante un minuto. La firma noruega era conocida como Halodi hasta su muy reciente (exactamente hace un mes) cambio de marca conciso. Solo tiene que retroceder uno o dos años para ver cómo los comienzos toman el factor de forma humanoide que la compañía estaba desarrollando. para servicio de comida. La tecnología definitivamente parece más sofisticada que su contraparte de 2021, pero la base con ruedas revela cuánto queda por recorrer para llegar a alguna versión del robot que vemos si se renderiza.

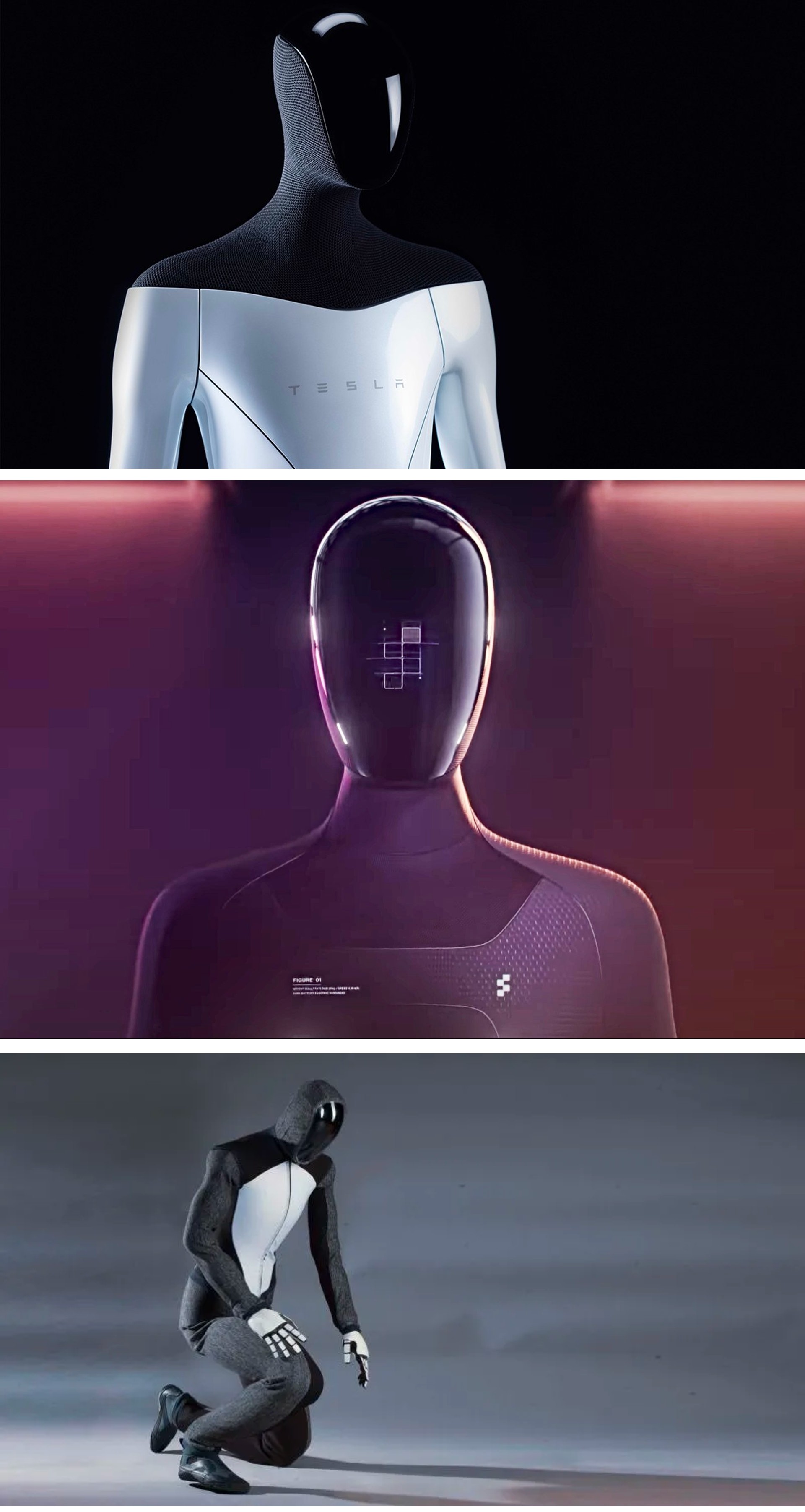

Imágenes: Tesla/Figura/IX

De arriba a abajo, estos son renders de Tesla Optimus, Figure 01 y 1X Neo. No son copias directas, obviamente, pero ciertamente parece que podrían ser primos. Neo es el que insiste en usar una sudadera con capucha, incluso en ocasiones formales.

Imagen: MIT CSAIL

En paralelo hay interesantes proyectos de investigación. Uno es el del MIT. Cuando realmente se piensa en ello, jugar fútbol es una excelente manera de probar la locomoción. Hay una razón por la que la Robocup ha estado funcionando durante casi 20 años. Sin embargo, en el caso de Dribblebot, el desafío es un terreno irregular, que incluye cosas como hierba, barro y arena.

Dice el profesor del MIT Pulkit Agrawal:

Si miras a tu alrededor hoy, la mayoría de los robots tienen ruedas. Pero imagina que hay un escenario de desastre, una inundación o un terremoto, y queremos que los robots ayuden a los humanos en el proceso de búsqueda y rescate. Necesitamos las máquinas para recorrer terrenos que no son planos, y los robots con ruedas no pueden atravesar esos paisajes. El objetivo de estudiar robots con patas es ir a terrenos fuera del alcance de los sistemas robóticos actuales.

Imagen: Universidad de California en Los Ángeles

Otro proyecto de investigación es de la Escuela de Ingeniería Samueli de la UCLA, que ha publicado recientemente hallazgos de su trabajo en torno a los robots de origami. Los Origami MechanoBots, u «OrigaMechs», se basan en sensores integrados en sus delgados bloques de construcción de poliéster. El investigador principal Ankur Mehta tiene algunos planes bastante lejanos para la tecnología.

“Este tipo de escenarios peligrosos o impredecibles, como durante un desastre natural o provocado por el hombre, podría ser donde los robots de origami demostraron ser especialmente útiles”, dijo en una publicación. “Los robots podrían diseñarse para funciones especiales y fabricarse bajo demanda muy rápidamente. Además, si bien está muy lejos, podría haber entornos en otros planetas donde los robots exploradores que son inmunes a esos escenarios serían muy deseables”.