Dans un article publié la semaine dernière, méta-question, "Où sont les robots ?" La réponse est simple. Ils sont ici. Il suffit de savoir où chercher. Laisser de côté les discussions sur les voitures et l'assistance à la conduite et se concentrer sur des choses que nous avons tous tendance à considérer comme des robots. Pour commencer, cette livraison Amazon ne vous parvient pas sans assistance robotique.

Une question plus pertinente serait : pourquoi n'y a-t-il pas plus de robots ? Et plus précisément, pourquoi n'y a-t-il pas plus de robots dans ma maison en ce moment ? C'est une question complexe avec de nombreuses nuances, dont beaucoup se résument à l'état actuel des limitations matérielles autour du concept de robot "à usage général". Roomba est un robot. Il y a beaucoup de Roombas dans le monde, et c'est en grande partie parce que Roombas fait une chose correctement (une décennie supplémentaire de R&D a aidé à faire passer les choses d'un état « plutôt bon »).

Ce n'est pas tant que la prémisse de la question est erronée, il s'agit plutôt de la reformuler légèrement. « Pourquoi n'y a-t-il pas plus de robots ? » est une question parfaitement valable pour quelqu'un qui n'est pas roboticien.

La version Meta est basée sur un logiciel, et c'est assez juste. Ces dernières années, il y a eu une explosion de startups abordant plusieurs catégories importantes, telles que l'apprentissage robotique, le déploiement/la gestion et les solutions sans code et à faible code. Mention spéciale aux presque deux décennies de recherche et développement consacrées à la création, à la maintenance et à l'amélioration de ROS (Robot Operating System, open source). Oportunamente, los lìderes de siempre, Open Robotics fueron adquiridos por Alphabet, que ha estado haciendo su propio trabajo en la categoría a través de los esfuerzos locales, Intrinsic y Everyday Robots (aunque se vieron afectados de manera desproporcionada por la reducción de recursos en toda l'organisation).

Il ne fait aucun doute que Meta / Facebook a sa propre part de projets skunkworks qui apparaissent de temps en temps. Je n'ai rien vu jusqu'à présent suggérant qu'ils soient à la hauteur de ce qu'Alphabet/Google a exploré au fil des ans, mais il est toujours intéressant de voir certains de ces projets se profiler. Dans une annonce que je soupçonne fortement d'être liée à la prolifération des débats sur l'IA générative, le géant des médias sociaux a partagé ce qu'il appelle "deux avancées majeures vers des agents d'IA embarqués à usage général capables de défier les compétences sensorimotrices".

Citant directement ici :

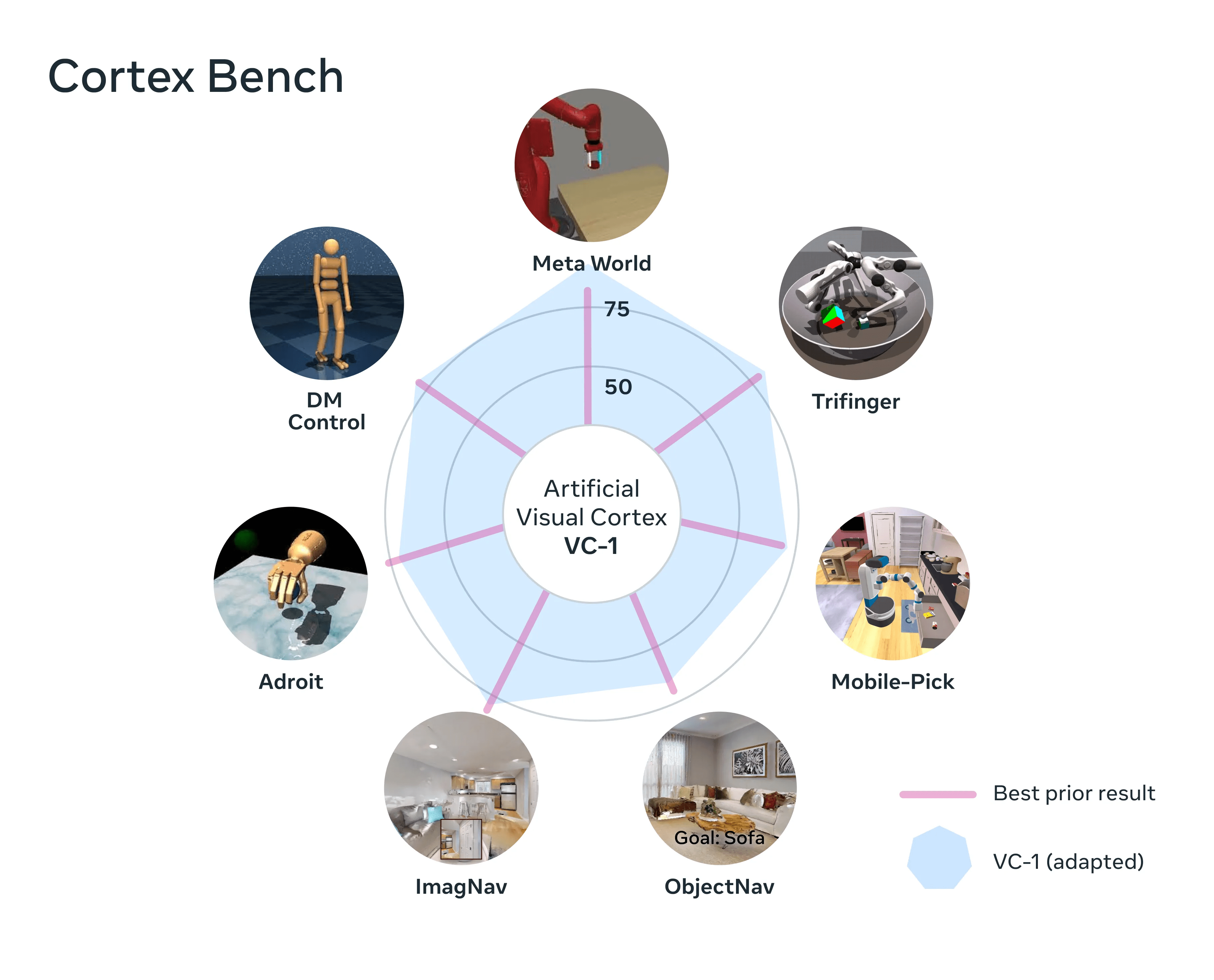

Un cortex visuel artificiel, Cortex Bench (nommé VC-1) : un modèle de perception unique qui, pour la première fois, prend en charge un large éventail de capacités sensorimotrices, d'environnements et d'incarnations. VC-1 est formé sur des vidéos de personnes effectuant des tâches quotidiennes à partir de l'ensemble de données innovant Ego4D créé par Meta AI et des partenaires académiques. Et VC-1 correspond ou dépasse les résultats les plus connus sur 17 tâches sensorimotrices différentes dans des environnements virtuels.

Une nouvelle approche appelée coordination adaptative des compétences (sensomotrice) (ASC), qui atteint des performances presque parfaites (98 % de réussite) dans la tâche difficile de la manipulation mobile robotique (naviguer vers un objet, le ramasser, naviguer vers un autre emplacement, placer le objet, répétition) dans des environnements physiques.

Image: Meta

Des recherches intéressantes, bien sûr, et excitantes de se plonger potentiellement dans certaines de ces questions. L'expression "usage général" est souvent utilisée ces jours-ci. C'est un sujet de conversation perpétuellement intéressant en robotique, mais il y a eu une prolifération massive de robots humanoïdes à usage général sortant des boiseries à la suite de l'introduction du bot Tesla. Pendant des années, les gens ont dit des choses comme "Dites ce que vous voulez à propos de Musk, mais Tesla a suscité un regain d'intérêt pour les véhicules électriques", et c'est à peu près ce que je ressens pour Optimus en ce moment. Il a rempli une double fonction importante en renouvelant la discussion sur le facteur de forme, tout en fournissant une image claire à souligner pour expliquer à quel point cela est difficile. Est-il possible d'augmenter considérablement les attentes du public et de les modérer en même temps ?

Encore une fois, ces conversations s'accordent bien avec toutes ces avancées GPT. Tout cela est très impressionnant, mais Rodney Brooks a évoqué il y a quelques semaines le danger de mélanger assez bien les choses sur celui-ci : « Je pense que les gens sont trop optimistes. Ils confondent performance et compétence. Vous voyez une bonne performance chez un être humain, vous pouvez dire en quoi il est compétent. Nous sommes assez bons pour modéliser les gens, mais ces mêmes modèles ne s'appliquent pas. Vous voyez d'excellentes performances de l'un de ces systèmes, mais cela ne vous dit pas comment il va fonctionner dans l'espace adjacent ou avec des données différentes."

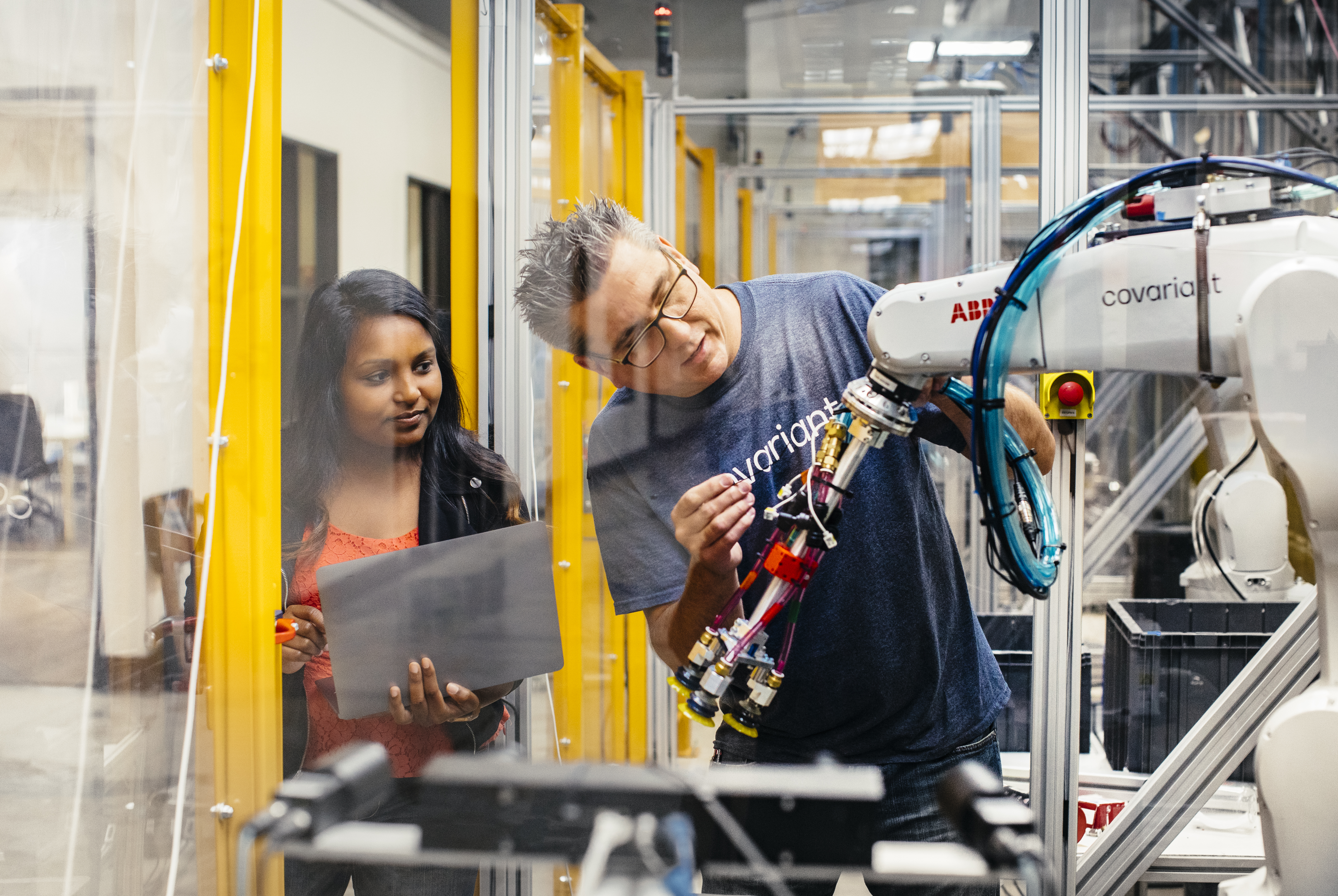

Image: Covariante

Évidemment, cela n'empêche pas de demander à la plupart des gens ProMat à propos de son opinion sur le rôle futur de l'IA générative dans la robotique. Les réponses ont été très variées : certains haussent les épaules, d'autres voient un rôle très réglementé pour la technologie, et d'autres encore sont extrêmement optimistes quant à ce que tout cela signifie pour l'avenir. Peter Chen, le PDG de Covariant (qui vient de lever 75 millions de dollars), a proposé un contexte intéressant en ce qui concerne l'IA omniprésente :

Avant le récent ChatGPT, il y avait beaucoup d'IA de traitement du langage naturel. Recherche, traduction, détection de sentiments, détection de spam - il y avait une tonne d'IA en langage naturel. L'approche avant GPT consiste, pour chaque cas d'utilisation, à former une IA spécifique, en utilisant un plus petit sous-ensemble de données.

En regardant les résultats maintenant, GPT supprime le champ de traduction et n'est même pas capable de traduire. Fondamentalement, l'approche du modèle de base est, au lieu d'utiliser de petites quantités de données spécifiques à une situation ou d'entraîner un modèle spécifique à une circonstance, formons un grand modèle de base généralisé avec beaucoup plus de données, donc l'IA est plus omniprésente .

Bien sûr, Covariant est actuellement très concentré sur le pick and place. Franchement, c'est un défi assez grand pour les occuper longtemps. Mais l'une des promesses que des systèmes comme celui-ci offrent est la formation dans le monde réel. Les entreprises qui ont de vrais robots effectuant de vrais travaux dans le monde réel construisent des bases de données et des modèles extrêmement puissants sur la façon dont les machines interagissent avec le monde qui les entoure.

Il n'est pas difficile de voir combien de blocs de construction apparemment disparates renforcés par les chercheurs et les entreprises pourraient un jour se réunir pour créer un système véritablement polyvalent. Lorsque le matériel et l'IA seront à ce niveau, il y aura une mine apparemment infinie de données de terrain pour les entraîner.

Pour le moment, l'approche de la plateforme a beaucoup de sens. Avec Spot, par exemple, Boston Dynamics vend effectivement à ses clients un modèle d'iPhone. Tout d'abord, il produit la première génération d'un matériel impressionnant. Il propose ensuite un SDK aux parties intéressées. Si les choses se passent comme prévu, tout à coup, ce produit fait des choses que votre équipe n'aurait jamais imaginées. En supposant que cela n'implique pas de monter un pistolet à l'arrière du produit (conformément aux directives de BD), c'est une proposition passionnante.

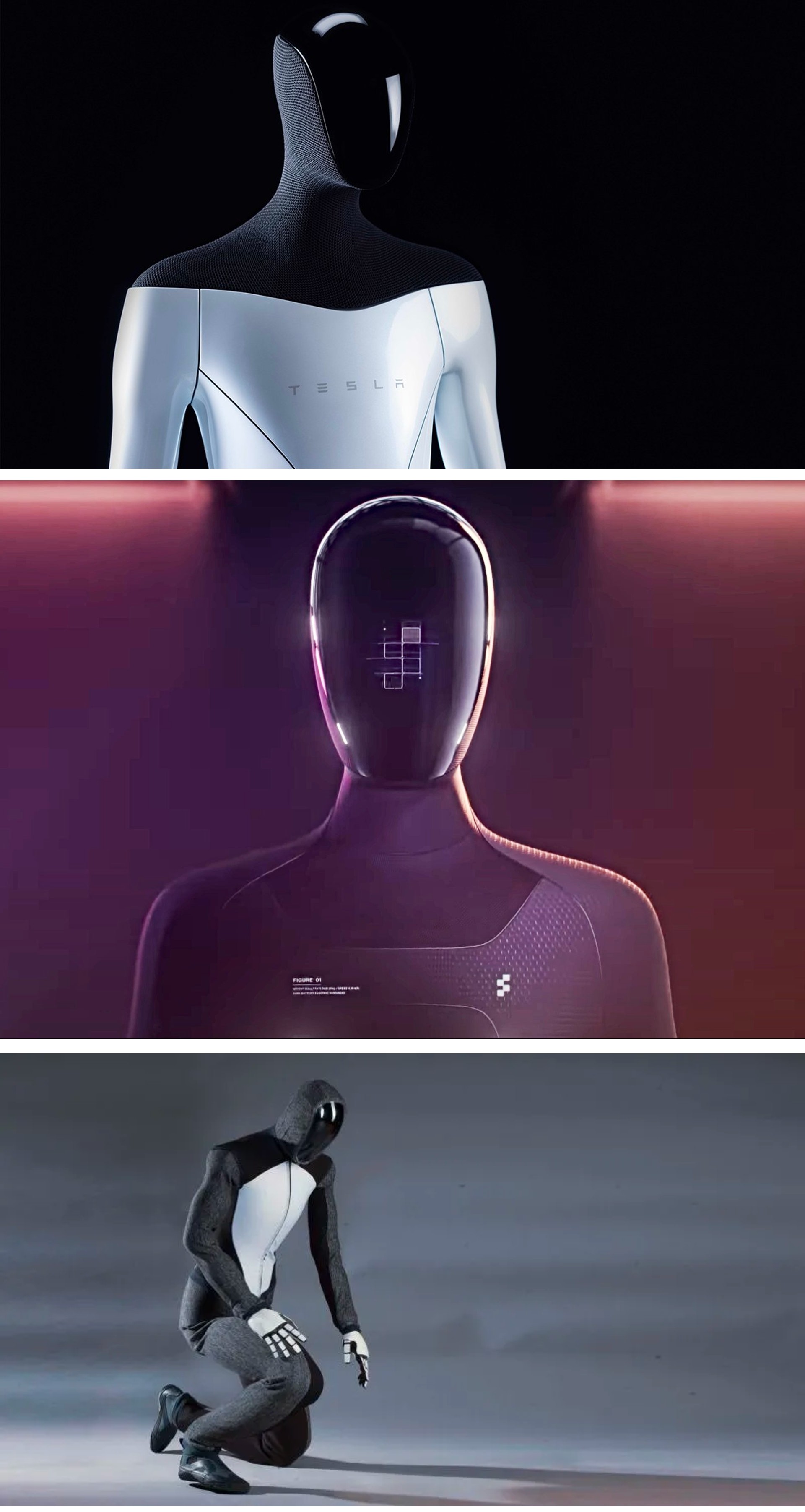

Image: 1X

Il est trop tôt pour dire quoi que ce soit de définitif sur Le robot NEO de 1X Technologies, au-delà du fait que l'entreprise espère clairement vivre dans ce croisement entre la robotique et l'IA générative. Vous avez certainement un allié puissant dans OpenAI. Le fonds de démarrage du géant de l'IA générative a mené une ronde de 23,5 millions de dollars, qui comprenait également Tiger Global, entre autres.

Selon le fondateur et PDG de 1X, Bernt Øivind Børnich, « 1X est ravi qu'OpenAI dirige ce cycle car nous sommes alignés sur nos missions : intégrer de manière réfléchie les technologies émergentes dans la vie quotidienne des gens. Avec le soutien de nos investisseurs, nous continuerons à faire des avancées significatives dans le domaine de la robotique et à augmenter le marché mondial de l'emploi."

Une note intéressante à ce sujet (du moins pour moi) est que 1X existe depuis une minute. La firme norvégienne était connue sous le nom de Halodi jusqu'à sa toute récente (exactement il ya un mois) rebranding concis. Il suffit de revenir un an ou deux en arrière pour voir les débuts prendre le facteur de forme humanoïde que l'entreprise développait. pour la restauration. La technologie semble définitivement plus sophistiquée que son homologue de 2021, mais la base à roues révèle jusqu'où aller pour arriver à une version du robot que nous voyons si elle est rendue.

Images: Tesla/Figure/IX

De haut en bas, ce sont des rendus de Tesla Optimus, Figure 01 et 1X Neo. Ce ne sont évidemment pas des copies directes, mais ils semblent certainement être des cousins. Neo est celui qui insiste pour porter un sweat à capuche, même lors d'occasions formelles.

Image: MITCSAIL

En parallèle, il existe des projets de recherche intéressants. L'un vient du MIT. Quand on y pense vraiment, jouer au football est un excellent moyen de tester votre locomotion. Il y a une raison pour laquelle la Robocup existe depuis près de 20 ans. Cependant, dans le cas de Dribblebot, le défi est un terrain accidenté, y compris des choses comme l'herbe, la boue et le sable.

Selon le professeur du MIT Pulkit Agrawal :

Si vous regardez autour de vous aujourd'hui, la plupart des robots ont des roues. Mais imaginez qu'il y ait un scénario de catastrophe, une inondation ou un tremblement de terre, et nous voulons que des robots aident les humains dans le processus de recherche et de sauvetage. Nous avons besoin que les machines traversent un terrain qui n'est pas plat, et les robots à roues ne peuvent pas traverser de tels paysages. Le but de l'étude des robots à pattes est d'aller dans des domaines hors de portée des systèmes robotiques actuels.

Image: Université de Californie à Los Angeles

Un autre projet de recherche est de l'UCLA Samueli School of Engineering, qui a récemment publié résultats de son travail autour des robots origami. Origami MechanoBots, ou "OrigaMechs", s'appuient sur des capteurs intégrés dans leurs blocs de construction en polyester minces. Le chercheur principal Ankur Mehta a des projets assez ambitieux pour la technologie.

"Ces types de scénarios dangereux ou imprévisibles, comme lors d'une catastrophe naturelle ou provoquée par l'homme, pourraient être les cas où les robots origami se sont révélés particulièrement utiles", a-t-il déclaré dans un message. « Les robots pourraient être conçus pour des fonctions spéciales et fabriqués à la demande très rapidement. De plus, bien qu'il soit loin, il pourrait y avoir des environnements sur d'autres planètes où des robots éclaireurs immunisés contre ces scénarios seraient hautement souhaitables."