En juin dernier, quelques mois seulement après le lancement de ChatGPT d'OpenAI, deux avocats de la ville de New York ont tristement utilisé cet outil. rédiger un très mauvais résumé. L’IA a cité de fausses affaires, provoquant un tollé, un juge en colère et deux avocats très embarrassés. C’est la preuve que même si des robots comme ChatGPT peuvent être utiles, il faut vraiment vérifier attentivement leur travail, notamment dans un contexte juridique.

L'affaire n'a pas échappé aux gens de LexisNexis, une société de logiciels juridiques qui propose des outils pour aider les avocats à trouver la bonne jurisprudence pour faire valoir leurs arguments juridiques. L’entreprise voit le potentiel de l’IA pour contribuer à réduire une grande partie du travail juridique banal effectué par chaque avocat, mais reconnaît également ces problèmes très réels alors qu’elle entame son parcours vers l’IA générative.

Jeff Reihl, CTO de LexisNexis, comprend la valeur de l'IA. En fait, votre entreprise intègre la technologie dans sa plateforme depuis un certain temps. Mais pouvoir ajouter une fonctionnalité de type ChatGPT à votre boîte à outils juridique aiderait les avocats à travailler plus efficacement : cela faciliterait la rédaction de documents courts et la recherche de citations plus rapidement.

« En tant qu'organisation, nous avons été travailler avec les technologies d'intelligence artificielle pour plusieurs années. "Je pense que ce qui est vraiment différent maintenant depuis la sortie de ChatGPT en novembre, c'est la possibilité de générer du texte et les aspects conversationnels qui accompagnent cette technologie", a déclaré Reihl.

Et même s’il considère que cela pourrait constituer une couche puissante au-dessus de la famille de logiciels juridiques LexisNexis, cela comporte également des risques. "Avec l'IA générative, je pense que nous voyons vraiment la puissance et les limites de cette technologie, ce qu'elle peut et ne peut pas faire de bien", a-t-il déclaré. "Et c'est là que nous pensons qu'en réunissant nos capacités et les données dont nous disposons, ainsi que les capacités dont disposent ces grands modèles de langage, nous pouvons faire quelque chose qui est fondamentalement transformateur pour le secteur juridique."

L'enquête dit...

LexisNexis a récemment interrogé 1.000 XNUMX avocats sur le potentiel de l’IA générative pour leur profession. Les données ont montré que les gens étaient pour la plupart positifs, mais elles ont également révélé que les avocats reconnaissent les faiblesses de la technologie, ce qui tempère en partie l'enthousiasme à son sujet.

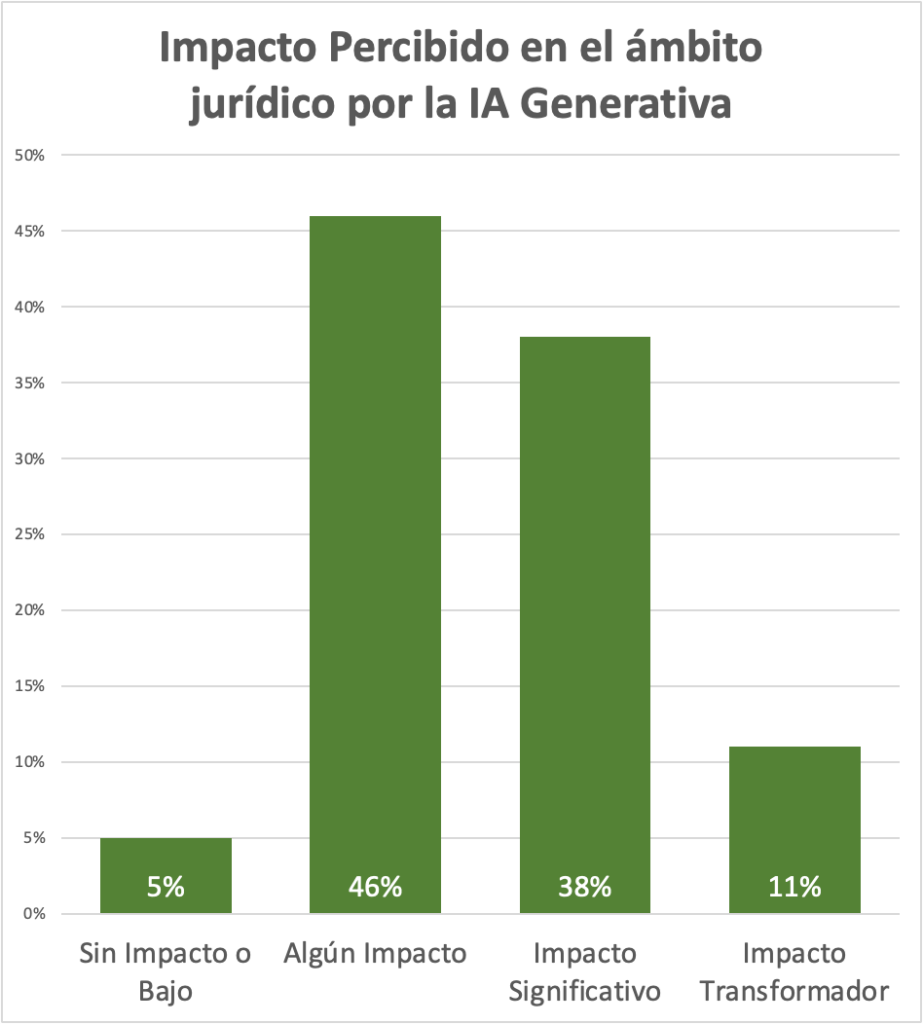

A titre d’exemple, interrogés sur l’impact perçu de l’IA générative sur leur profession, 46 % ont répondu par une réponse plutôt tiède : « un certain impact ». Mais la deuxième réponse la plus élevée, à 38 %, était « impact significatif ». Il s’agit là d’opinions subjectives sur la façon dont ils pourraient utiliser une technologie qui est encore en cours d’évaluation et qui fait l’objet de beaucoup de battage médiatique, mais les résultats montrent que la majorité des avocats interrogés voient au moins le potentiel de l’IA générative pour aider. Ils font leur travail.

Gardez à l’esprit qu’il y a toujours place à des biais en termes de types de questions et d’interprétations des données lorsqu’il s’agit d’enquêtes menées par des prestataires, mais les données sont utiles pour voir en termes généraux ce que les avocats pensent de la technologie.

Question d'enquête LexisNexis sur les avocats explorant l'impact perçu de l'IA sur la pratique du droit.

Crédits image : LexisNexis

L'un des problèmes clés ici est de faire confiance aux informations que vous obtenez du bot, et LexisNexis travaille sur plusieurs façons de renforcer la confiance dans les résultats des utilisateurs.

Résoudre les problèmes d’IA connus

Le problème de la confiance est un problème auquel tous les utilisateurs de l'IA générative seront confrontés, du moins pour le moment, mais Reihl affirme que son entreprise reconnaît les enjeux pour ses clients.

"Compte tenu de leur rôle et de ce qu'ils font en tant que profession, ce qu'ils font doit être précis à 100 %", a-t-il déclaré. "Ils doivent s'assurer que s'ils citent un cas, il s'agit toujours d'une bonne loi et qu'il représente leurs clients de la bonne manière."

« S’ils ne représentent pas au mieux leurs clients, ils pourraient être radiés du barreau. Et nous avons la réputation de pouvoir fournir des informations fiables à nos clients.

Sebastian Berns, chercheur en doctorat à l'Université Queen Mary de Londres, a déclaré que tout LLM mis en œuvre provoquerait des hallucinations. Il n'y a aucun moyen d'y échapper.

"Un LLM est généralement formé pour toujours produire un résultat, même lorsque les données d'entrée sont très différentes des données de formation", a-t-il déclaré. "Un LLM standard n'a aucun moyen de savoir s'il est capable de répondre de manière fiable à une requête ou de faire une prédiction."

LexisNexis tente d'atténuer ce problème de plusieurs manières. Pour commencer, cela implique de former des modèles avec leur propre vaste ensemble de données juridiques pour compenser certains des problèmes de fiabilité que nous avons constatés avec les modèles fondamentaux. Reihl affirme que la société travaille également avec la jurisprudence la plus récente dans les bases de données, de sorte qu'il n'y aura pas de problèmes de timing comme avec ChatGPT, qui ne s'entraînera qu'avec des informations provenant du Web ouvert jusqu'en 2021.

L'entreprise estime que l'utilisation de données de formation plus pertinentes et plus opportunes devrait produire de meilleurs résultats. « Nous pouvons garantir que tout cas référencé figure dans notre base de données. Nous ne publierons donc pas de devis qui ne correspond pas à un cas réel, car nous avons déjà ces cas dans notre propre base de données. »

Bien qu'il ne soit pas clair si une entreprise peut éliminer complètement les hallucinations, LexisNexis permet aux avocats qui utilisent le logiciel de regarder le robot trouver la réponse en fournissant une référence à la source.

"Nous pouvons donc remédier aux limitations des grands modèles de langage en combinant la puissance dont ils disposent avec notre technologie et en donnant aux utilisateurs des références au cas afin qu'ils puissent le valider eux-mêmes", a déclaré Reihl.

Il est important de noter qu'il s'agit d'un travail en cours et LexisNexis travaille actuellement avec six clients pour affiner l'approche en fonction de leurs commentaires. Le plan est de lancer des outils basés sur l’IA dans les mois à venir.