Un humain a écrit cela, ou ChatGPT ? C'est peut-être difficile à savoir, peut-être trop difficile, pense son créateur OpenAI, c'est pourquoi il travaille sur un moyen de "filigraner" le contenu généré par l'IA.

Dans un conférence à l'Université d'Austin, le professeur d'informatique Scott Aaronson, actuellement chercheur invité à OpenAI, a révélé qu'un outil est en cours de développement pour "filigraner statistiquement les résultats d'un texte d'IA". Chaque fois qu'un système, par exemple ChatGPT, génère du texte, l'outil intègre un "signal secret argenté" qui indique d'où provient le texte.

l'ingénieur de OpenAIHendrik Kirchner a construit un prototype fonctionnel, dit Aaronson, et l'espoir est de l'intégrer dans les futurs systèmes développés par OpenAI.

"Nous voulons qu'il soit beaucoup plus difficile de prendre une sortie d'IA et de la faire passer pour un être humain", a déclaré Aaronson dans ses commentaires. "Cela pourrait être utile pour prévenir le plagiat universitaire, évidemment, mais aussi, par exemple, la génération de propagande de masse, vous savez, spammer chaque blog avec des commentaires apparemment sur le sujet soutenant l'invasion russe de l'Ukraine sans même un bâtiment plein de trolls à Moscou, ou imiter le style d'écriture de quelqu'un pour les encadrer."

Exploiter le hasard

Pourquoi le besoin d'un filigrane? ChatGPT en est un bon exemple. Le chatbot développé par OpenAI il a pris d'assaut Internet, affichant une aptitude non seulement à répondre à des questions difficiles, mais aussi à écrire de la poésie, à résoudre des énigmes de programmation et à devenir poétique sur une foule de sujets philosophiques.

Bien que ChatGPT soit très amusant et vraiment utile, le système soulève des préoccupations éthiques évidentes. Comme de nombreux systèmes de génération de texte avant lui, ChatGPT pourrait être utilisé pour écrire des e-mails de phishing de haute qualité et des logiciels malveillants nuisibles, ou pour tricher lors de devoirs scolaires. Et en tant qu'outil de questions-réponses, il est factuellement incohérent, une lacune qui a conduit à la programmation du site de questions-réponses Stack Overflow interdisant les réponses provenant de ChatGPT jusqu'à nouvel ordre.

Comprendre les fondamentaux techniques de l'outil de filigrane OpenAI, il est utile de savoir pourquoi des systèmes tels que ChatGPT fonctionnent aussi bien qu'eux. Ces systèmes comprennent le texte d'entrée et de sortie comme des chaînes de "tokens", qui peuvent être des mots mais aussi des signes de ponctuation et des parties de mots. Essentiellement, les systèmes génèrent constamment une fonction mathématique appelée distribution de probabilité pour décider du prochain jeton (par exemple, un mot) à générer, en tenant compte de tous les jetons émis précédemment.

Dans le cas de systèmes hébergés sur OpenAI comme ChatGPT, après la construction de la distribution, le serveur de chat OpenAI fait le travail d'échantillonnage des jetons en fonction de la distribution. Il y a du hasard dans cette sélection ; c'est pourquoi le même message texte peut générer une réponse différente.

L'outil filigrane OpenAI il agit comme un "wrapper" sur les systèmes de génération de texte existants, a déclaré Aaronson lors de la conférence, tirant parti d'une fonction cryptographique qui s'exécute au niveau du serveur pour sélectionner "pseudo-aléatoirement" le jeton suivant. En théorie, le texte généré par le système semblerait toujours aléatoire pour vous ou pour moi, mais toute personne détenant la "clé" de la fonction cryptographique pourrait découvrir un filigrane.

« Empiriquement, quelques centaines de jetons semblent suffire pour obtenir un signal raisonnable que oui, ce texte provient d'un système d'IA. En principe, vous pourriez même prendre un long texte et isoler quelles parties proviennent probablement du système d'IA et quelles parties ne le sont probablement pas. a déclaré Aaronson. "L'outil peut faire le filigrane en utilisant une clé secrète et peut vérifier le filigrane en utilisant la même clé."

principales limites

Le filigrane de texte généré par l'IA n'est pas une idée nouvelle. Les tentatives précédentes, principalement basées sur des règles, reposaient sur des techniques telles que les substitutions de synonymes et les changements de mots spécifiques à la syntaxe. Mais hors de la théorie le rapport d'enquête publié par l'institut allemand CISPA en mars dernier, le OpenAI semble être l'une des premières approches cryptographiques du problème.

Lorsqu'il a été contacté pour commenter, Aaronson a refusé d'en dire plus sur le prototype de filigrane, à part le fait qu'il espère co-signer un document de recherche dans les mois à venir. OpenAI il a également refusé, affirmant seulement que le filigrane fait partie de plusieurs "techniques de provenance" qu'il explore pour détecter les résultats générés par l'IA.

Cependant, des universitaires non affiliés et des experts de l'industrie ont partagé des opinions mitigées. Ils soulignent que l'outil est côté serveur, ce qui signifie qu'il ne fonctionnerait pas nécessairement avec tous les systèmes de génération de texte. Et ils soutiennent qu'il serait trivial pour les adversaires de l'éviter.

"Je pense qu'il serait assez facile de contourner cela en reformulant, en utilisant des synonymes, etc.", a déclaré Srini Devadas, professeur d'informatique au MIT. "C'est un peu un bras de fer."

Jack Hessel, chercheur à l'Allen Institute for AI, a noté qu'il serait difficile de prendre des empreintes digitales imperceptibles de texte généré par l'IA car chaque jeton est un choix discret. Une empreinte trop évidente peut entraîner le choix de mots étranges qui dégradent la fluidité, tandis qu'une empreinte trop subtile laisserait place au doute lors de la recherche de l'empreinte.

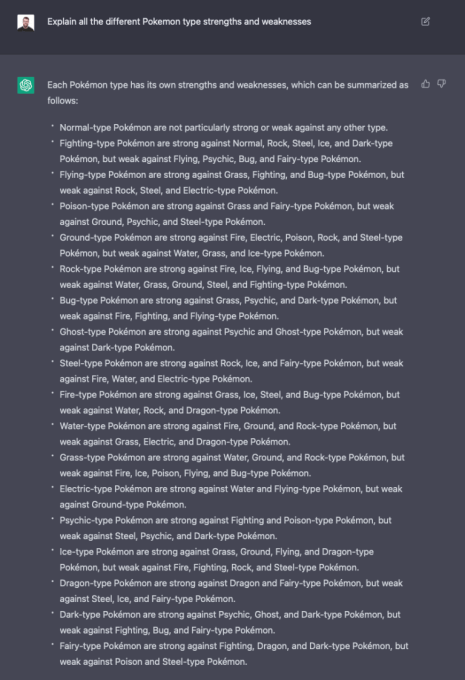

ChatGPT répondant à une question.

Yoav Shoham, co-fondateur et co-PDG d'AI21 Labs, un rival de OpenAI, ne pense pas que le filigrane statistique soit suffisant pour aider à identifier la source du texte généré par l'IA. Il appelle à une approche "plus complète" qui inclut des filigranes différentiels, dans lesquels différentes parties du texte sont marquées différemment, et des systèmes d'IA qui citent plus précisément les sources de texte factuel.

Cette technique de filigrane spécifique nécessite également de placer beaucoup de confiance et de pouvoir dans OpenAIont souligné les experts.

"Une empreinte digitale idéale ne serait pas perceptible par un lecteur humain et permettrait une détection très fiable", a déclaré Hessel par e-mail. "Selon la façon dont il est configuré, il se peut que OpenAI est la seule partie capable de fournir cette détection en toute confiance en raison du fonctionnement du processus de « signature ».

Dans sa conférence, Aaronson a reconnu que le programme ne fonctionnerait vraiment que dans un monde où des entreprises comme OpenAI ils sont à la pointe de l'expansion des systèmes de pointe et s'engagent tous à être des acteurs responsables. Même si OpenAI partagé l'outil de tatouage avec d'autres fournisseurs de systèmes de génération de texte, tels que Cohere et AI21Labs, cela n'empêcherait pas d'autres de choisir de ne pas l'utiliser.

"Si cela devient un jeu gratuit pour tous, alors de nombreuses mesures de sécurité deviennent plus difficiles, et pourraient même être impossibles, du moins sans réglementation gouvernementale", a déclaré Aaronson. "Dans un monde où n'importe qui pourrait créer son propre modèle de texte aussi bon que ChatGPT, par exemple... Que pourrait-on faire là-bas ?"

C'est ainsi que cela se passe dans le domaine du texte à l'image. Contrairement à OpenAI, dont le système d'imagerie DALL-E 2 n'est disponible que via une API, Stability AI a ouvert sa technologie text-to-image (appelée Stable Diffusion). Alors que DALL-E 2 dispose d'un certain nombre de filtres au niveau de l'API pour empêcher la génération d'images problématiques (en plus des filigranes sur les images qu'il génère), l'open source Stable Diffusion ne le fait pas. De mauvais acteurs l'ont utilisé pour créer du faux porno, entre autres toxicités.

Pour sa part, Aaronson est optimiste. Lors de la conférence, il a exprimé la conviction que, si OpenAI peut démontrer que les filigranes fonctionnent et n'affectent pas la qualité du texte généré, il a le potentiel de devenir une norme de l'industrie.

Tout le monde n'est pas d'accord. Comme le souligne Devadas, l'outil nécessite une clé, ce qui signifie qu'il ne peut pas être entièrement open source, ce qui pourrait limiter son adoption aux organisations qui acceptent de s'associer avec lui. OpenAI. (Si la clé était rendue publique, n'importe qui pourrait deviner le motif derrière les filigranes, ce qui irait à l'encontre de leur objectif.)

Mais ce n'est peut-être pas si farfelu. Un représentant de Quora a déclaré que l'entreprise serait intéressée par l'utilisation d'un tel système et qu'elle ne serait probablement pas la seule.

"Vous pourriez vous inquiéter que toute cette affaire d'essayer d'être sûr et responsable lors de la mise à l'échelle de l'IA… dès que cela nuira sérieusement au résultat net de Google, Meta, Alibaba et des autres acteurs majeurs, une grande partie disparaîtra, », a déclaré Aaronson. « D'autre part, on a vu ces 30 dernières années que les grandes entreprises de l'Internet peuvent s'entendre sur certaines normes minimales, que ce soit par peur d'être poursuivi, par désir d'être perçu comme un joueur responsable ou pour toute autre raison. . raison".

Très beau billet. Je viens de tomber sur votre blog et je voulais dire que j'ai vraiment aimé parcourir vos articles de blog. Dans tous les cas, je vais m'abonner à votre flux et j'espère que vous écrivez à nouveau bientôt !