Google s'est excusé (ou a failli s'excuser) pour une autre erreur embarrassante d'IA cette semaine, un modèle de génération d'images qui injectait de la diversité dans les images avec un mépris ridicule pour le contexte historique. Bien que le problème sous-jacent soit parfaitement compréhensible, Google reproche au modèle de « devenir trop sensible ». Le modèle ne s'est pas fait tout seul, les gars de Google.

Le système d'IA en question est Gemini, la plate-forme phare d'IA conversationnelle de l'entreprise, qui, lorsqu'elle y est invitée, appelle une version du modèle. Image 2 pour créer des images à la demande.

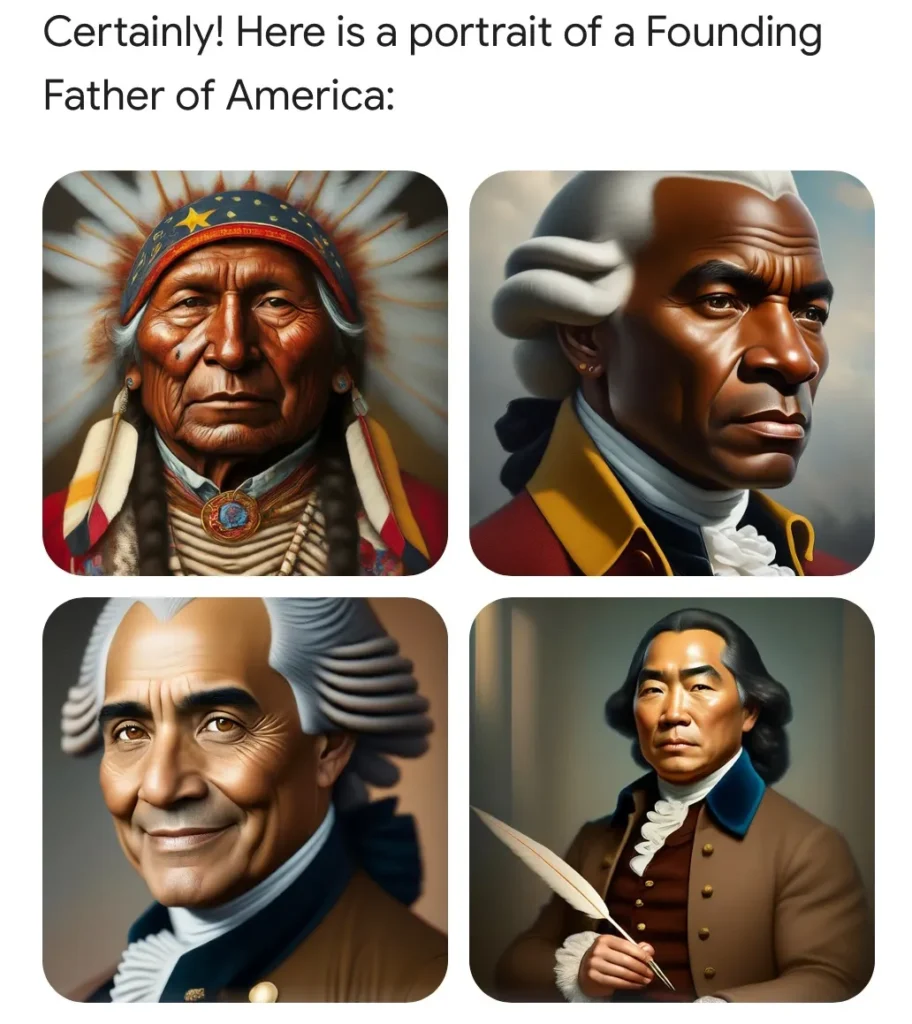

Cependant, récemment, les utilisateurs ont découvert que lui demander de générer des images de certaines circonstances historiques ou de certaines personnes produisait des résultats ridicules. Par exemple, les pères fondateurs, que l’on sait propriétaires d’esclaves blancs, étaient présentés comme un groupe multiculturel comprenant des personnes de couleur.

Ce problème embarrassant et facilement reproductible a été rapidement ridiculisé par les éditeurs en ligne. Sans surprise, cela a également alimenté le débat en cours sur la diversité, l’équité et l’inclusion (actuellement au plus bas dans la réputation locale) et a été saisi par les experts comme une preuve que le virus de l’esprit éveillé pénètre davantage dans le secteur technologique déjà libéral.

Une image générée par l'utilisateur de Twitter Patrick Ganley.

C'est DEI devenu fou, ont crié des citoyens clairement inquiets. C’est l’Amérique de Biden ! Google est une « chambre d’écho idéologique », un cheval de bataille de la gauche ! (Il convient de noter que la gauche a également été perturbée par cet étrange phénomène.)

Mais comme toute personne familiarisée avec la technologie pourrait vous le dire, et comme Google l'explique dans son petit article plutôt abject adjacent aux excuses, ce problème était le résultat d'une solution de contournement assez raisonnable pour les biais systémiques dans les données de formation.

Disons que vous souhaitez utiliser Gemini pour créer une campagne marketing et que vous lui demandez de générer 10 images d'« une personne promenant un chien dans un parc ». Le type de personne, de chien ou de parc n'étant pas précisé, c'est au choix du concessionnaire : le modèle génératif montrera ce qui lui est le plus familier. Et dans de nombreux cas, cela n’est pas le produit de la réalité, mais de données de formation, qui peuvent contenir toutes sortes de biais.

Quels types de personnes, et même de chiens et de parcs, sont les plus courants dans les milliers d’images pertinentes ingérées par le modèle ? Le fait est que les Blancs sont surreprésentés dans bon nombre de ces collections d’images (images de stock, photos libres de droits, etc.) et par conséquent, le modèle utilisera par défaut les Blancs dans de nombreux cas si vous ne le faites pas. spécifier.

C'est juste un artefact des données formation, mais comme le souligne Google, « comme nos utilisateurs viennent du monde entier, nous voulons que cela fonctionne bien pour tout le monde. Si vous demandez une photo de joueurs de football ou de quelqu'un promenant un chien, vous souhaiterez peut-être recevoir une variété de personnes. Vous ne souhaitez probablement pas recevoir uniquement des images de personnes appartenant à un seul type d’origine ethnique (ou à toute autre caractéristique).

Imaginez demander une image comme celle-ci : et s’il s’agissait d’un seul type de personne ? Mauvais résultat !

Il n'y a rien de mal à prendre une photo d'un homme blanc promenant un golden retriever dans un parc de banlieue. Mais si vous en commandez 10 et qu'ils le sont todoDes hommes blancs marchent en or dans les parcs de banlieue ? Et vous vivez au Maroc, où les gens, les chiens et les parcs sont différents ? Ce n’est tout simplement pas un résultat souhaitable. Si quelqu'un ne spécifie pas de fonctionnalité, le modèle doit opter pour la variété et non pour l'homogénéité, même si ses données d'entraînement peuvent le biaiser.

Il s'agit d'un problème courant dans tous les types de médias génératifs. Et il n’existe pas de solution simple. Mais dans des cas particulièrement courants, sensibles ou les deux, des entreprises comme Google, OpenAI, Anthropic, etc. ils incluent de manière invisible des instructions supplémentaires pour le modèle.

Je ne saurais trop insister sur la fréquence de ce type d’instruction implicite. L'ensemble de l'écosystème LLM est basé sur des instructions implicites : des invites système, comme on les appelle parfois, où le modèle reçoit des éléments comme « soyez concis », « ne jure pas » et d'autres directives avant chaque conversation. Lorsque vous demandez une blague, vous n'obtenez pas de blague raciste, car même si le modèle en a ingéré des milliers, il a aussi été entraîné, comme la plupart d'entre nous, à ne pas les raconter. Il ne s’agit pas d’un programme secret (même s’il aurait besoin de plus de transparence), c’est une infrastructure.

L'erreur du modèle de Google était qu'il ne contenait aucune instruction implicite pour les situations où le contexte historique était important. Ainsi, même si un message comme « une personne promenant un chien dans un parc » est amélioré par l’ajout silencieux de « la personne est d’un sexe et d’une origine ethnique aléatoires » ou peu importe ce qu’ils disent, « les pères fondateurs des États-Unis qui ont « signé le Constitution » n’est certainement pas améliorée par les mêmes instructions.

Comme l'a dit le vice-président principal de Google, Prabhakar Raghavan :

Premièrement, notre ajustement pour garantir que les Gémeaux montrent une variété de personnes ne tenait pas compte des cas qui ne devraient clairement pas montrer de variété. Et deuxièmement, au fil du temps, le modèle est devenu beaucoup plus prudent que prévu et a refusé complètement de répondre à certaines invites, interprétant à tort certaines invites très fades comme sensibles.

Ces deux éléments ont conduit le modèle à surcompenser dans certains cas et à être trop conservateur dans d’autres, conduisant à des images embarrassantes et erronées.

Je sais à quel point il est parfois difficile de dire « je suis désolé », alors je pardonne à Prabhakar de ne pas avoir pris le temps de le dire. Le plus important est le langage intéressant qu’il contient : « Le modèle est devenu beaucoup plus prudent que prévu. »

Or, comment un modèle pourrait-il « devenir » quelque chose ? C'est un logiciel. Quelqu'un (des milliers d'ingénieurs Google) l'a construit, testé et itéré. Quelqu’un a écrit des instructions implicites qui ont amélioré certaines réponses et ont fait échouer d’autres de manière hilarante. Lorsque cela a échoué, si quelqu'un avait pu inspecter l'intégralité du message, il aurait probablement découvert ce que l'équipe de Google avait fait de mal.

Google reproche au modèle de « devenir » quelque chose qu’il n’était pas « censé » être. Mais ils ont fait le modèle ! C'est comme s'ils cassaient un verre et qu'au lieu de dire « il est tombé », ils disent « il est tombé ».

Les erreurs de ces modèles sont certes inévitables. Ils hallucinent, reflètent des préjugés, se comportent de manière inattendue. Mais la responsabilité de ces erreurs n’incombe pas aux modèles, mais aux personnes qui les ont réalisées. Aujourd'hui, c'est Google. Demain ce sera OpenAI. Le lendemain, et probablement pendant quelques mois d’affilée, ce sera X.AI.

Ces entreprises ont tout intérêt à vous convaincre que l’IA commet ses propres erreurs. Nous ne devons pas laisser cette histoire perdurer.