Nach Telegrafieren des Durchzugs Medienauftritte OpenAI hat hinausgeworfen ein Tool, das versucht, zwischen von Menschen geschriebenem und KI-generiertem Text zu unterscheiden, wie z. B. Text, der von den unternehmenseigenen ChatGPT- und GPT-3-Modellen erstellt wurde. Der Klassifikator ist nicht besonders genau: seine Erfolgsquote liegt bei rund 26 %, stellt OpenAI fest, aber OpenAI argumentiert, dass er in Verbindung mit anderen Methoden nützlich sein könnte, um den Missbrauch von KI-Textgeneratoren zu verhindern.

„Der Klassifikator soll dazu beitragen, falsche Behauptungen zu entkräften, dass KI-generierter Text von einem Menschen geschrieben wurde. Es hat jedoch immer noch eine Reihe von Einschränkungen, daher sollte es als Ergänzung zu anderen Methoden verwendet werden, um die Quelle des Textes zu bestimmen, anstatt das Hauptentscheidungsinstrument zu sein“, sagte ein OpenAI-Sprecher. Wir stellen diesen ersten Klassifikator für Feedback darüber zur Verfügung, ob Tools wie diese sind nützlich und wir freuen uns darauf, verbesserte Methoden zu teilen in der Zukunft.

Da die Begeisterung für generative KI, insbesondere KI, die Text generiert, zunimmt, haben Kritiker die Entwickler dieser Tools aufgefordert, Maßnahmen zu ergreifen, um ihre potenziell schädlichen Auswirkungen zu mindern. Einige der größten Schulbezirke in den Vereinigten Staaten haben ChatGPT aus ihren Netzwerken und Geräten verbannt, weil sie die Auswirkungen auf das Lernen der Schüler und die Genauigkeit der von dem Tool produzierten Inhalte befürchten. Und Websites, die enthalten Stack Overflow hat Benutzer rausgeschmissen der von ChatGPT generierte Inhalte teilte und sagte, dass die KI es den Benutzern zu einfach mache, Diskussionsthreads mit zweifelhaften Antworten zu überfluten.

Der OpenAI-Klassifikator, treffend benannt OpenAI AI-Textklassifikator, ist aus architektonischer Sicht herausfordernd. Wie ChatGPT ist es ein KI-Sprachmodell, das auf vielen, vielen Beispielen von öffentlich verfügbarem Text im Web trainiert wurde. Aber im Gegensatz zu ChatGPT ist es so eingestellt, dass es die Wahrscheinlichkeit vorhersagt, dass die KI einen Text generiert hat, nicht nur von ChatGPT, sondern von jedem KI-Modell, das Text generiert.

Genauer gesagt, OpenAI ermöglichte die OpenAI AI-Textklassifikator in Texten von 34 Inhaltsgenerierungssystemen von fünf verschiedenen Organisationen, einschließlich OpenAI selbst. Dieser Text wurde mit ähnlichem (aber nicht genau ähnlichem) von Menschen geschriebenem Text aus Wikipedia kombiniert, sitios web Auszug aus Links, die auf Reddit geteilt wurden, und einer Reihe von „menschlichen Demos“, die für ein älteres OpenAI-Textgenerierungssystem gesammelt wurden. (OpenAI unterstützt in a Unterstützende Unterlagen dass er jedoch einige von KI geschriebene Texte versehentlich als von Menschen geschrieben klassifiziert haben könnte, "angesichts der Verbreitung von KI-generierten Inhalten im Internet").

Der Textklassifikator OpenAI es funktioniert nicht mit Text, was wichtiger ist. Sie benötigen mindestens 1000 Zeichen oder etwa 150-250 Wörter. Plagiate werden nicht erkannt, eine besonders unglückliche Einschränkung, wenn man bedenkt, dass sich die textgenerierende KI bewährt hat erbrechen der Text, an dem er ausgebildet wurde. Und OpenAI sagt, dass es aufgrund seines englischen Datensatzes wahrscheinlicher ist, sich bei Texten zu irren, die von Kindern oder in einer anderen Sprache als Englisch geschrieben wurden.

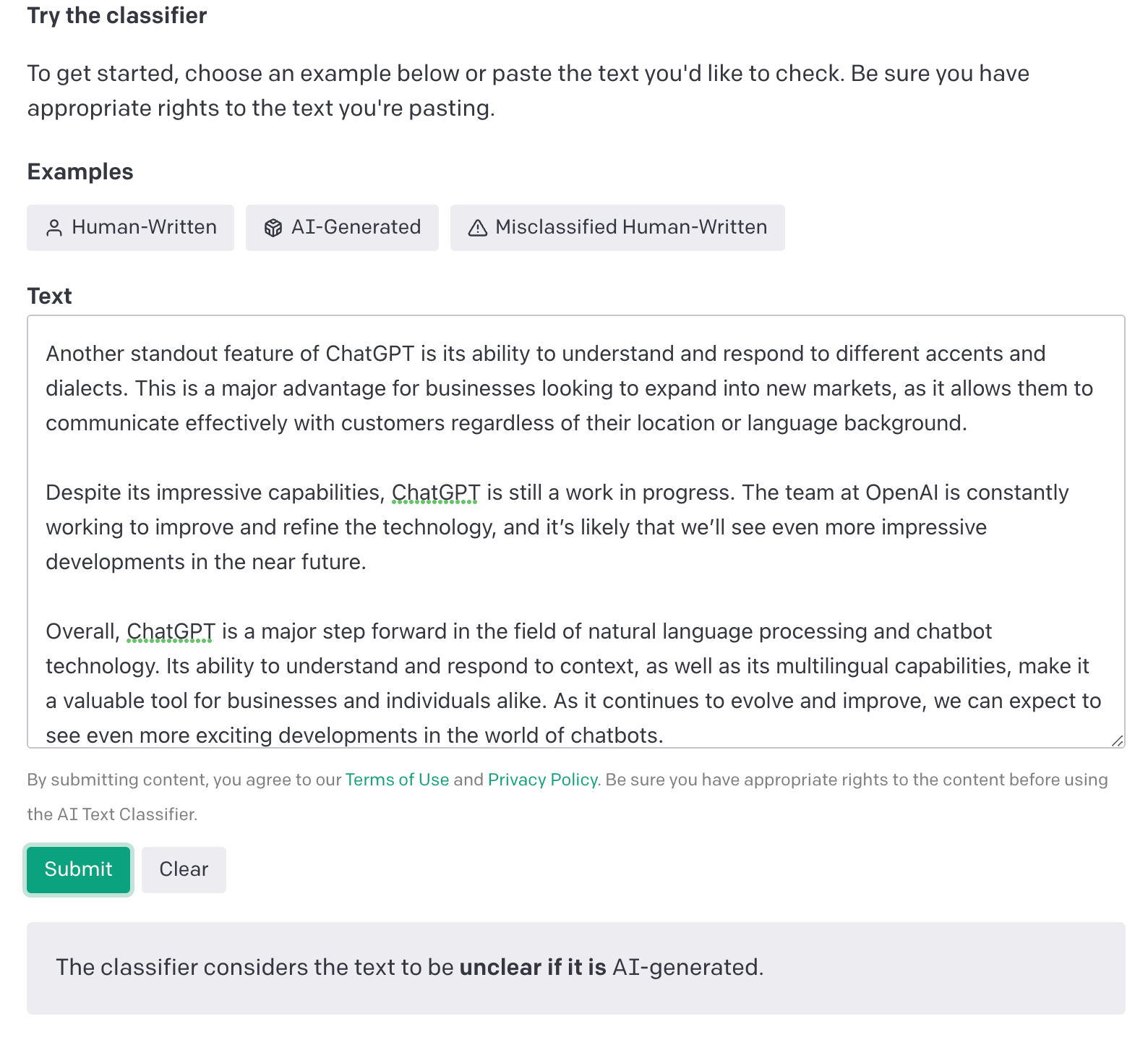

Der Detektor überdeckt seine Antwort etwas, indem er auswertet, ob ein bestimmtes Textstück KI-generiert ist. Abhängig von Ihrem Konfidenzniveau wird der Text als KI-generiert „höchst unwahrscheinlich“ (weniger als 10 % Wahrscheinlichkeit), KI-generiert „unwahrscheinlich“ (10–45 % Wahrscheinlichkeit) und „unklar“ gekennzeichnet, wenn es sich um „KI-generiert“ handelt (Wahrscheinlichkeit 45-90 %), „Möglicherweise“ KI-generiert (Wahrscheinlichkeit 90-98 %) oder „Wahrscheinlich“ KI-generiert (Wahrscheinlichkeit größer als 98 %) .

Aus Neugier ließen wir etwas Text durch den Klassifikator laufen, um zu sehen, wie er funktioniert. Während er richtig und selbstbewusst voraussagte, dass mehrere Absätze eines TRPlanes-Artikels auf Meta Horizon-Welten und ein Ausschnitt einer OpenAI-Supportseite wurden nicht von der KI generiert, der Klassifikator hatte mehr Schwierigkeiten mit dem ChatGPT-Artikellängentext und konnte ihn letztendlich nicht klassifizieren. gesamt. Es hat jedoch erfolgreich die ChatGPT-Ausgabe von einem Gizmodo erkannt Stück über – was sonst? —ChatGPT.

Laut OpenAI kennzeichnet der Klassifikator von Menschen geschriebenen Text in 9 % der Fälle fälschlicherweise als KI-geschrieben. Dieser Fehler trat in den Tests nicht auf, kann aber auf die kleine Stichprobengröße zurückgeführt werden.

Kredite : OpenAI

Auf praktischer Ebene ist der Klassifikator nicht besonders nützlich, um kürzere Schriften zu bewerten. 1000 Zeichen sind eine schwer zu erreichende Schwelle im Nachrichtenbereich, zum Beispiel E-Mails (zumindest die regulären). und hat mehrere Einschränkungen wie OpenAI betont, dass der Klassifikator umgangen werden kann, indem einige Wörter oder Klauseln im generierten Text geändert werden.

Das bedeutet nicht, dass der Klassifikator nutzlos ist, ganz im Gegenteil. Aber es wird engagierte Betrüger (oder Studenten, was das angeht) in seinem derzeitigen Zustand sicherlich nicht aufhalten.

Die Frage ist, wird es andere Tools geben? Eine Art Heimindustrie ist entstanden, um die Nachfrage nach KI-generierten Textdetektoren zu befriedigen. ChatZero, entwickelt von einem Studenten der Princeton University, verwendet Kriterien wie „stumpiness“ (die Komplexität des Textes) und „bursts“ (die Variationen von Sätzen), um festzustellen, ob der Text möglicherweise von KI geschrieben wurde. Der Plagiatsdetektor Turnitin entwickelt einen eigenen KI-generierten Textdetektor. Darüber hinaus ergibt eine Google-Suche mindestens ein halbes Dutzend andere Anwendungen, die behaupten, in der Lage zu sein den KI-erzeugten Weizen von der menschenerzeugten Spreu zu trennen, um das Klischee zu verdrehen.

Es dürfte ein Katz-und-Maus-Spiel werden. Mit der Verbesserung der textgenerierenden KI verbessern sich auch die Detektoren, ein endloses Hin und Her, ähnlich dem zwischen Cyberkriminellen und Sicherheitsforschern. Und wie OpenAI schreibt, können Klassifikatoren zwar unter bestimmten Umständen helfen, aber sie werden niemals ein einziger zuverlässiger Test sein, um zu entscheiden, ob der Text von KI generiert wurde.

Das ist eine Art zu sagen, dass es keine Wunderwaffe gibt, um die Probleme zu lösen, die durch KI-generierten Text entstehen. Es ist sehr wahrscheinlich, dass es das nie geben wird.