Es ist nicht so, dass Nvidia nach den jüngsten Gewinnberichten verzweifelt nach positiver Verstärkung sucht, aber es ist erwähnenswert, wie gut sich die Robotik-Strategie des Unternehmens in den letzten Jahren ausgezahlt hat. Nvidia investierte stark in diesen Bereich zu einer Zeit, als die Integration von Robotik über die Fertigung hinaus für viele noch wie ein Wunschtraum erschien. Im April jährt sich die Markteinführung des TK1 zum zehnten Mal. NVIDIA So beschrieb er damals das Angebot „Jetson TK1 bietet Entwicklern die Fähigkeiten von Tegra K1 in einer kompakten Plattform mit geringem Stromverbrauch, die die Entwicklung so einfach macht wie auf einem PC.“

Diesen Februar wird die Unternehmen mitgeteilt„Eine Million Entwickler auf der ganzen Welt nutzen mittlerweile die Nvidia Jetson-Plattform für modernste KI und Robotik, um innovative Technologien zu entwickeln.“ Darüber hinaus haben mehr als 6.000 Unternehmen (ein Drittel davon Startups) die Plattform in ihre Produkte integriert.“

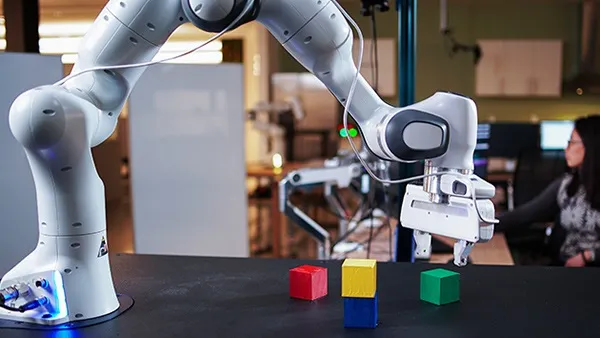

Es wird Ihnen schwer fallen, einen Robotikentwickler zu finden, der sich noch nicht mit der Plattform beschäftigt hat, und ehrlich gesagt ist es bemerkenswert, wie viele Benutzer von Hobbyisten bis hin zu multinationalen Konzernen reichen. Das ist die Art von Verbreitung, für die Unternehmen wie Arduino töten würden.

Die 2018 eröffneten riesigen Büros des Unternehmens in Santa Clara sind vom San Tomas Highway aus nicht zu übersehen. Tatsächlich gibt es eine Fußgängerbrücke, die die Straße überquert und den alten und neuen Hauptsitz verbindet. Der neue Raum besteht im Wesentlichen aus zwei Gebäuden: Voyager und Endeavour, die jeweils 500.000 bzw. 750.000 Quadratfuß groß sind.

Zwischen den beiden befindet sich ein von Bäumen gesäumter Freiluftweg unter großen, kreuz und quer verlaufenden Spalieren, die Sonnenkollektoren tragen. Der Kampf um die Hauptsitze von South Bay Big Tech hat in den letzten Jahren stark zugenommen, aber wenn man effektiv Geld druckt, ist der Kauf von Grundstücken und der Bau von Büros wahrscheinlich der beste Ort, um es auszudrücken. Sie müssen nur Apple, Google und Facebook fragen.

Unterdessen hat Nvidias Einstieg in die Robotik von allerlei Segnungen profitiert. Das Unternehmen kennt sich mit Silizium derzeit so gut aus wie kein anderer, vom Design und der Herstellung bis hin zur Entwicklung von Systemen mit geringem Stromverbrauch, die immer komplexere Aufgaben erfüllen können. Dies ist von entscheidender Bedeutung für eine Welt, die zunehmend in KI und ML investiert. Unterdessen hat sich Nvidias umfangreiches Gaming-Wissen als großer Gewinn für Isaac Sim, seine Robotik-Simulationsplattform, erwiesen. Es ist tatsächlich ein perfekter Sturm.

CEO Jensen Huang erklärte bei SIGGRAPH im August 2023: „Wir haben erkannt, dass die Rasterisierung an ihre Grenzen stößt. 2018 war ein „Wetten Sie auf das Unternehmen“-Moment. Wir mussten die Hardware, die Software und die Algorithmen neu erfinden. Und während wir CG mit KI neu erfanden, erfanden wir die GPU für KI neu.“

Nach einigen Demonstrationen wies Deepu Talla, Vizepräsident und General Manager für Embedded & Edge Computing bei Nvidia, auf ein Cisco-Telefonkonferenzsystem an der Rückwand hin, auf dem die Jetson-Plattform läuft. Es ist weit entfernt von den typischen AMRs, an die wir denken, wenn wir an Jetson denken.

„Die meisten Menschen stellen sich Robotik als etwas Physisches vor, das normalerweise Arme, Beine, Flügel oder Räder hat, was als Wahrnehmung von innen nach außen betrachtet wird“, sagte er und bezog sich dabei auf das Bürogerät. „Genau wie Menschen. Der Mensch verfügt über Sensoren, um unsere Umgebung wahrzunehmen und sich der Situation bewusst zu werden. Es gibt auch etwas, das Outside-In-Robotik genannt wird. Diese Dinger bewegen sich nicht. Stellen Sie sich vor, Sie hätten Kameras und Sensoren in Ihrem Gebäude. Sie können sehen, was passiert. Wir haben eine Plattform namens Nvidia Metropolis. „Es verfügt über Videoanalysen und passt sich an Verkehrskreuzungen, Flughäfen und Einzelhandelsumgebungen an.“

Wie war die erste Reaktion, als das Jetson-System im Jahr 2015 vorgestellt wurde? Es kam von einem Unternehmen, das die meisten Menschen mit Gaming assoziieren.

Ja, obwohl sich das ändert. Aber es war das Richtige. Daran sind die meisten Verbraucher gewöhnt. KI war noch neu, man musste erklären, welchen Anwendungsfall man verstand. Im November 2015 reisten Jensen [Huang] und ich nach San Francisco, um einige Songs vorzustellen. Das Beispiel, das wir hatten, war eine autonome Drohne. Wenn Sie eine autonome Drohne bauen wollten, was wäre dafür nötig? Sie müssten so viele Sensoren haben, Sie müssten so viele Frames verarbeiten, Sie müssten dies identifizieren. Wir haben einige grobe Berechnungen durchgeführt, um herauszufinden, wie viele Berechnungen wir benötigen würden. Und wenn Sie es heute tun möchten, welche Option haben Sie? So etwas gab es damals nicht.

Wie hat die Spielegeschichte von Nvidia Ihre Robotikprojekte beeinflusst?

Als wir das Unternehmen gründeten, waren es Spiele, die uns die Entwicklung von GPUs finanzierten. Anschließend haben wir CUDA zu unseren GPUs hinzugefügt, damit es in Nicht-Grafikanwendungen verwendet werden kann. CUDA hat uns im Wesentlichen zur KI geführt. Jetzt hilft KI Spielen, zum Beispiel dank Raytracing. Schließlich bauen wir Mikroprozessoren mit GPUs. Die gesamte Middleware, über die wir sprechen, ist dieselbe. CUDA gilt für Robotik, Hochleistungsrechnen und Cloud-KI gleichermaßen. Nicht jeder muss alle Funktionen von CUDA nutzen, aber es ist dasselbe.

Wie schneidet Isaac Sim im Vergleich zum Simulator von [Open Robotics] ab?

Gazebo ist ein guter Basissimulator für begrenzte Simulationen. Wir versuchen nicht, Gazebo zu ersetzen. Ein Pavillon eignet sich gut für grundlegende Aufgaben. Wir bieten eine einfache ROS-Brücke, um Gazebo mit Isaac Sim zu verbinden. Aber Isaac kann Dinge tun, die kein anderer tun kann. Es basiert auf Omniverse. Alle Dinge, die Sie in Omniverse haben, kommen zu Isaac Sim. Es ist außerdem so konzipiert, dass es jeden KI-Modus, jedes Framework und alle Dinge, die wir in der realen Welt tun, miteinander verbinden kann. Sie können es anschließen, um eine vollständigere Autonomie zu erreichen. Es hat auch visuelle Wiedergabetreue.

Sie möchten nicht mit ROS konkurrieren (Roboter-Betriebssystem).

Nein nein. Wir versuchen, eine Plattform aufzubauen. Wir möchten mit allen in Kontakt treten und anderen helfen, unsere Plattform genauso zu nutzen, wie wir ihre nutzen. Es hat keinen Sinn, zu konkurrieren.

Arbeiten Sie mit Forschungsuniversitäten zusammen?

Absolut. Dieter Fox ist Leiter der Robotikforschung bei Nvidia. Er ist außerdem Professor für Robotik an der University of Washington. Und viele unserer Forschungsmitglieder haben auch eine doppelte Zugehörigkeit. In vielen Fällen sind sie an Universitäten angeschlossen. Wir veröffentlichen für die gesamte Community. Wenn Sie recherchieren, muss es offen sein.

Arbeiten Sie mit Endbenutzern an Dingen wie der Bereitstellung oder dem Flottenmanagement zusammen?

Wahrscheinlich nicht. Wenn John Deere beispielsweise einen Traktor verkauft, sprechen die Landwirte nicht mit uns. Typischerweise ist das Flottenmanagement. Wir verfügen über Hilfsmittel, um ihnen zu helfen, aber das Flottenmanagement wird von demjenigen übernommen, der die Dienstleistung erbringt oder den Roboter baut.

Wann wurde Robotik für Nvidia zum Puzzleteil?

Ich würde sagen, Anfang der 2010er Jahre. Damals entstand die KI. Ich glaube, das erste Mal, dass Deep Learning auf die Welt kam, war im Jahr 2012. Es wurde geglaubt ein aktuelles Profil über Bryan Catanzaro. Er meldete sich sofort LinkedIn„Ich habe Jensen nicht wirklich überzeugt, sondern ihm lediglich Deep Learning erklärt. Er entwickelte sofort seine eigene Überzeugung und verwandelte Nvidia in ein Unternehmen für künstliche Intelligenz. „Es war inspirierend zu sehen und manchmal kann ich immer noch nicht glauben, dass ich dabei sein durfte, um Nvidias Transformation mitzuerleben.“

2015 begannen wir mit KI nicht nur für die Cloud, sondern auch für EDGE sowohl für Jetson als auch für autonomes Fahren.

Wenn Sie mit Menschen über generative KI sprechen, wie überzeugen Sie sie davon, dass es sich dabei um mehr als nur eine Modeerscheinung handelt?

Ich denke, das spiegelt sich in den Ergebnissen wider. Sie können die Produktivitätssteigerung bereits erkennen. Sie können eine E-Mail für mich verfassen. Es ist nicht ganz richtig, aber ich muss nicht bei Null anfangen. Er gibt mir 70 %. Es gibt offensichtliche Dinge, die Sie bereits erkennen können und die definitiv eine bessere Schrittfunktion darstellen als zuvor. Etwas zusammenzufassen ist nicht perfekt. Ich werde nicht zulassen, dass Sie es lesen und für mich zusammenfassen. Daher sind bereits einige Anzeichen für Produktivitätsverbesserungen erkennbar.