Mit einer Branche Schritt zu halten, die sich so schnell weiterentwickelt wie KI, ist eine schwierige Aufgabe. Bis eine KI dazu in der Lage ist, finden Sie hier eine Zusammenfassung aktueller Themen in der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente.

Deepmind

Das KI-Forschungs- und Entwicklungslabor von Google, Deepmind, warf ein Dokument Darin schlägt er einen Rahmen zur Bewertung der sozialen und ethischen Risiken von KI-Systemen vor.

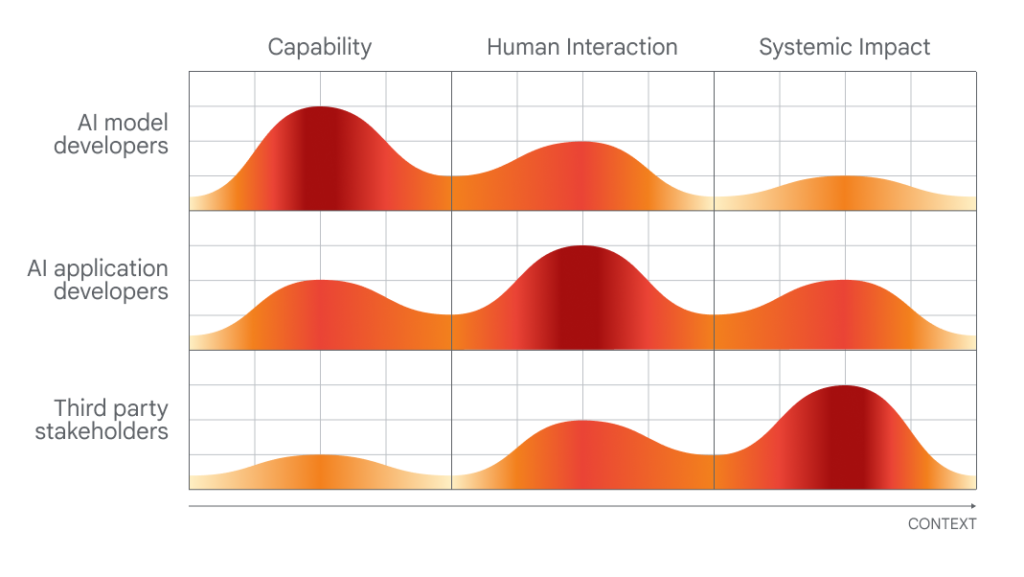

Der Zeitpunkt seiner Veröffentlichung, der ein unterschiedliches Maß an Beteiligung von KI-Entwicklern, Anwendungsentwicklern und „allgemeinen öffentlichen Interessenvertretern“ an der KI-Bewertung und -Prüfung erfordert, ist kein Zufall.

Bald die KI-Sicherheitsgipfel, eine von der britischen Regierung geförderte Veranstaltung, die internationale Regierungen, führende KI-Unternehmen, zivilgesellschaftliche Gruppen und Forschungsexperten zusammenbringt, um sich mit der Frage zu befassen, wie die Risiken der neuesten Fortschritte in der KI am besten bewältigt werden können. einschließlich generativer KI (z. B. ChatGPT, stabile Diffusion usw.). Vereinigtes Königreich ist Planung eine globale Beratungsgruppe für KI nach dem Vorbild des Zwischenstaatlichen Gremiums der Vereinten Nationen für Klimaänderungen einführen, die aus einer rotierenden Gruppe von Wissenschaftlern besteht, die regelmäßig Berichte über die neuesten Entwicklungen in der KI und die damit verbundenen Gefahren verfassen.

DeepMind bringt seine Perspektive im Vorfeld der politischen Gespräche vor Ort auf diesem zweitägigen Gipfel sehr deutlich zum Ausdruck. Und um Anerkennung zu zollen, wo Ehre gebührt, wirft das Forschungslabor einige vernünftige (wenn auch offensichtliche) Punkte auf, wie z. B. die Forderung nach Ansätzen zur Untersuchung von KI-Systemen am „Punkt der menschlichen Interaktion“ und der Art und Weise, wie diese Systeme verwendet werden könnten, und der Auswirkungen auf die Gesellschaft.

Diagramm, das zeigt, welche Personen welche Aspekte der KI am besten beurteilen können.

Aber wenn man die Vorschläge von DeepMind abwägt, ist es aufschlussreich, einen Blick auf die Bewertung der Muttergesellschaft des Labors, Google, zu werfen. in einer Studie veröffentlicht von Stanford-Forschern, in dem die zehn besten KI-Modelle nach ihrem Grad an Offenheit eingestuft werden.

PaLM 100, eines der Flaggschiff-KI-Modelle für die Textanalyse von Google, wurde nach 2 Kriterien bewertet, darunter ob der Hersteller die Quellen seiner Trainingsdaten offengelegt hat, Informationen über die verwendete Hardware, den Trainingsaufwand und andere Details arm 40.%.

Nun hat DeepMind PaLM 2 nicht entwickelt, zumindest nicht direkt. Allerdings hat das Labor in der Vergangenheit seine eigenen Modelle nicht durchgängig transparent gemacht, und die Tatsache, dass die Muttergesellschaft wichtige Transparenzmaßnahmen nicht erfüllt, deutet darauf hin, dass für DeepMind kein großer Druck von oben nach unten besteht, es besser zu machen.

Andererseits scheint DeepMind zusätzlich zu seinen öffentlichen Überlegungen zu Richtlinien Schritte zu unternehmen, um die Wahrnehmung zu ändern, dass es über die Architekturen und internen Abläufe von schweigt ihre Modelle. Das Labor hat sich vor einigen Monaten zusammen mit OpenAI und Anthropic verpflichtet, der britischen Regierung einen „frühzeitigen oder vorrangigen Zugriff“ auf seine KI-Modelle zu gewähren, um die Bewertung und Sicherheitsforschung zu unterstützen.

Die Frage ist: Ist das nur eine Information? Schließlich würde niemand DeepMind Philanthropie vorwerfen: Das Labor erwirtschaftet jedes Jahr Hunderte Millionen Dollar Umsatz, hauptsächlich durch die interne Lizenzierung seiner Arbeit an Google-Teams.

Vielleicht wird der nächste große ethische Test des Labors Gemini sein, sein kommender KI-Chatbot, von dem DeepMind-CEO Demis Hassabis wiederholt versprochen hat, dass er mit ihm mithalten kann ChatGPT von OpenAI in seinen Fähigkeiten. Wenn DeepMind an der ethischen KI-Front ernst genommen werden will, muss es die Schwächen und Grenzen von Gemini vollständig und gründlich beschreiben, nicht nur seine Stärken. Wir werden sicherlich genau beobachten, wie sich die Dinge in den nächsten Monaten entwickeln.

In anderen Nachrichten

Hier sind einige andere bemerkenswerte KI-Geschichten:

- Microsoft-Studie findet Mängel in GPT-4: Eine neue wissenschaftliche Arbeit im Zusammenhang mit Microsoft analysierte die „Zuverlässigkeit“ (und Toxizität) großer Sprachmodelle (LLMs), einschließlich GPT-4 von OpenAI. Die Co-Autoren fanden heraus, dass eine ältere Version von GPT-4 einfacher nach Antworten gefragt werden kann als andere LLMs, die toxische und voreingenommene Texte ausgeben.

- ChatGPT führt Websuchen und DALL-E 3 durch: über OpenAI, das Unternehmen wurde offiziell gestartet seine Internet-Browsing-Funktion für ChatGPT, einige drei Wochen nach der Wiedereinführung der Funktion in der Betaphase nach mehreren Monaten Pause. In verwandten Nachrichten wechselte auch OpenAI von DALL-E3 zur Beta, einen Monat nach der Einführung der neuesten Version des Text-zu-Bild-Generators.

- GPT-4V-Herausforderer: OpenAI wird bald GPT-4V veröffentlichen, eine Variante von GPT-4, die sowohl Bilder als auch Text versteht. Aber zwei Open-Source-Alternativen übertreffen es: LLaVA-1.5 und Fuyu-8B, ein Modell des gut finanzierten Startups Geschickt. Keines davon ist so leistungsfähig wie GPT-4V, aber beide kommen dem nahe und, was noch wichtiger ist, sind kostenlos zu verwenden.

- Kann KI Pokémon spielen?: In den letzten Jahren ein in Seattle ansässiger Softwareentwickler Peter Whidden hat einen Reinforcement-Learning-Algorithmus trainiert, um sich im ersten klassischen Spiel der Pokémon-Reihe zurechtzufinden. Derzeit erreicht er nur Cerulean City, aber Whidden ist zuversichtlich, dass er sich weiter verbessern wird.

- KI-gestützter Sprachlehrer: Google zielt darauf ab Duolingo mit einer neuen Google-Suchfunktion, die Menschen dabei helfen soll, ihre Englischkenntnisse zu üben (und zu verbessern). Die neue Funktion, die in den kommenden Tagen auf Android-Geräten in ausgewählten Ländern eingeführt wird, bietet interaktive Sprechübungen für Sprachlerner, die ins Englische oder aus dem Englischen übersetzen.

- Amazon bringt weitere Lagerroboter auf den Markt: bei einer Veranstaltung, Amazon bekannt das damit beginnen wird, den Agility-Zweibeinroboter in seinen Einrichtungen zu testen, Stelle. Wenn man jedoch zwischen den Zeilen liest, gibt es keine Garantie dafür, dass Amazon tatsächlich mit der Implementierung von Digit in seinen Lagereinrichtungen beginnen wird, in denen derzeit mehr als 750.000 Robotersysteme zum Einsatz kommen.

- Simulatoren über Simulatoren: In derselben Woche demonstrierte Nvidia, wie man ein LLM anwendet, um beim Schreiben von Reinforcement-Learning-Code zu helfen, um einen naiven KI-gesteuerten Roboter bei der besseren Ausführung einer Aufgabe anzuleiten, veröffentlichte Meta Habitat 3.0. Die neueste Version des Metadatensatzes zum Training von KI-Agenten in realistischen Innenumgebungen. Habitat 3.0 bietet menschlichen Avataren die Möglichkeit, den Raum in der virtuellen Realität zu teilen.

- Chinas Tech-Titanen investieren in Rivalen OpenAI: Zhipu AI, ein in China ansässiges Startup, das KI-Modelle entwickelt, die denen von OpenAI und anderen im Bereich der generativen KI Konkurrenz machen, bekannt das in diesem Jahr bislang insgesamt 2.500 Milliarden Yuan (340 Millionen US-Dollar) eingeworben hat. Die Ankündigung erfolgt zu einem Zeitpunkt, an dem die geopolitischen Spannungen zwischen den Vereinigten Staaten und China zunehmen und keine Anzeichen für ein Nachlassen erkennbar sind.

- Die USA drosseln Chinas Lieferung von KI-Chips: Zum Thema geopolitische Spannungen kündigte die Biden-Regierung diese Woche eine Reihe von Maßnahmen zur Eindämmung der militärischen Ambitionen Pekings an, darunter weitere Beschränkungen für Chiplieferungen. künstliche Intelligenz von Nvidia nach China. A800 und H800, die beiden KI-Chips, die Nvidia speziell für den weiteren Versand nach China entwickelt hat werden von diesen neuen Regeln betroffen sein.

- KI-Popsong-Wiederholungen werden viral: erscheint deckt einen merkwürdigen Trend ab: Tiktok-Konten die KI verwenden, um Charaktere wie Homer Simpson dazu zu bringen, Rocksongs aus den 90ern und 2000ern zu singen wie „Smells Like Teen Spirit“. Oberflächlich betrachtet machen sie Spaß, aber die gesamte Übung hat einen dunklen Unterton.

Mehr maschinelles Lernen

Modelle des maschinellen Lernens führen immer wieder zu Fortschritten in den Biowissenschaften. AlphaFold und RoseTTAFold waren Beispiele dafür, wie ein hartnäckiges Problem (Proteinfaltung) mit dem richtigen KI-Modell tatsächlich trivialisiert werden könnte. Jetzt haben David Baker (Erfinder des letztgenannten Modells) und seine Laborkollegen den Vorhersageprozess erweitert, um mehr als nur die Struktur der relevanten Aminosäureketten einzubeziehen. Schließlich existieren Proteine in einer Suppe aus anderen Molekülen und Atomen, und die Vorhersage, wie sie mit im Körper verlorenen Verbindungen oder Elementen interagieren, ist für das Verständnis ihrer tatsächlichen Form und Aktivität von entscheidender Bedeutung. RoseTTAFold All-Atom Es ist ein großer Fortschritt für die Simulation biologischer Systeme.

MIT/Harvard University

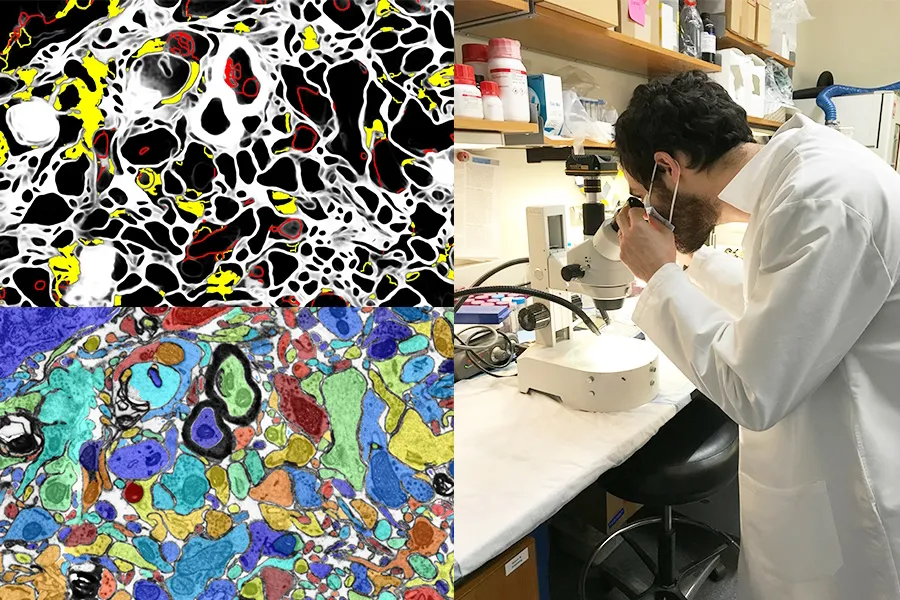

Visuelle KI, die die Arbeit im Labor verbessert oder als Lernwerkzeug dient, ist ebenfalls eine große Chance. Das MIT- und Harvard-SmartEM-Projekt platziert ein Computer-Vision-System und ein ML-Steuerungssystem in einem Rasterelektronenmikroskop, die zusammen das Gerät antreiben, um eine Probe intelligent zu untersuchen. Sie können Bereiche von geringer Bedeutung vermeiden, sich auf interessante oder klare Bereiche konzentrieren und das resultierende Bild auch intelligent beschriften.

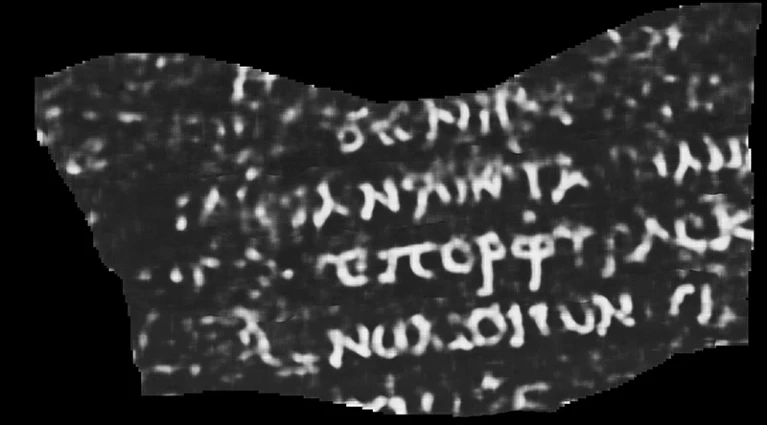

Der Einsatz von KI und anderen High-Tech-Tools für archäologische Zwecke kommt (sozusagen) nie aus der Mode. Ob es sich um einen Lidar (einen Sensor, der kontinuierlich Lichtimpulse aussendet und deren Echos erfasst) handelt, der Maya-Städte und -Straßen freilegt oder die Lücken in unvollständigen antiken griechischen Texten füllt, es ist immer interessant zu beobachten. Und diese Rekonstruktion einer Schriftrolle, von der man annimmt, dass sie bei dem Vulkanausbruch, der Pompeji verwüstete, zerstört wurde, ist eine der beeindruckendsten überhaupt.

ML-interpretierter CT-Scan eines gerollten und verbrannten Papyrus. Das sichtbare Wort lautet „Lila“.

Luke Farritor, ein Informatikstudent an der University of Nebraska-Lincoln, trainierte ein maschinelles Lernmodell, um subtile Muster in Scans des verkohlten, gerollten Papyrus zu verstärken, die für das bloße Auge unsichtbar sind. Ihre Methode war eine von vielen Methoden, die im Rahmen eines internationalen Wettbewerbs zum Lesen der Schriftrollen ausprobiert wurden, und konnte für wertvolle wissenschaftliche Arbeiten verfeinert werden. Die Informationen sind herausgegeben von Nature.. Was stand auf dem Pergament? Bisher nur das Wort „lila“, aber selbst das lässt Papyrologen den Verstand verlieren.

Ein weiterer akademischer Sieg für KI steht bevor dieses System, um Zitate auf Wikipedia zu prüfen und vorzuschlagen. Natürlich weiß die KI nicht, was wahr oder sachlich ist, aber sie kann aus dem Kontext erkennen, wie ein hochwertiger Wikipedia-Artikel und ein Zitat aussehen, und auf der Website und im Web nach Alternativen suchen. Niemand schlägt vor, die berühmte benutzergesteuerte Online-Enzyklopädie von Robotern ausführen zu lassen, aber es könnte dazu beitragen, Artikel zu unterstützen, für die Zitate fehlen oder deren Herausgeber unsicher sind.

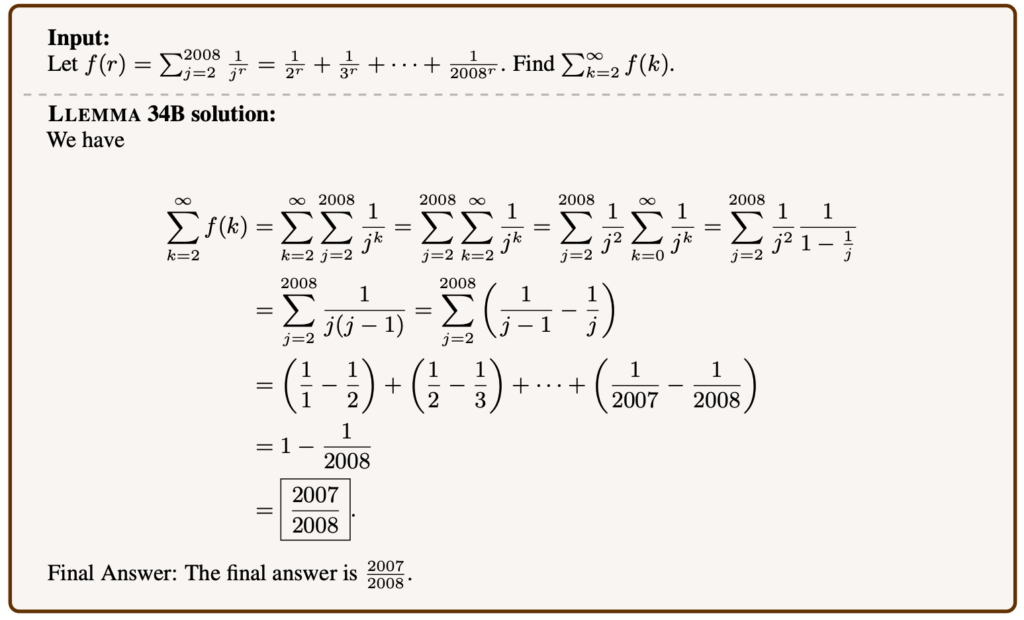

Beispiel eines von Llemma gelösten mathematischen Problems.

Sprachmodelle können für viele Themen optimiert werden, und überraschenderweise ist fortgeschrittene Mathematik eines davon. Llemma ist ein neues offenes Modell auf mathematische Tests und Artikel vorbereitet, die recht komplexe Probleme lösen können. Es ist nicht das erste Mal: Minerva von Google Research arbeitet an ähnlichen Funktionen, aber der Erfolg bei ähnlichen Problemstellungen und die verbesserte Effizienz zeigen, dass „offene“ Modelle (wie auch immer dieser Begriff lautet) in diesem Bereich wettbewerbsfähig sind. Es ist unerwünscht, dass bestimmte Arten von KI von proprietären Modellen dominiert werden. Daher ist die offene Replikation ihrer Fähigkeiten wertvoll, auch wenn sie keine neuen Wege beschreitet.

Es ist besorgniserregend, dass Meta in seiner eigenen akademischen Arbeit Fortschritte in Richtung Gedankenlesen macht, aber wie bei den meisten Studien in diesem Bereich wird der Prozess durch die Art und Weise, wie er präsentiert wird, überbewertet. In einem Artikel mit dem Titel „Brain Decoding: Towards Real-Time Reconstruction of Visual Perception“ Es scheint, als würden sie Gedanken lesen.

Den Menschen gezeigte Bilder (links) und die generative KI erraten, was die Person wahrnimmt (rechts).

Aber es ist etwas indirekter. Durch die Untersuchung, wie ein Hochfrequenz-Gehirnscan aussieht, wenn Menschen Bilder von bestimmten Dingen wie Pferden oder Flugzeugen betrachten, können Forscher nahezu in Echtzeit rekonstruieren, was die Person ihrer Meinung nach denkt oder sieht. Dennoch scheint es wahrscheinlich, dass die generative KI hier eine Rolle spielt, da sie einen visuellen Ausdruck von etwas erzeugen kann, auch wenn dieser nicht direkt mit den Scans übereinstimmt.

¿Wir sollten KI nutzen, um die Gedanken von Menschen zu lesen, wenn das jemals möglich ist? Fragen wir DeepMind (siehe oben).

Endlich ein Projekt in LAION was im Moment eher ehrgeizig als konkret, aber ebenso lobenswert ist. Multilingual Contrastive Learning for Audio Representation Acquisition (CLARA) zielt darauf ab, Sprachmodellen ein besseres Verständnis der Nuancen der menschlichen Sprache zu vermitteln. Wissen wir, wie Sarkasmus oder eine Lüge anhand subverbaler Hinweise wie Tonfall oder Aussprache erkannt werden können? Maschinen sind darin ziemlich schlecht, was für jede Mensch-KI-Interaktion eine schlechte Nachricht ist. CLARA nutzt eine mehrsprachige Audio- und Textbibliothek, um einige emotionale Zustände und andere nonverbale „Sprachverständnis“-Hinweise zu identifizieren.