Letzten Juni, nur wenige Monate nach der Einführung von OpenAIs ChatGPT, nutzten zwei New Yorker Anwälte das Tool auf berüchtigte Weise. schreibe eine sehr schlechte Zusammenfassung. Die KI führte falsche Fälle an, was für Aufruhr, einen verärgerten Richter und zwei sehr verlegene Anwälte sorgte. Es war ein Beweis dafür, dass Bots wie ChatGPT zwar nützlich sein können, man ihre Arbeit jedoch sorgfältig prüfen muss, insbesondere im rechtlichen Kontext.

Der Fall ist den Leuten von LexisNexis nicht entgangen, einem Unternehmen für Rechtssoftware, das Tools anbietet, die Anwälten dabei helfen, die richtige Rechtsprechung für ihre rechtlichen Argumente zu finden. Das Unternehmen sieht das Potenzial von KI, einen Großteil der alltäglichen juristischen Arbeit jedes Anwalts zu reduzieren, erkennt jedoch auch diese sehr realen Probleme, wenn es seine Reise zur generativen KI beginnt.

Jeff Reihl, CTO von LexisNexis, versteht den Wert von KI. Tatsächlich integriert Ihr Unternehmen bereits seit einiger Zeit Technologie in seine Plattform. Aber die Möglichkeit, Ihrer juristischen Toolbox ChatGPT-ähnliche Funktionen hinzuzufügen, würde Anwälten helfen, effizienter zu arbeiten: Es würde ihnen helfen, kurze Texte zu schreiben und Zitate schneller zu finden.

„Wir als Organisation waren es Arbeiten mit Technologien der künstlichen Intelligenz seit einigen Jahren. „Ich denke, was seit der Veröffentlichung von ChatGPT im November wirklich anders ist, ist die Möglichkeit, Text zu generieren und die Konversationsaspekte, die diese Technologie mit sich bringt“, sagte Reihl.

Und obwohl er sieht, dass dies eine leistungsstarke Ebene auf der juristischen Softwarefamilie LexisNexis sein könnte, birgt sie auch Risiken. „Mit der generativen KI werden wir meines Erachtens wirklich die Leistungsfähigkeit und Grenzen dieser Technologie erkennen, was sie gut kann und was nicht“, sagte er. „Und hier glauben wir, dass wir durch die Zusammenführung unserer Fähigkeiten und der Daten, die wir haben, zusammen mit den Fähigkeiten dieser großen Sprachmodelle etwas bewirken können, das die Rechtsbranche grundlegend verändern wird.“

Die Umfrage sagt ...

LexisNexis hat kürzlich 1.000 Anwälte zum Potenzial generativer KI für ihren Beruf befragt. Die Daten zeigten, dass die Menschen größtenteils positiv eingestellt waren, aber sie zeigten auch, dass Anwälte die Schwächen der Technologie erkennen, was die Begeisterung darüber etwas dämpft.

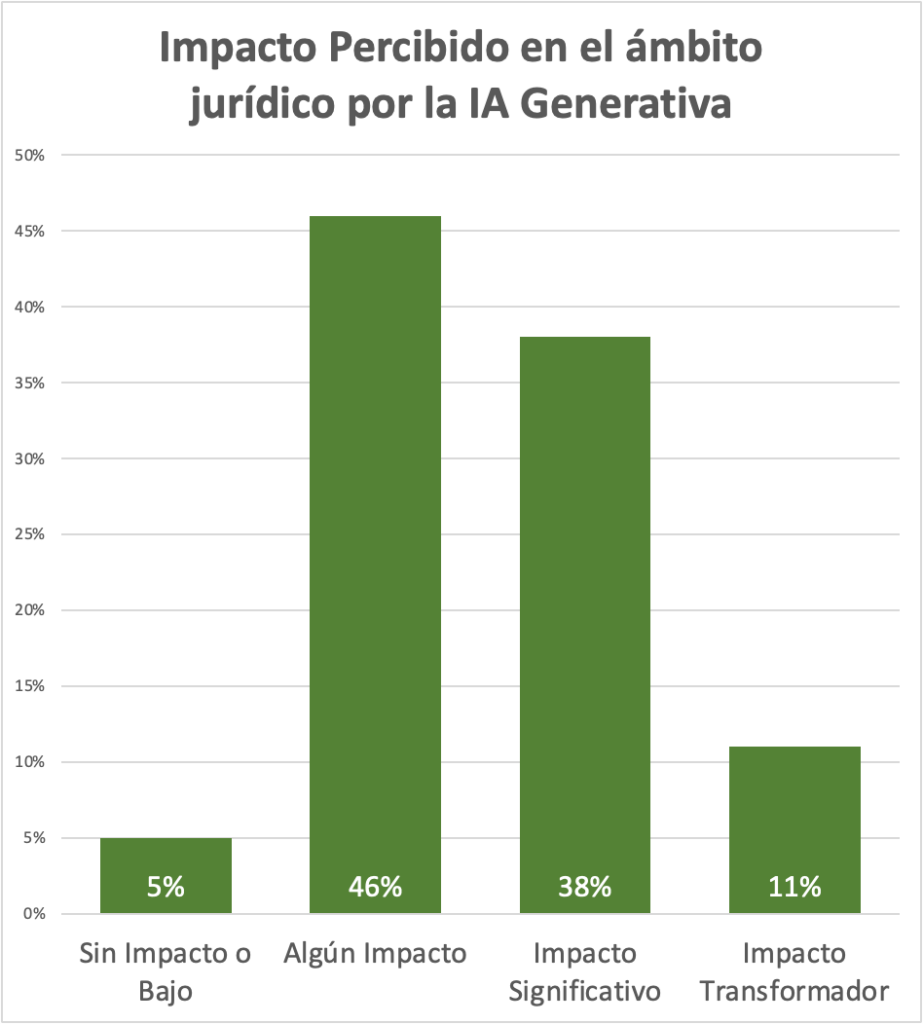

Auf die Frage nach den wahrgenommenen Auswirkungen der generativen KI auf ihren Beruf antworteten beispielsweise 46 % mit einer eher verhaltenen Antwort: „einige Auswirkungen“. Aber die zweithöchste Antwort lautete mit 38 % „erhebliche Auswirkungen“. Dies sind zwar subjektive Meinungen darüber, wie sie eine Technologie nutzen könnten, die noch evaluiert und mit großem Hype gehypt wird, aber die Ergebnisse zeigen, dass die Mehrheit der befragten Anwälte zumindest das Potenzial für generative KI sehen, um zu helfen. Sie machen ihren Job.

Bedenken Sie, dass es bei Umfragen, die von Anbietern durchgeführt werden, immer Raum für Verzerrungen in Bezug auf Fragetypen und Dateninterpretationen gibt. Die Daten sind jedoch nützlich, um allgemein zu sehen, wie Anwälte über die Technologie denken.

Frage zur LexisNexis-Anwaltsumfrage zur Untersuchung der wahrgenommenen Auswirkungen von KI auf die Rechtspraxis.

Bildnachweis: LexisNexis

Eines der Hauptthemen hierbei ist das Vertrauen in die Informationen, die Sie vom Bot erhalten, und LexisNexis arbeitet an mehreren Möglichkeiten, um Vertrauen in die Benutzerergebnisse aufzubauen.

Beheben Sie bekannte KI-Probleme

Das Vertrauensproblem ist eines, mit dem alle Benutzer generativer KI zumindest vorerst konfrontiert sein werden, aber Reihl sagt, sein Unternehmen sei sich darüber im Klaren, was für seine Kunden auf dem Spiel stehe.

„Angesichts ihrer Rolle und ihrer beruflichen Tätigkeit muss das, was sie tun, zu 100 % korrekt sein“, sagte er. „Sie müssen sicherstellen, dass, wenn sie einen Fall zitieren, es sich tatsächlich immer noch um gutes Recht handelt und sie ihre Mandanten auf die richtige Art und Weise vertreten.“

„Wenn sie ihre Mandanten nicht optimal vertreten, könnte ihnen die Anwaltslizenz entzogen werden. Und wir können auf eine Erfolgsbilanz bei der Bereitstellung zuverlässiger Informationen für unsere Kunden zurückblicken.“

Sebastian Berns, ein Doktorand an der Queen Mary University of London, sagte, dass jedes implementierte LLM Halluzinationen hervorrufen werde. Es gibt keine Möglichkeit, dem zu entkommen.

„Ein LLM wird normalerweise so trainiert, dass er immer ein Ergebnis liefert, auch wenn die Eingabe sich stark von den Trainingsdaten unterscheidet“, sagte er. „Ein Standard-LLM hat keine Möglichkeit zu wissen, ob es in der Lage ist, eine Anfrage zuverlässig zu beantworten oder eine Vorhersage zu treffen.“

LexisNexis versucht, dieses Problem auf verschiedene Weise zu entschärfen. Zunächst geht es darum, Modelle mit ihrem eigenen umfangreichen rechtlichen Datensatz zu trainieren, um einige der Zuverlässigkeitsprobleme auszugleichen, die wir bei grundlegenden Modellen gesehen haben. Reihl sagt, dass das Unternehmen auch in den Datenbanken mit der aktuellsten Rechtsprechung arbeitet, sodass es keine zeitlichen Probleme wie bei ChatGPT geben wird, das bis 2021 nur mit Informationen aus dem offenen Web trainiert.

Das Unternehmen ist davon überzeugt, dass die Verwendung relevanterer und aktuellerer Trainingsdaten zu besseren Ergebnissen führen sollte. „Wir können sicherstellen, dass jeder Fall, auf den verwiesen wird, in unserer Datenbank enthalten ist. Daher werden wir kein Zitat veröffentlichen, das kein echter Fall ist, da wir diese Fälle bereits in unserer eigenen Datenbank haben.“

Während unklar ist, ob ein Unternehmen Halluzinationen vollständig beseitigen kann, ermöglicht LexisNexis Anwälten, die die Software verwenden, zuzusehen, wie der Roboter die Antwort findet, indem er einen Verweis auf die Quelle bereitstellt.

„Wir können also die Einschränkungen großer Sprachmodelle angehen, indem wir ihre Leistungsfähigkeit mit unserer Technologie kombinieren und den Benutzern Verweise auf den Fall geben, damit sie ihn selbst validieren können“, sagte Reihl.

Es ist wichtig zu beachten, dass dies noch in Arbeit ist und LexisNexis derzeit mit sechs Kunden zusammenarbeitet, um den Ansatz auf der Grundlage ihres Feedbacks zu verfeinern. Es ist geplant, in den kommenden Monaten KI-gestützte Tools auf den Markt zu bringen.