Lo scorso giugno, pochi mesi dopo il lancio del ChatGPT di OpenAI, una coppia di avvocati di New York ha utilizzato lo strumento in modo tristemente noto. scrivi un riassunto molto scarso. L’AI ha citato casi falsi, provocando scalpore, un giudice arrabbiato e due avvocati molto imbarazzati. Era la prova che, sebbene i bot come ChatGPT possano essere utili, devi davvero controllare attentamente il loro lavoro, soprattutto in un contesto legale.

Il caso non è sfuggito a LexisNexis, una società di software legale che offre strumenti per aiutare gli avvocati a trovare la giusta giurisprudenza per sostenere le loro argomentazioni legali. L’azienda vede il potenziale dell’intelligenza artificiale nel contribuire a ridurre gran parte del banale lavoro legale svolto da ogni avvocato, ma riconosce anche questi problemi molto reali quando inizia il suo percorso di intelligenza artificiale generativa.

Jeff Reihl, CTO di LexisNexis, comprende il valore dell'intelligenza artificiale. In effetti, la tua azienda ha incorporato la tecnologia nella sua piattaforma già da tempo. Ma essere in grado di aggiungere funzionalità simili a ChatGPT alla tua cassetta degli attrezzi legali aiuterebbe gli avvocati a lavorare in modo più efficiente: aiuterebbe con la scrittura breve e a trovare citazioni più velocemente.

“Noi, come organizzazione, lo siamo stati lavorare con le tecnologie di intelligenza artificiale per molti anni. "Penso che ciò che è veramente diverso ora da quando ChatGPT è uscito a novembre è l'opportunità di generare testo e gli aspetti conversazionali che derivano da questa tecnologia", ha affermato Reihl.

E anche se vede che questo potrebbe essere un potente livello in cima alla famiglia di software legale LexisNexis, comporta anche dei rischi. "Con l'intelligenza artificiale generativa, penso che stiamo vedendo, davvero, la potenza e i limiti di quella tecnologia, cosa può e cosa non può fare bene", ha affermato. "Ed è qui che pensiamo che riunendo le nostre capacità e i dati di cui disponiamo, insieme alle capacità di questi grandi modelli linguistici, possiamo fare qualcosa che è fondamentalmente trasformativo per il settore legale."

Il sondaggio dice...

LexisNexis ha recentemente intervistato 1.000 avvocati sul potenziale dell’intelligenza artificiale generativa per la loro professione. I dati hanno mostrato che le persone erano per lo più positive, ma hanno anche rivelato che gli avvocati riconoscono i punti deboli della tecnologia, e questo sta stemperando parte dell’entusiasmo nei suoi confronti.

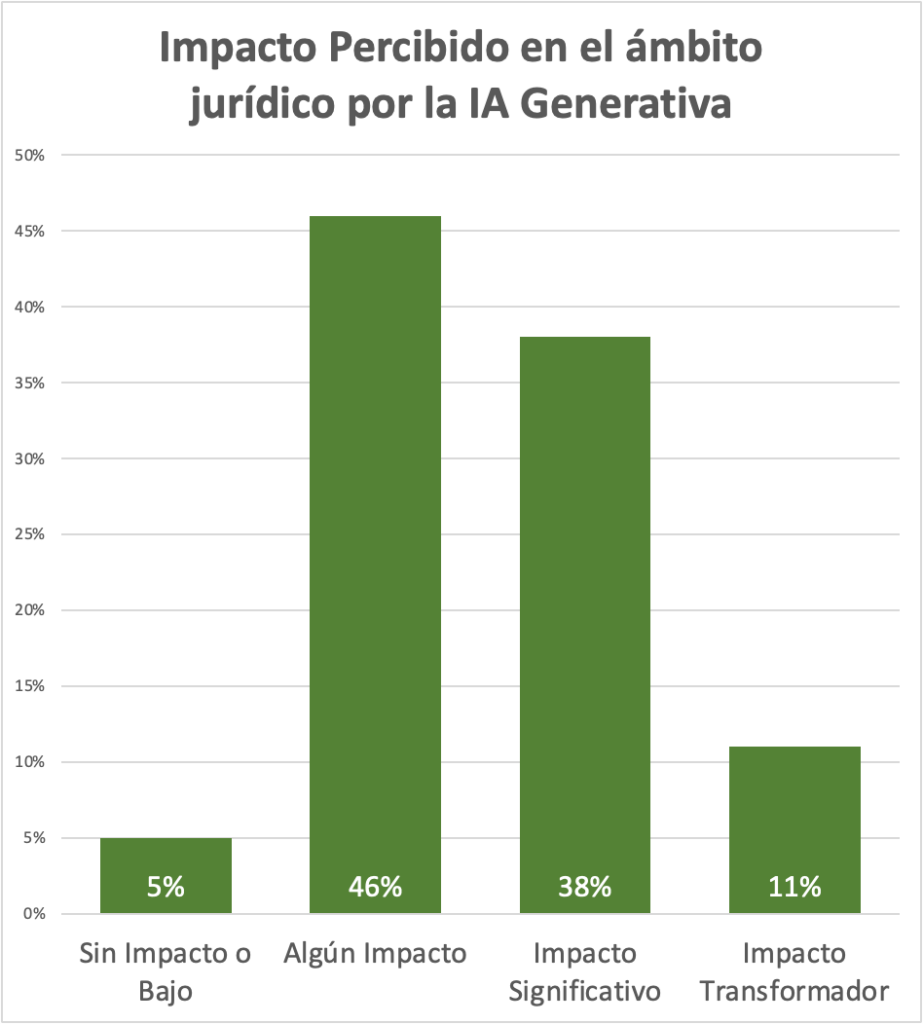

Ad esempio, alla domanda sull’impatto percepito dell’intelligenza artificiale generativa sulla propria professione, il 46% ha risposto con una risposta piuttosto tiepida: “un certo impatto”. Ma la successiva risposta più alta, con il 38%, è stata “un impatto significativo”. Ora, queste sono opinioni soggettive su come potrebbero utilizzare una tecnologia che è ancora in fase di valutazione e pubblicizzata con molto clamore, ma i risultati mostrano che la maggior parte degli avvocati intervistati vede almeno il potenziale di aiuto dell'intelligenza artificiale generativa. Fanno il loro lavoro.

Tieni presente che c'è sempre spazio per pregiudizi in termini di tipi di domande e interpretazioni dei dati quando si tratta di sondaggi condotti dai fornitori, ma i dati sono utili per vedere in termini generali come gli avvocati pensano alla tecnologia.

Sondaggio per avvocati di LexisNexis Domanda che esplora l'impatto percepito dell'intelligenza artificiale sulla pratica legale.

Crediti immagine: LexisNexis

Uno dei problemi chiave in questo caso è la fiducia nelle informazioni ottenute dal bot e LexisNexis sta lavorando su diversi modi per creare fiducia nei risultati degli utenti.

Risolvere i problemi noti dell'IA

Il problema della fiducia è uno di quelli che tutti gli utenti dell’intelligenza artificiale generativa incontreranno, almeno per il momento, ma Reihl afferma che la sua azienda riconosce la posta in gioco per i suoi clienti.

"Dato il loro ruolo e ciò che fanno come professione, ciò che fanno deve essere accurato al 100%", ha affermato. "Devono assicurarsi che, se citano un caso, si tratti effettivamente di una buona legge e rappresentino i loro clienti nel modo giusto."

“Se non rappresentano i loro clienti nel migliore dei modi, potrebbero essere radiati dall’albo. E abbiamo la comprovata capacità di fornire informazioni affidabili ai nostri clienti”.

Sebastian Berns, ricercatore PhD presso la Queen Mary University di Londra, ha affermato che qualsiasi LLM implementato causerà allucinazioni. Non c'è modo di sfuggirgli.

"Un LLM è generalmente addestrato a produrre sempre un risultato, anche quando l'input è molto diverso dai dati di addestramento", ha affermato. "Un LLM standard non ha modo di sapere se è in grado di rispondere in modo affidabile a una domanda o fare una previsione."

LexisNexis sta cercando di mitigare questo problema in diversi modi. Per cominciare, si tratta di addestrare modelli con un vasto set di dati legali per compensare alcuni dei problemi di affidabilità che abbiamo riscontrato con i modelli fondamentali. Reihl afferma che l'azienda sta lavorando anche con la giurisprudenza più recente nei database, quindi non ci saranno problemi di tempistica come con ChatGPT, che si addestrerà solo con le informazioni dal web aperto fino al 2021.

L'azienda ritiene che l'utilizzo di dati di formazione più pertinenti e tempestivi dovrebbe produrre risultati migliori. "Possiamo garantire che ogni caso a cui si fa riferimento sia nel nostro database, quindi non pubblicheremo un preventivo che non sia un caso reale perché abbiamo già quei casi nel nostro database."

Anche se non è chiaro se qualche azienda possa eliminare completamente le allucinazioni, LexisNexis consente agli avvocati che utilizzano il software di guardare il robot trovare la risposta fornendo un riferimento alla fonte.

"Quindi possiamo affrontare quelle limitazioni che hanno i modelli linguistici di grandi dimensioni combinando il potere che hanno con la nostra tecnologia e fornendo agli utenti riferimenti al caso in modo che possano convalidarlo da soli", ha affermato Reihl.

È importante notare che si tratta di un lavoro in corso e LexisNexis sta lavorando con sei clienti in questo momento per perfezionare l'approccio in base al loro feedback. Il piano è quello di lanciare strumenti basati sull’intelligenza artificiale nei prossimi mesi.