Google si è scusato (o è andato vicino a scusarsi) per un altro imbarazzante errore di intelligenza artificiale questa settimana, un modello di generazione di immagini che ha iniettato diversità nelle immagini con un ridicolo disprezzo per il contesto storico. Anche se il problema di fondo è perfettamente comprensibile, Google accusa il modello di “essere diventato troppo sensibile”. Il modello non si è creato da solo, ragazzi di Google.

Il sistema di intelligenza artificiale in questione è Gemini, la piattaforma di intelligenza artificiale conversazionale di punta dell'azienda, che quando richiesto richiama una versione del modello Imagen 2 per creare immagini su richiesta.

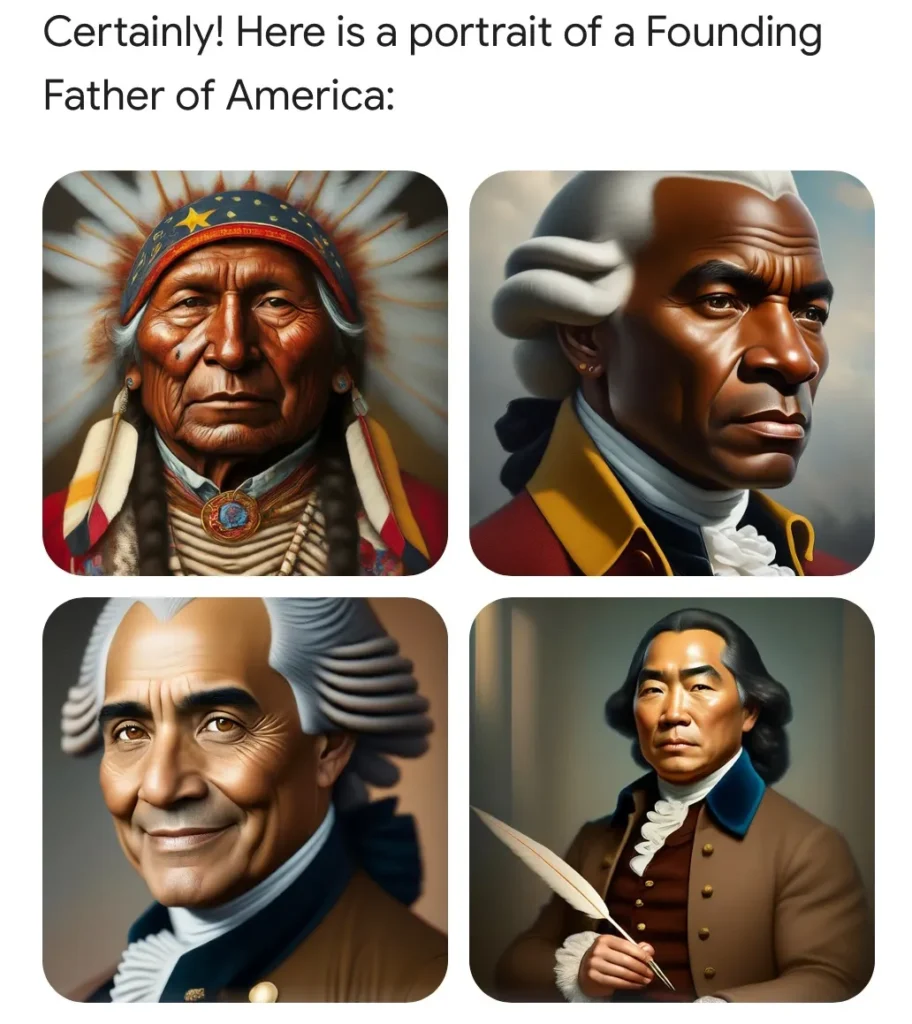

Tuttavia, di recente, gli utenti hanno scoperto che chiedergli di generare immagini di determinate circostanze storiche o persone produceva risultati ridicoli. Ad esempio, i padri fondatori, che sappiamo essere proprietari di schiavi bianchi, furono presentati come un gruppo multiculturale che includeva persone di colore.

Questo problema imbarazzante e facilmente riproducibile è stato rapidamente deriso dagli editori online. Non sorprende che abbia anche alimentato il dibattito in corso su diversità, equità e inclusione (attualmente con una reputazione locale bassa) ed è stato colto dagli esperti come prova che il virus della mente risvegliata sta ulteriormente penetrando nel settore tecnologico già liberale.

Un'immagine generata dall'utente Twitter Patrick Ganley.

È il DEI impazzito, hanno gridato i cittadini chiaramente preoccupati. Questa è l'America di Biden! Google è una “camera di risonanza ideologica”, un cavallo di battaglia della sinistra! (Va notato che anche la sinistra è stata adeguatamente turbata da questo strano fenomeno.)

Ma come può dirti chiunque abbia familiarità con la tecnologia, e come spiega Google nel suo post piuttosto abietto adiacente alle scuse, questo problema è stato il risultato di una soluzione abbastanza ragionevole per la distorsione sistemica nei dati di addestramento.

Supponiamo che tu voglia utilizzare Gemini per creare una campagna di marketing e gli chiedi di generare 10 immagini di "una persona che porta a spasso un cane in un parco". Non essendo specificata la tipologia di persona, cane o parco, la scelta è del dealer: il modello generativo mostrerà ciò che gli è più familiare. E in molti casi, questo non è il prodotto della realtà, ma dei dati di addestramento, che possono contenere tutti i tipi di pregiudizi.

Quali tipi di persone, e in effetti cani e parchi, sono più comuni nelle migliaia di immagini rilevanti che la modella ha acquisito? Il fatto è che i bianchi sono sovrarappresentati in molte di queste raccolte di immagini (immagini stock, foto royalty-free, ecc.) e, di conseguenza, in molti casi il modello utilizzerà automaticamente i bianchi se non lo fai. specificare.

Questo è solo un artefatto dei dati formazione, ma come sottolinea Google, “poiché i nostri utenti provengono da tutto il mondo, vogliamo che funzioni bene per tutti. Se richiedi una foto di giocatori di football o di qualcuno che porta a spasso un cane, potresti voler ricevere una varietà di persone. Probabilmente non vorrai ricevere solo immagini di persone di un solo tipo di etnia (o di qualsiasi altra caratteristica)."

Immagina di chiedere un'immagine come questa: e se fosse tutto un solo tipo di persona? Pessimo risultato!

Non c'è niente di sbagliato nello scattare una foto di un uomo bianco che porta a spasso un golden retriever in un parco di periferia. Ma se ne ordini 10 e lo sono todos Ragazzi bianchi che camminano con i capelli d'oro nei parchi suburbani? E vivi in Marocco, dove le persone, i cani e i parchi sembrano diversi? Questo semplicemente non è un risultato desiderabile. Se qualcuno non specifica una caratteristica, il modello dovrebbe optare per la varietà, non per l'omogeneità, anche se i dati di addestramento potrebbero influenzarlo.

Questo è un problema comune a tutti i tipi di media generativi. E non esiste una soluzione semplice. Ma nei casi particolarmente comuni, sensibili o entrambi, aziende come Google, OpenAI, Anthropic, ecc. includono invisibilmente istruzioni aggiuntive per il modello.

Non posso sottolineare abbastanza quanto sia comune questo tipo di istruzione implicita. L'intero ecosistema LLM si basa su istruzioni implicite: istruzioni di sistema, come vengono talvolta chiamate, in cui al modello vengono fornite cose come "sii conciso", "non dire parolacce" e altre linee guida prima di ogni conversazione. Quando chiedi una battuta, non ottieni una battuta razzista, perché anche se il modello ne ha ingerite migliaia, è stato anche addestrato, come la maggior parte di noi, a non raccontarla. Questa non è un’agenda segreta (anche se potrebbe essere utile una maggiore trasparenza), è un’infrastruttura.

L'errore del modello di Google era che non conteneva istruzioni implicite per le situazioni in cui il contesto storico era importante. Quindi, mentre un messaggio come “una persona che porta a spasso un cane in un parco” viene migliorato dalla silenziosa aggiunta di “la persona appartiene a un genere e un’etnia casuali” o qualunque cosa dicano, “i padri fondatori degli Stati Uniti che” hanno firmato il Costituzione” non è sicuramente migliorata dalle stesse istruzioni.

Come ha affermato il vicepresidente senior di Google, Prabhakar Raghavan:

Innanzitutto, il nostro aggiustamento per garantire che Gemelli mostrasse una varietà di persone non teneva conto dei casi che chiaramente non avrebbero dovuto mostrare una varietà. In secondo luogo, nel tempo, il modello è diventato molto più cauto di quanto intendessimo e si è rifiutato di rispondere del tutto a determinati suggerimenti, interpretando erroneamente alcuni suggerimenti molto blandi come sensibili.

Questi due fattori hanno portato il modello a compensare eccessivamente in alcuni casi e a essere troppo conservatore in altri, portando a immagini imbarazzanti ed errate.

So quanto sia difficile a volte dire "mi dispiace", quindi perdono Prabhakar per non aver avuto il tempo di dirlo. Ancora più importante è il linguaggio interessante che contiene: “Il modello è diventato molto più cauto di quanto intendessimo”.

Ora, come potrebbe un modello “diventare” qualcosa? È un software. Qualcuno (migliaia di ingegneri di Google) lo ha costruito, testato e ripetuto. Qualcuno ha scritto istruzioni implicite che hanno migliorato alcune risposte e hanno fatto sì che altre fallissero in modo esilarante. In caso di esito negativo, se qualcuno fosse stato in grado di esaminare l'intero messaggio, probabilmente avrebbe scoperto cosa ha fatto di sbagliato il team di Google.

Google accusa il modello di “diventare” qualcosa che non era “destinato” a essere. Ma hanno fatto il modello! È come se rompessero un bicchiere e invece di dire "è caduto", dicono "è caduto".

Gli errori di questi modelli sono certamente inevitabili. Hanno allucinazioni, riflettono pregiudizi, si comportano in modi inaspettati. Ma la responsabilità di questi errori non è dei modelli, bensì delle persone che li hanno realizzati. Oggi questo è Google. Domani sarà OpenAI. Il giorno dopo, e probabilmente per qualche mese di fila, sarà X.AI.

Queste aziende hanno tutto l’interesse a convincerti che l’intelligenza artificiale sta commettendo i propri errori. Non dobbiamo lasciare che quella storia rimanga.