O Google se desculpou (ou quase se desculpou) por outro erro embaraçoso de IA esta semana, um modelo de geração de imagens que injetou diversidade nas imagens com um desrespeito ridículo pelo contexto histórico. Embora o problema subjacente seja perfeitamente compreensível, o Google culpa o modelo por “se tornar muito sensível”. O modelo não se fez sozinho, pessoal do Google.

O sistema de IA em questão é o Gemini, a principal plataforma de IA conversacional da empresa, que quando solicitada chama uma versão do modelo Imagen 2 para criar imagens sob demanda.

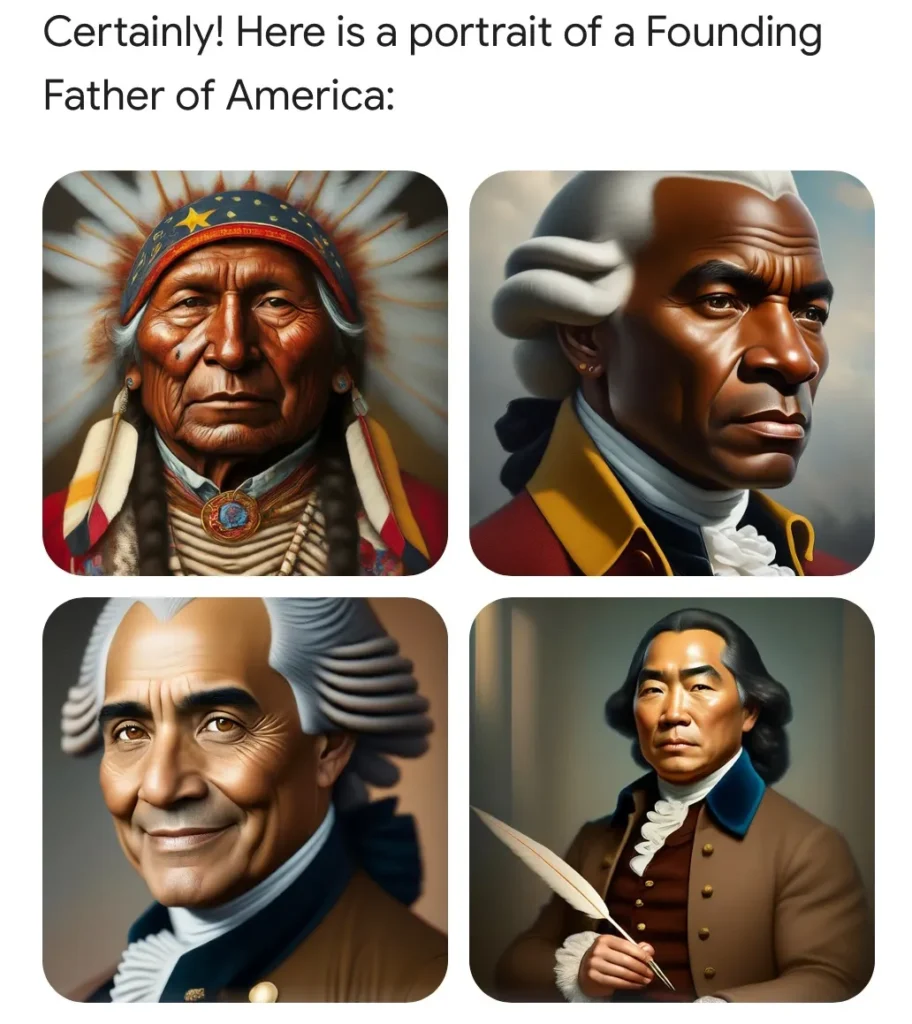

No entanto, recentemente, os usuários descobriram que pedir para gerar imagens de certas circunstâncias históricas ou pessoas produzia resultados ridículos. Por exemplo, os pais fundadores, que sabemos serem proprietários de escravos brancos, foram apresentados como um grupo multicultural que incluía pessoas de cor.

Este problema embaraçoso e facilmente reproduzível foi rapidamente satirizado pelos editores online. Não é de surpreender que também tenha alimentado o debate em curso sobre a diversidade, a equidade e a inclusão (atualmente com uma reputação local baixa) e foi aproveitado pelos especialistas como prova de que o vírus da mente desperta está a penetrar ainda mais no já liberal setor tecnológico.

Uma imagem gerada pelo usuário do Twitter Patrick Ganley.

A DEI enlouqueceu, gritaram cidadãos claramente preocupados. Esta é a América de Biden! O Google é uma “câmara de eco ideológica”, um cavalo de perseguição da esquerda! (Deve-se notar que a esquerda também foi adequadamente perturbada por este estranho fenómeno.)

Mas, como qualquer pessoa familiarizada com a tecnologia poderia lhe dizer, e como o Google explica em seu pequeno post adjacente ao pedido de desculpas, esse problema foi o resultado de uma solução bastante razoável para o viés sistêmico nos dados de treinamento.

Digamos que você queira usar o Gemini para criar uma campanha de marketing e peça para ele gerar 10 imagens de “uma pessoa passeando com um cachorro em um parque”. Como não é especificado o tipo de pessoa, cachorro ou parque, a escolha é do revendedor: o modelo generativo mostrará o que lhe é mais familiar. E, em muitos casos, isso não é produto da realidade, mas de dados de treinamento, que podem conter todos os tipos de preconceitos.

Que tipos de pessoas, e na verdade cães e parques, são mais comuns nas milhares de imagens relevantes que a modelo ingeriu? O fato é que os brancos estão superrepresentados em muitas dessas coleções de imagens (imagens de banco de imagens, fotos livres de royalties, etc.) e, como resultado, o modelo usará os brancos como padrão em muitos casos, se você não o fizer. especificamos.

Isto é apenas um artefato dos dados treinamento, mas como destaca o Google, “como nossos usuários vêm de todo o mundo, queremos que funcione bem para todos. Se você solicitar uma foto de jogadores de futebol ou de alguém passeando com um cachorro, talvez queira receber uma variedade de pessoas. Você provavelmente não deseja receber apenas imagens de pessoas de apenas um tipo de etnia (ou qualquer outra característica).”

Imagine pedir uma imagem assim: e se fosse tudo de um mesmo tipo de pessoa? Resultado ruim!

Não há nada de errado em tirar a foto de um homem branco passeando com um golden retriever em um parque suburbano. Mas se você pedir 10 e eles forem TODOOs caras brancos andam com goldens em parques suburbanos? E você mora no Marrocos, onde as pessoas, os cachorros e os parques são diferentes? Esse simplesmente não é um resultado desejável. Se alguém não especificar um recurso, o modelo deverá optar pela variedade, não pela homogeneidade, mesmo que seus dados de treinamento possam distorcê-lo.

Este é um problema comum em todos os tipos de mídia generativa. E não existe uma solução simples. Mas em casos especialmente comuns, sensíveis ou ambos, empresas como Google, OpenAI, Anthropic, etc. eles incluem invisivelmente instruções adicionais para o modelo.

Não consigo enfatizar o suficiente o quão comum é esse tipo de instrução implícita. Todo o ecossistema LLM é baseado em instruções implícitas: prompts do sistema, como às vezes são chamados, onde o modelo recebe coisas como “seja conciso”, “não xingue” e outras orientações antes de cada conversa. Quando você pede uma piada, você não recebe uma piada racista, porque embora a modelo tenha ingerido milhares delas, ele também foi treinado, como a maioria de nós, para não contar. Esta não é uma agenda secreta (embora precisasse de mais transparência), é infra-estrutura.

O erro do modelo do Google foi que ele não continha instruções implícitas para situações em que o contexto histórico era importante. Assim, embora uma mensagem como “uma pessoa passeando com um cachorro em um parque” seja melhorada pela adição silenciosa de “a pessoa é de um gênero e etnia aleatórios” ou o que quer que digam, “os pais fundadores dos Estados Unidos que “assinaram o Constituição” definitivamente não é melhorada pelas mesmas instruções.

Como disse o vice-presidente sênior do Google, Prabhakar Raghavan:

Primeiro, o nosso ajuste para garantir que Gémeos mostrasse uma variedade de pessoas não levava em conta casos que claramente não deveriam mostrar variedade. E, em segundo lugar, com o tempo, o modelo tornou-se muito mais cauteloso do que pretendíamos e recusou-se a responder a determinadas solicitações, interpretando erradamente algumas solicitações muito brandas como sensíveis.

Estas duas coisas levaram o modelo a compensar em alguns casos e a ser demasiado conservador noutros, levando a imagens embaraçosas e erróneas.

Sei como às vezes é difícil dizer “sinto muito”, então perdôo Prabhakar por não ter conseguido dizer isso. Mais importante é a linguagem interessante que contém: “O modelo tornou-se muito mais cauteloso do que pretendíamos”.

Agora, como poderia um modelo “tornar-se” alguma coisa? É um software. Alguém (milhares de engenheiros do Google) o construiu, testou e repetiu. Alguém escreveu instruções implícitas que melhoraram algumas respostas e fizeram com que outras falhassem de forma hilariante. Quando isso falhou, se alguém tivesse conseguido inspecionar a mensagem inteira, provavelmente teria descoberto o que a equipe do Google fez de errado.

O Google culpa o modelo por “se tornar” algo que não era “destinado” a ser. Mas eles fizeram o modelo! É como se quebrassem um copo e em vez de dizerem “caiu”, dissessem “caiu”.

Os erros destes modelos são inevitáveis, certamente. Eles alucinam, refletem preconceitos, comportam-se de maneiras inesperadas. Mas a responsabilidade por estes erros não é dos modelos, mas sim das pessoas que os cometeram. Hoje isso é o Google. Amanhã será OpenAI. No dia seguinte, e provavelmente por alguns meses seguidos, será X.AI.

Essas empresas têm interesse em convencê-lo de que a IA está cometendo seus próprios erros. Não devemos deixar que essa história permaneça.