Stare al passo con un settore che si evolve con la stessa rapidità dell’intelligenza artificiale è un compito difficile. Quindi, finché un'intelligenza artificiale non sarà in grado di farlo, ecco questo riepilogo degli argomenti recenti nel mondo dell'apprendimento automatico, insieme a ricerche ed esperimenti degni di nota.

Deepmind

Il laboratorio di ricerca e sviluppo AI di proprietà di Google, Deepmind, ha lanciato un file documento in cui propone un quadro per la valutazione dei rischi sociali ed etici dei sistemi di intelligenza artificiale.

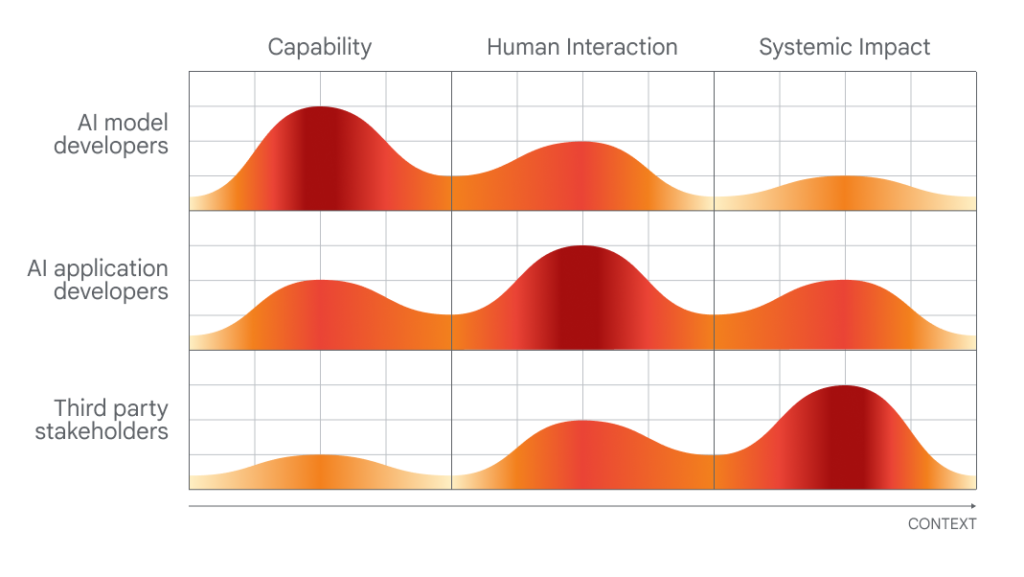

La tempistica del suo rilascio, che richiede diversi livelli di coinvolgimento da parte di sviluppatori di intelligenza artificiale, sviluppatori di applicazioni e “stakeholder in generale” nella valutazione e nel controllo dell’intelligenza artificiale, non è casuale.

Presto il Vertice sulla sicurezza dell’intelligenza artificiale, un evento sponsorizzato dal governo del Regno Unito che riunirà governi internazionali, aziende leader nel campo dell'intelligenza artificiale, gruppi della società civile ed esperti di ricerca per concentrarsi su come gestire al meglio i rischi degli ultimi progressi nel campo dell'intelligenza artificiale. inclusa l'intelligenza artificiale generativa (ad esempio ChatGPT, diffusione stabile, ecc.). Il Regno Unito lo è pianificazione introdurre un gruppo consultivo globale sull’intelligenza artificiale modellato sul Gruppo intergovernativo delle Nazioni Unite sui cambiamenti climatici, composto da un cast di accademici a rotazione che scriverà rapporti regolari sugli sviluppi all’avanguardia dell’intelligenza artificiale e sui pericoli associati.

DeepMind sta esprimendo la sua prospettiva, in modo molto visibile, in vista dei colloqui politici sul campo in questo vertice di due giorni. E, per dare credito laddove è dovuto, il laboratorio di ricerca solleva alcuni punti ragionevoli (anche se ovvi), come la richiesta di approcci per esaminare i sistemi di intelligenza artificiale al “punto di interazione umana” e i modi in cui questi sistemi potrebbero essere utilizzati e l’impatto sulla società.

Grafico che mostra quali persone sarebbero le più brave a valutare quali aspetti dell'intelligenza artificiale.

Ma quando si valutano le proposte di DeepMind, è utile guardare il punteggio della società madre del laboratorio, Google, in uno studio pubblicato dai ricercatori di Stanford che classifica i dieci migliori modelli di intelligenza artificiale in base al loro grado di apertura.

Valutato in base a 100 criteri, incluso se il produttore ha divulgato le fonti dei dati di formazione, le informazioni sull'hardware utilizzato, il lavoro coinvolto nella formazione e altri dettagli, PaLM 2, uno dei modelli AI di analisi del testo di punta di Google, ottiene un povero 40%.

Ora, DeepMind non ha sviluppato PaLM 2, almeno non direttamente. Ma storicamente il laboratorio non è stato costantemente trasparente riguardo ai propri modelli, e il fatto che la sua società madre non riesca a soddisfare le principali misure di trasparenza suggerisce che non c’è molta pressione dall’alto verso il basso affinché DeepMind faccia meglio.

D’altro canto, oltre alle riflessioni pubbliche sulle politiche, DeepMind sembra stia adottando misure per cambiare la percezione secondo cui esso tace sulle architetture e sul funzionamento interno delle società. i loro modelli. Il laboratorio, insieme a OpenAI e Anthropic, si è impegnato diversi mesi fa a fornire al governo del Regno Unito un “accesso anticipato o prioritario” ai suoi modelli di intelligenza artificiale per supportare la valutazione e la ricerca sulla sicurezza.

La domanda è: è solo informativo? Dopotutto, nessuno accuserebbe DeepMind di filantropia: il laboratorio guadagna centinaia di milioni di dollari ogni anno, principalmente concedendo in licenza il suo lavoro internamente ai team di Google.

Forse il prossimo grande test etico del laboratorio sarà Gemini, il suo prossimo chatbot AI, che il CEO di DeepMind Demis Hassabis ha ripetutamente promesso rivaleggerà con ChatGPT di OpenAI nelle sue capacità. Se DeepMind vuole essere preso sul serio sul fronte etico dell’IA, dovrà dettagliare in modo completo e approfondito i punti deboli e i limiti di Gemini, non solo i suoi punti di forza. Sicuramente osserveremo attentamente per vedere come si svilupperanno le cose nei prossimi mesi.

In altre notizie

Ecco alcune altre storie importanti sull'intelligenza artificiale:

- Lo studio Microsoft rileva difetti in GPT-4: Un nuovo articolo scientifico associato a Microsoft ha analizzato l'"affidabilità" (e la tossicità) dei modelli linguistici di grandi dimensioni (LLM), incluso il GPT-4 di OpenAI. I coautori hanno scoperto che è possibile chiedere risposte a una versione precedente di GPT-4 più facilmente rispetto ad altri LLM che producono testi tossici e distorti.

- ChatGPT esegue ricerche web e DALL-E 3: su OpenAI, l'azienda ha lanciato formalmente la sua funzionalità di navigazione in Internet per ChatGPT, alcuni tre settimane dopo la reintroduzione della funzionalità in beta dopo diversi mesi di pausa. Nelle notizie correlate, anche OpenAI è passato da DALL-MI3 alla beta, un mese dopo aver introdotto l'ultima incarnazione del generatore di testo in immagine.

- Sfidanti GPT-4V: OpenAI rilascerà presto GPT-4V, una variante di GPT-4 che comprende sia immagini che testo. Ma due alternative open source lo battono sul tempo: LLaVA-1.5 e Fuyu-8B, un modello di startup ben finanziata Abile. Nessuno dei due ha le stesse prestazioni del GPT-4V, ma entrambi si avvicinano e, cosa più importante, sono gratuiti.

- L'intelligenza artificiale può giocare ai Pokémon?: Negli ultimi anni, un ingegnere informatico con sede a Seattle Peter Whidden ha addestrato un algoritmo di apprendimento per rinforzo per navigare nel primo gioco classico della serie Pokémon. Attualmente raggiunge solo Cerulean City, ma Whidden è fiducioso che continuerà a migliorare.

- Tutor di lingua basato sull'intelligenza artificiale: Google prende di mira Duolingo con una nuova funzionalità di ricerca Google progettata per aiutare le persone a praticare (e migliorare) le proprie abilità di lingua inglese. La nuova funzionalità, disponibile nei prossimi giorni sui dispositivi Android in paesi selezionati, fornirà esercitazioni di conversazione interattive per gli studenti di lingue che traducono da o verso l'inglese.

- Amazon lancia più robot di magazzino: ad un evento, Amazon ha annunciato che inizierà a testare il robot bipede Agility nelle proprie strutture, Cifra. Tuttavia, leggendo tra le righe, non vi è alcuna garanzia che Amazon inizi effettivamente a implementare Digit nei suoi magazzini, che attualmente utilizzano più di 750.000 sistemi robotici.

- Simulatori sui simulatori: La stessa settimana in cui Nvidia ha dimostrato come applicare un LLM per aiutare a scrivere codice di apprendimento di rinforzo per guidare un ingenuo robot basato sull'intelligenza artificiale a eseguire meglio un compito, Meta ha rilasciato Habitat 3.0. L'ultima versione del set di metadati per l'addestramento degli agenti IA in ambienti interni realistici. Habitat 3.0 aggiunge la possibilità per gli avatar umani di condividere lo spazio nella realtà virtuale.

- I titani tecnologici cinesi investono nella rivale OpenAI: Zhipu AI, una startup con sede in Cina che sviluppa modelli di intelligenza artificiale per rivaleggiare con quelli di OpenAI e altri nello spazio dell'intelligenza artificiale generativa, ha annunciato che quest’anno ha raccolto finanziamenti totali per 2.500 miliardi di yuan (340 milioni di dollari). L’annuncio arriva mentre le tensioni geopolitiche tra Stati Uniti e Cina aumentano e non mostrano segni di attenuazione.

- Gli Stati Uniti soffocano la fornitura di chip AI alla Cina: In tema di tensioni geopolitiche, l’amministrazione Biden ha annunciato questa settimana una serie di misure per frenare le ambizioni militari di Pechino, comprese ulteriori restrizioni sulle spedizioni di chip. intelligenza artificiale da Nvidia alla Cina. A800 e H800, i due chip AI che Nvidia ha progettato appositamente per continuare a spedire in Cina e così via saranno interessati da queste nuove regole.

- I replay delle canzoni pop dell'intelligenza artificiale diventano virali: appare copre una tendenza curiosa: account tiktok che usano l'intelligenza artificiale per far cantare a personaggi come Homer Simpson canzoni rock degli anni '90 e 2000 come "Smells Like Teen Spirit”. Sono divertenti in superficie, ma c'è un sottofondo oscuro nell'intera pratica.

Più apprendimento automatico

I modelli di apprendimento automatico portano costantemente a progressi nelle scienze della vita. AlphaFold e RoseTTAFold erano esempi di come un problema persistente (il ripiegamento delle proteine) potesse, di fatto, essere banalizzato con il giusto modello di intelligenza artificiale. Ora David Baker (creatore di quest’ultimo modello) e i suoi colleghi di laboratorio hanno ampliato il processo di previsione per includere qualcosa di più della semplice struttura delle catene di amminoacidi rilevanti. Dopotutto, le proteine esistono in un miscuglio di altre molecole e atomi, e prevedere come interagiranno con i composti o gli elementi persi nel corpo è essenziale per comprenderne la forma e l’attività effettive. RoseTTAFold All-Atom È un grande passo avanti per la simulazione dei sistemi biologici.

MIT/Università di Harvard

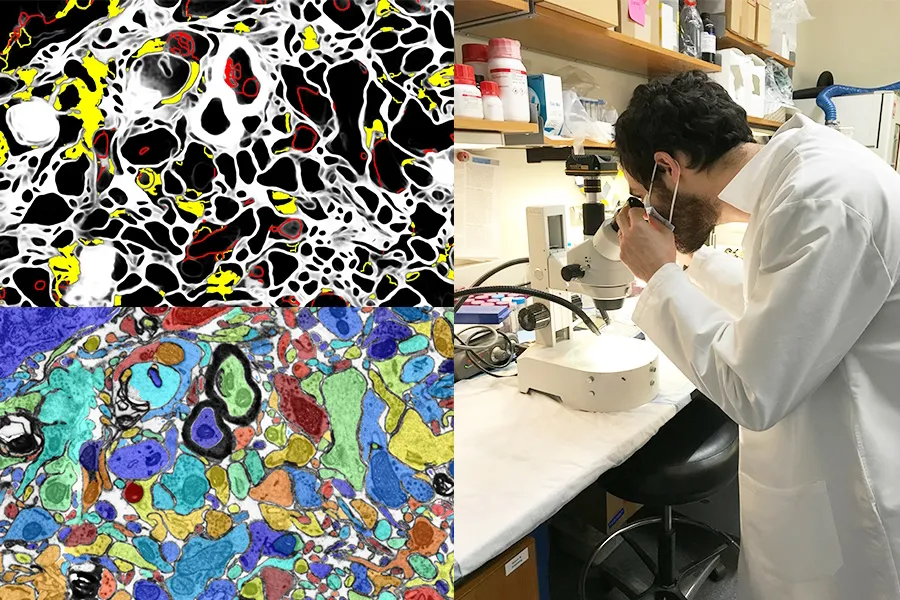

Anche disporre di un’intelligenza artificiale visiva che migliora il lavoro di laboratorio o funge da strumento di apprendimento è una grande opportunità. Il progetto SmartEM del MIT e Harvard posiziona un sistema di visione artificiale e un sistema di controllo ML all'interno di un microscopio elettronico a scansione, che insieme guidano il dispositivo per esaminare in modo intelligente un campione. È possibile evitare aree di scarsa importanza, concentrarsi su aree interessanti o chiare e anche etichettare in modo intelligente l'immagine risultante.

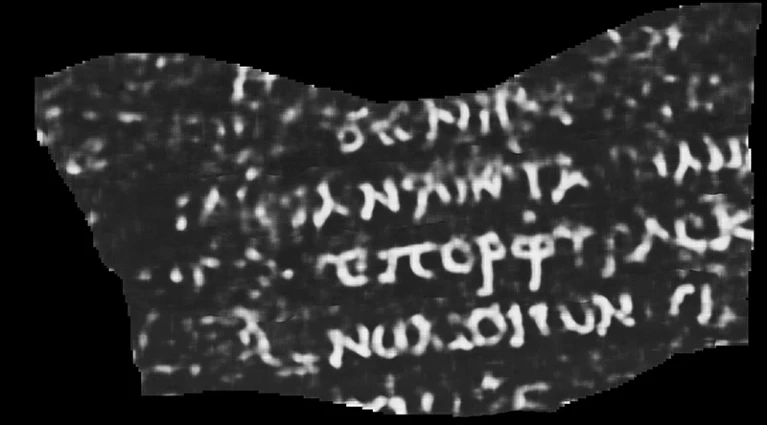

L’uso dell’intelligenza artificiale e di altri strumenti high-tech per scopi archeologici non passa mai di moda (per così dire). Che si tratti di un lidar (un sensore che emette continuamente impulsi di luce e ne cattura i ritorni) che rivela città e strade Maya o riempie le lacune di testi greci antichi incompleti, è sempre interessante da guardare. E questa ricostruzione di un rotolo che si ritiene sia andato distrutto nell'eruzione vulcanica che devastò Pompei è una delle più impressionanti mai realizzate.

Scansione TC interpretata con ML di un papiro arrotolato e bruciato. La parola visibile dice "Viola".

Luke Farritor, uno studente di informatica presso l'Università del Nebraska-Lincoln, ha addestrato un modello di apprendimento automatico per amplificare i modelli sottili nelle scansioni del papiro arrotolato e carbonizzato che sono invisibili a occhio nudo. Il loro era uno dei tanti metodi tentati in una sfida internazionale per leggere i rotoli e potrebbe essere perfezionato per un prezioso lavoro accademico. L'informazione è pubblicato da Natura.. Cosa c'era sulla pergamena? Per ora solo la parola “viola”, ma anche quella fa impazzire i papirologi.

Un’altra vittoria accademica per l’intelligenza artificiale è arrivata questo sistema per esaminare e suggerire citazioni su Wikipedia. Naturalmente, l'intelligenza artificiale non sa cosa sia vero o fattuale, ma può dedurre dal contesto l'aspetto di un articolo e di una citazione di Wikipedia di alta qualità e cercare alternative sul sito e sul web. Nessuno suggerisce di lasciare che i robot gestiscano la famosa enciclopedia online guidata dagli utenti, ma potrebbe aiutare a rafforzare gli articoli per i quali mancano le citazioni o gli editori non sono sicuri.

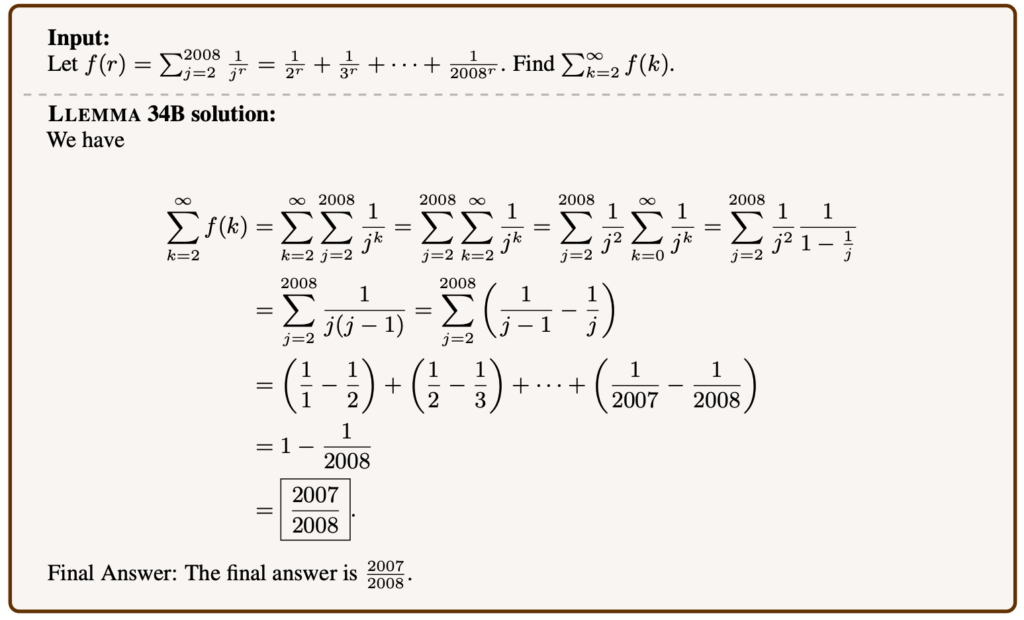

Esempio di problema matematico risolto da Llemma.

I modelli linguistici possono essere perfezionati su molti argomenti e, sorprendentemente, la matematica avanzata è uno di questi. Llemma è un nuovo modello aperto preparato per test e articoli matematici in grado di risolvere problemi piuttosto complessi. Non è il primo: Minerva di Google Research sta lavorando su capacità simili, ma il suo successo su serie di problemi simili e una maggiore efficienza dimostrano che i modelli "aperti" (qualunque cosa sia il termine) sono competitivi in questo spazio. Non è auspicabile che alcuni tipi di intelligenza artificiale siano dominati da modelli proprietari, quindi la replica aperta delle loro capacità è preziosa anche se non apre nuove strade.

È preoccupante che Meta stia facendo progressi nel suo lavoro accademico verso la lettura del pensiero, ma come per la maggior parte degli studi in quest’area, il modo in cui viene presentato sovrastima il processo. In un articolo intitolato “Decodificazione del cervello: verso la ricostruzione in tempo reale della percezione visiva”, Può sembrare che leggano nel pensiero.

Immagini mostrate alle persone (a sinistra) e l'intelligenza artificiale generativa indovina ciò che la persona sta percepindo (a destra).

Ma è un po' più indiretto di così. Studiando come appare una scansione cerebrale ad alta frequenza quando le persone guardano le immagini di determinate cose, come cavalli o aeroplani, i ricercatori possono fare ricostruzioni quasi in tempo reale di ciò che pensano che la persona stia pensando o guardando. Tuttavia, sembra probabile che l'intelligenza artificiale generativa abbia un ruolo da svolgere qui, nel modo in cui può creare un'espressione visiva di qualcosa, anche se non corrisponde direttamente alle scansioni.

¿Dovremmo Usare l'intelligenza artificiale per leggere la mente delle persone, se mai sarà possibile? Chiediamo a DeepMind (vedi sopra).

Finalmente un progetto in LAION che per il momento è più aspirazionale che concreto, ma altrettanto lodevole. Multilingual Contrastive Learning for Audio Representation Acquisition, o CLARA, mira a fornire ai modelli linguistici una migliore comprensione delle sfumature del linguaggio umano. Sappiamo come il sarcasmo o una bugia possano essere rilevati da segnali subverbali come il tono o la pronuncia? Le macchine sono piuttosto pessime in questo, il che è una brutta notizia per qualsiasi interazione uomo-intelligenza artificiale. CLARA utilizza una libreria audio e di testo multilingue per identificare alcuni stati emotivi e altri segnali non verbali di “comprensione del parlato”.