Um humano escreveu isso, ou ChatGPT? Pode ser difícil saber, talvez muito difícil, pensa seu criador OpenAI, e é por isso que está trabalhando em uma maneira de "marcar" o conteúdo gerado por IA.

Num conferência na Universidade de Austin, o professor de ciência da computação Scott Aaronson, atualmente pesquisador visitante na OpenAI, revelou que uma ferramenta está sendo desenvolvida para “marcar estatisticamente os resultados de um texto de IA”. Sempre que um sistema, por exemplo o ChatGPT, gera texto, a ferramenta incorpora um "sinal secreto prateado" que indica de onde veio o texto.

o engenheiro de OpenAIHendrik Kirchner construiu um protótipo funcional, diz Aaronson, e a esperança é incorporá-lo em sistemas futuros desenvolvidos por OpenAI.

“Queremos tornar muito mais difícil pegar uma saída de IA e passá-la como proveniente de um humano”, disse Aaronson em seus comentários. “Isso pode ser útil para prevenir o plágio acadêmico, obviamente, mas também, por exemplo, geração de propaganda em massa, você sabe, enviar spam a todos os blogs com comentários aparentemente sobre o assunto apoiando a invasão russa da Ucrânia sem nem mesmo um prédio cheio de trolls em Moscou, ou personificando o estilo de escrita de alguém para enquadrá-lo."

Explorando a aleatoriedade

Por que a necessidade de uma marca d'água? ChatGPT é um bom exemplo. O chatbot desenvolvido por OpenAI ele conquistou a internet, exibindo uma aptidão não apenas para responder a perguntas desafiadoras, mas também para escrever poesia, resolver quebra-cabeças de programação e tornar-se poético em uma série de assuntos filosóficos.

Embora o ChatGPT seja muito divertido e realmente útil, o sistema levanta questões éticas óbvias. Como muitos dos sistemas de geração de texto anteriores, o ChatGPT pode ser usado para escrever e-mails de phishing de alta qualidade e malware prejudicial ou trapacear em tarefas escolares. E como uma ferramenta de resposta a perguntas, é factualmente inconsistente, uma falha que levou à programação do site de perguntas e respostas Stack Overflow banindo as respostas originárias do ChatGPT até novo aviso.

Para entender os fundamentos técnicos da ferramenta de marca d'água OpenAI, é útil saber por que sistemas como o ChatGPT funcionam tão bem. Esses sistemas entendem o texto de entrada e saída como strings de "tokens", que podem ser palavras, mas também sinais de pontuação e partes de palavras. Em essência, os sistemas estão constantemente gerando uma função matemática chamada distribuição de probabilidade para decidir o próximo token (por exemplo, palavra) a ser gerado, levando em consideração todos os tokens emitidos anteriormente.

No caso de sistemas hospedados em OpenAI como ChatGPT, depois que a distribuição é construída, o servidor de chat OpenAI faz o trabalho de amostragem de tokens de acordo com a distribuição. Há alguma aleatoriedade nesta seleção; é por isso que a mesma mensagem de texto pode gerar uma resposta diferente.

A ferramenta de marca d'água OpenAI ele atua como um "invólucro" sobre os sistemas de geração de texto existentes, disse Aaronson durante a conferência, aproveitando uma função criptográfica que é executada no nível do servidor para selecionar "pseudo-aleatoriamente" o próximo token. Em teoria, o texto gerado pelo sistema ainda pareceria aleatório para você ou para mim, mas qualquer um que tivesse a "chave" do recurso criptográfico poderia descobrir uma marca d'água.

“Empiricamente, algumas centenas de tokens parecem ser suficientes para obter um sinal razoável de que sim, este texto vem de um sistema de IA. Em princípio, você poderia até pegar um texto longo e isolar quais partes provavelmente vêm do sistema de IA e quais provavelmente não.” disse Aaronson. “A ferramenta pode fazer a marca d'água usando uma chave secreta e pode verificar a marca d'água usando a mesma chave.”

principais limitações

A marca d'água de texto gerada por IA não é uma ideia nova. Tentativas anteriores, principalmente baseadas em regras, contaram com técnicas como substituições de sinônimos e mudanças de palavras específicas da sintaxe. Mas fora do teórico o relatório de investigação publicado pelo instituto alemão CISPA em março passado, em OpenAI parece ser uma das primeiras abordagens baseadas em criptografia para o problema.

Quando contatado para comentar, Aaronson se recusou a revelar mais sobre o protótipo da marca d'água, exceto que ele espera ser coautor de um trabalho de pesquisa nos próximos meses. OpenAI ele também recusou, dizendo apenas que a marca d'água está entre as várias "técnicas de proveniência" que está explorando para detectar resultados gerados por IA.

No entanto, acadêmicos não afiliados e especialistas do setor compartilharam opiniões divergentes. Eles apontam que a ferramenta é do lado do servidor, o que significa que não funcionaria necessariamente com todos os sistemas de geração de texto. E eles argumentam que seria trivial para os adversários evitá-lo.

"Acho que seria muito fácil contornar isso reformulando a frase, usando sinônimos, etc.", disse Srini Devadas, professor de ciência da computação no MIT. "Isso é meio que um cabo de guerra."

Jack Hessel, cientista pesquisador do Allen Institute for AI, observou que seria difícil obter impressões digitais imperceptíveis de texto gerado por IA porque cada token é uma escolha discreta. Uma impressão digital muito óbvia pode resultar na escolha de palavras estranhas que degradam a fluência, enquanto uma impressão digital muito sutil deixaria margem para dúvidas na busca pela impressão digital.

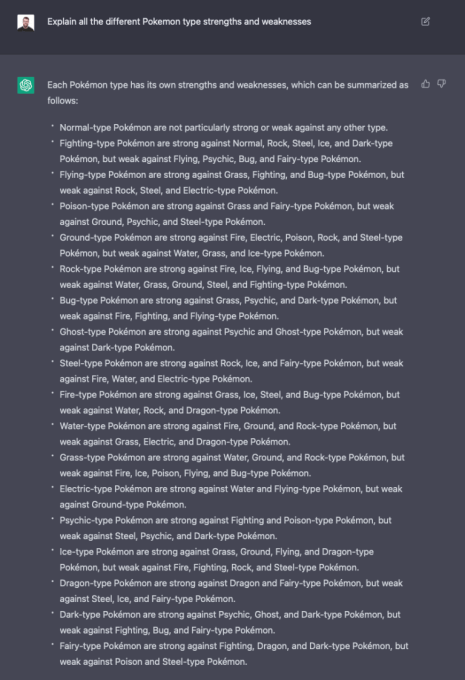

ChatGPT respondendo a uma pergunta.

Yoav Shoham, cofundador e coCEO da AI21 Labs, rival da OpenAI, não acredita que a marca d'água estatística seja suficiente para ajudar a identificar a origem do texto gerado por IA. Ele pede uma abordagem "mais abrangente" que inclua marcas d'água diferenciais, nas quais diferentes partes do texto são marcadas de maneira diferente, e sistemas de IA que citam com mais precisão as fontes do texto factual.

Essa técnica específica de marca d'água também requer muita confiança e poder em OpenAIos especialistas apontaram.

“Uma impressão digital ideal não seria perceptível por um leitor humano e permitiria uma detecção altamente confiável”, disse Hessel por e-mail. "Dependendo de como está configurado, pode ser que OpenAI é a única parte capaz de fornecer essa detecção com confiança devido à forma como o processo de 'assinatura' funciona."

Em sua palestra, Aaronson reconheceu que o esquema realmente só funcionaria em um mundo onde empresas como OpenAI eles estão na vanguarda da expansão de sistemas de ponta e todos concordam em ser jogadores responsáveis. Ainda que OpenAI compartilhou a ferramenta de marca d'água com outros provedores de sistemas de geração de texto, como Cohere e AI21Labs, isso não impediria que outros optassem por não usá-la.

"Se se tornar um jogo de todos contra todos, muitas das medidas de segurança se tornarão mais difíceis e podem até ser impossíveis, pelo menos sem regulamentação do governo", disse Aaronson. “Em um mundo onde qualquer um poderia construir seu próprio modelo de texto tão bom quanto o ChatGPT, por exemplo… O que poderia ser feito aí?”

É assim que funciona no reino do texto para imagem. A diferença de OpenAI, cujo sistema de imagem DALL-E 2 está disponível apenas por meio de uma API, a Stability AI abriu sua tecnologia de texto para imagem (chamada Stable Diffusion). Embora o DALL-E 2 tenha vários filtros no nível da API para evitar a geração de imagens problemáticas (além de marcas d'água nas imagens que gera), o Stable Diffusion de código aberto não. Atores mal-intencionados o usaram para criar pornografia falsa, entre outras toxicidades.

De sua parte, Aaronson está otimista. Na conferência, ele expressou a crença de que, se OpenAI pode demonstrar que as marcas d'água funcionam e não afetam a qualidade do texto gerado, tem o potencial de se tornar um padrão da indústria.

Nem todo mundo concorda. Como aponta Devadas, a ferramenta requer uma chave, o que significa que não pode ser totalmente de código aberto, o que pode limitar sua adoção a organizações que concordam em fazer parceria com ela. OpenAI. (Se a chave fosse tornada pública, qualquer um poderia adivinhar o padrão por trás das marcas d'água, frustrando seu propósito.)

Mas pode não ser tão improvável. Um representante do Quora disse que a empresa estaria interessada em usar tal sistema e que provavelmente não seria o único.

“Você pode se preocupar que todo esse negócio de tentar ser seguro e responsável ao dimensionar a IA… disse Aaronson. “Por outro lado, vimos nos últimos 30 anos que grandes empresas de Internet podem concordar com certos padrões mínimos, seja por medo de ser processado, por desejo de ser visto como um jogador responsável ou por qualquer outro motivo . razão".

Postagem muito boa. Acabei de descobrir o seu blog e queria dizer que adorei navegar nas suas postagens. De qualquer forma, estarei assinando seu feed e espero que você escreva novamente em breve!