Fundadores e Inversores

¿Un humano escribió eso, o ChatGPT? Puede ser difícil saberlo, tal vez demasiado difícil, piensa su creador OpenAI, razón por la cual está trabajando en una forma de «marcas de agua» en el contenido generado por IA.

En un conferencia en la Universidad de Austin, el profesor de informática Scott Aaronson, actualmente investigador invitado en OpenAI, reveló que se está desarrollando una herramienta para «marcar estadísticamente con agua los resultados de un texto AI.” Cada vez que un sistema, por ejemplo, ChatGPT, genera texto, la herramienta incrusta una «señal secreta imperceptible» que indica de dónde proviene el texto.

El ingeniero de OpenAI, Hendrik Kirchner, construyó un prototipo funcional, dice Aaronson, y la esperanza es incorporarlo a futuros sistemas desarrollados por OpenAI.

“Queremos que sea mucho más difícil de tomar una salida AI y hacerla pasar como si viniera de un ser humano”, dijo Aaronson en sus comentarios. “Esto podría ser útil para prevenir el plagio académico, obviamente, pero también, por ejemplo, la generación masiva de propaganda, ya sabes, enviar spam a cada blog con comentarios aparentemente sobre el tema que apoyan la invasión rusa de Ucrania sin ni siquiera un edificio lleno de trolls en Moscú, o hacerse pasar por el estilo de escritura de alguien para incriminarlo”.

Explotando la aleatoriedad

¿Por qué la necesidad de una marca de agua? ChatGPT es un buen ejemplo. El chatbot desarrollado por OpenAI ha arrasado en Internet, mostrando una aptitud no solo para responder preguntas desafiantes, sino también para escribir poesía, resolver acertijos de programación y volverse poético sobre una gran cantidad de temas filosóficos.

Si bien ChatGPT es muy divertido y realmente útil, el sistema plantea preocupaciones éticas obvias. Al igual que muchos de los sistemas de generación de texto anteriores, ChatGPT podría usarse para escribir correos electrónicos de phishing de alta calidad y malware dañino, o hacer trampa en las tareas escolares. Y como herramienta de respuesta a preguntas, es inconsistente en cuanto a los hechos, una deficiencia que llevó a la programación del sitio de preguntas y respuestas Stack Overflow a prohibir las respuestas que se originan en ChatGPT hasta nuevo aviso.

Para comprender los fundamentos técnicos de la herramienta de marca de agua de OpenAI, es útil saber por qué los sistemas como ChatGPT funcionan tan bien como lo hacen. Estos sistemas entienden el texto de entrada y salida como cadenas de «tokens», que pueden ser palabras pero también signos de puntuación y partes de palabras. En esencia, los sistemas están generando constantemente una función matemática llamada distribución de probabilidad para decidir el siguiente token (por ejemplo, palabra) a generar, teniendo en cuenta todos los tokens emitidos anteriormente.

En el caso de los sistemas alojados en OpenAI como ChatGPT, después de que se genera la distribución, el servidor de OpenAI hace el trabajo de muestrear tokens de acuerdo con la distribución. Hay cierta aleatoriedad en esta selección; es por eso que el mismo mensaje de texto puede generar una respuesta diferente.

La herramienta de marca de agua de OpenAI actúa como un «envoltorio» sobre los sistemas de generación de texto existentes, dijo Aaronson durante la conferencia, aprovechando una función criptográfica que se ejecuta en el nivel del servidor para seleccionar «pseudoaleatoriamente» el siguiente token. En teoría, el texto generado por el sistema aún parecería aleatorio para usted o para mí, pero cualquiera que posea la «clave» de la función criptográfica podría descubrir una marca de agua.

“Empíricamente, unos pocos cientos de tokens parecen ser suficientes para obtener una señal razonable de que sí, este texto proviene de un sistema AI. En principio, podría incluso tomar un texto largo y aislar de qué partes probablemente provienen del sistema AI y qué partes probablemente no”. dijo Aaronson. “La herramienta puede hacer la marca de agua usando una clave secreta y puede verificar la marca de agua usando la misma clave”.

Limitaciones clave

La marca de agua del texto generado por IA no es una idea nueva. Los intentos anteriores, la mayoría basados en reglas, se han basado en técnicas como sustituciones de sinónimos y cambios de palabras específicos de la sintaxis. Pero fuera de lo teórico el informe de la investigación publicado por el instituto alemán CISPA en marzo pasado, sobre OpenAI parece ser uno de los primeros enfoques basados en criptografía para el problema.

Cuando se le contactó para hacer comentarios, Aaronson se negó a revelar más sobre el prototipo de marca de agua, salvo que espera ser coautor de un artículo de investigación en los próximos meses. OpenAI también se negó, diciendo solo que la marca de agua se encuentra entre varias «técnicas de procedencia» que está explorando para detectar resultados generados por IA.

Sin embargo, académicos no afiliados y expertos de la industria compartieron opiniones encontradas. Señalan que la herramienta es del lado del servidor, lo que significa que no necesariamente funcionaría con todos los sistemas de generación de texto. Y argumentan que sería trivial para los adversarios evitarlo.

«Creo que sería bastante fácil solucionarlo reformulando, usando sinónimos, etc.», comentó Srini Devadas, profesora de informática en el MIT,. “Esto es un poco como un tira y afloja”.

Jack Hessel, un científico investigador del Instituto Allen para la IA, señaló que sería difícil tomar huellas dactilares imperceptibles del texto generado por la IA porque cada token es una elección discreta. Una huella dactilar demasiado obvia puede dar lugar a que se elijan palabras extrañas que degradan la fluidez, mientras que una huella demasiado sutil dejaría lugar a dudas cuando se busca la huella dactilar.

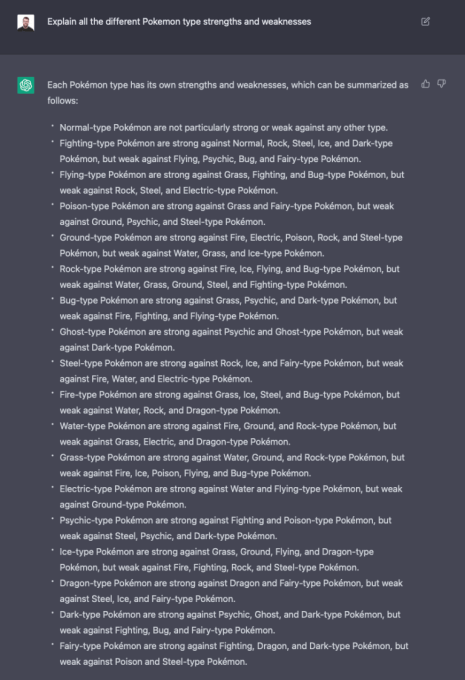

ChatGPT respondiendo una pregunta.

Yoav Shoham, cofundador y codirector ejecutivo de AI21 Labs, un rival de OpenAI, no cree que la marca de agua estadística sea suficiente para ayudar a identificar la fuente del texto generado por IA. Pide un enfoque «más completo» que incluya marcas de agua diferenciales, en las que diferentes partes del texto se marcan de manera diferente, y sistemas de IA que citen con mayor precisión las fuentes del texto fáctico.

Esta técnica específica de marca de agua también requiere depositar mucha confianza y poder en OpenAI, señalaron los expertos.

“Una huella dactilar ideal no sería perceptible por un lector humano y permitiría una detección altamente confiable”, dijo Hessel por correo electrónico. «Dependiendo de cómo esté configurado, podría ser que OpenAI sea la única parte capaz de proporcionar esa detección con confianza debido a cómo funciona el proceso de ‘firma'».

En su conferencia, Aaronson reconoció que el esquema realmente solo funcionaría en un mundo donde empresas como OpenAI están a la vanguardia en la ampliación de sistemas de última generación, y todos aceptan ser jugadores responsables. Incluso si OpenAI compartiera la herramienta de marca de agua con otros proveedores de sistemas de generación de texto, como Cohere y AI21Labs, esto no impediría que otros optaran por no usarla.

«Si se convierte en un juego de todos contra todos, entonces muchas de las medidas de seguridad se vuelven más difíciles, e incluso podrían ser imposibles, al menos sin la regulación gubernamental”, dijo Aaronson. “En un mundo donde cualquiera podía construir su propio modelo de texto que era tan bueno como ChatGPT, por ejemplo … ¿Qué se podría hacer ahí?»

Así es como se desarrolla en el ámbito de texto a imagen. A diferencia de OpenAI, cuyo sistema de generación de imágenes DALL-E 2 solo está disponible a través de una API, Stability AI abrió su tecnología de texto a imagen (llamada Stable Diffusion). Si bien DALL-E 2 tiene una serie de filtros en el nivel de API para evitar que se generen imágenes problemáticas (además de marcas de agua en las imágenes que genera), Stable Diffusion de código abierto no los tiene. Los malos actores lo han usado para crear porno falso, entre otras toxicidades.

Por su parte, Aaronson es optimista. En la conferencia, expresó la creencia de que, si OpenAI puede demostrar que las marcas de agua funcionan y no afectan la calidad del texto generado, tiene el potencial de convertirse en un estándar de la industria.

No todos están de acuerdo. Como señala Devadas, la herramienta necesita una clave, lo que significa que no puede ser completamente de código abierto, lo que podría limitar su adopción a las organizaciones que aceptan asociarse con OpenAI. (Si la clave se hiciera pública, cualquiera podría deducir el patrón detrás de las marcas de agua, anulando su propósito).

Pero puede que no sea tan descabellado. Un representante de Quora dijo que la compañía estaría interesada en usar dicho sistema y que probablemente no sería el único.

“Podría preocuparse de que todo este asunto de tratar de ser seguro y responsable al escalar la IA… tan pronto como perjudique seriamente los resultados de Google, Meta, Alibaba y los otros jugadores importantes, gran parte saldrá por la ventana, dijo Aaronson. “Por otro lado, hemos visto en los últimos 30 años que las grandes empresas de Internet pueden ponerse de acuerdo sobre ciertos estándares mínimos, ya sea por temor a ser demandados, por el deseo de ser vistos como un jugador responsable, o por cualquier otro motivo”.