Usuarios del Club TRPlane

Uno de los aspectos destacados de los modelos de inteligencia artificial generativa Gemini 1.5 Pro y 1.5 Flash, desarrollados por Google, es su capacidad para procesar y analizar grandes volúmenes de datos. En diversas presentaciones públicas y demostraciones, Google ha reiterado que estos modelos son capaces de llevar a cabo tareas que previamente se consideraban inalcanzables, gracias a su capacidad para considerar un «largo contexto». Entre estas tareas se incluyen la capacidad de resumir múltiples documentos extensos de cientos de páginas y de analizar escenas de películas.

Sin embargo, según una reciente investigación, los modelos no son eficaces en esas áreas.

Dos estudios independientes investigaron la eficacia de los modelos Gemini de Google y otros en el procesamiento de grandes cantidades de datos, utilizando como referencia la obra literaria «Guerra y paz». Ambos estudios concluyeron que los modelos Gemini 1.5 Pro y 1.5 Flash presentan dificultades para proporcionar respuestas precisas a preguntas formuladas sobre conjuntos extensos de datos. En pruebas realizadas con documentos, se observó que estos modelos solo ofrecieron respuestas correctas en un rango del 40% al 50% de las ocasiones.

Según Marzena Karpinska, postdoctorada en UMass Amherst y coautora de un estudio, a pesar de la capacidad técnica de modelos como Gemini 1.5 Pro para procesar contextos extensos, se han observado numerosos casos que sugieren que dichos modelos no logran comprender verdaderamente el contenido.

Falta la ventana de contexto de Gemini

El concepto de contexto en un modelo, conocido como ventana de contexto, hace referencia a la información de entrada que el modelo analiza previamente a la generación de la salida correspondiente. Por ejemplo, una pregunta directa como «¿Quién resultó ganador en las elecciones presidenciales de Estados Unidos en 2020?» puede ser considerada como contexto, al igual que un guion cinematográfico, un programa informático o un fragmento de audio. Conforme aumenta el tamaño de las ventanas de contexto, también se incrementa la cantidad de información contenida en los documentos que se incorporan en ellas.

Las versiones más recientes de Gemini tienen la capacidad de aceptar más de 2 millones de tokens como contexto. Los tokens son unidades de datos sin procesar que se subdividen, como las sílabas «fan», «tas» y «tic» en la palabra «fantástico». Esta cantidad equivale aproximadamente a 1,4 millones de palabras, dos horas de vídeo o 22 horas de audio, lo que representa el contexto más extenso disponible en el mercado comercial.

En una presentación realizada a principios de este año, Google exhibió diversas demostraciones pregrabadas con el propósito de ejemplificar las capacidades de contexto largo de Gemini. Una de ellas consistió en la utilización de Gemini 1.5 Pro para buscar citas humorísticas en la transcripción de la transmisión del aterrizaje lunar del Apolo 11, la cual consta de aproximadamente 402 páginas. Posteriormente, se identificó una escena en la transmisión que presentaba similitudes con un boceto a lápiz.

Durante la sesión informativa dirigida por Oriol Vinyals, vicepresidente de investigación de Google DeepMind, se describió el modelo como «mágico».

Enfatizó la importancia de llevar a cabo este tipo de tareas de razonamiento en cada página y en cada palabra.

Podría haberse tratado de una exageración.

En uno de los estudios previamente mencionados que compara estas habilidades, Karpinska, en colaboración con investigadores del Instituto Allen de Inteligencia Artificial y de la Universidad de Princeton, solicitó a los modelos que evaluaran afirmaciones verdaderas o falsas sobre obras de ficción en inglés. Se seleccionaron obras recientes para evitar que los modelos pudieran beneficiarse de conocimientos previos, y se plantearon afirmaciones con abundantes referencias a detalles específicos y puntos de la trama que requerirían la lectura completa de los libros para su comprensión.

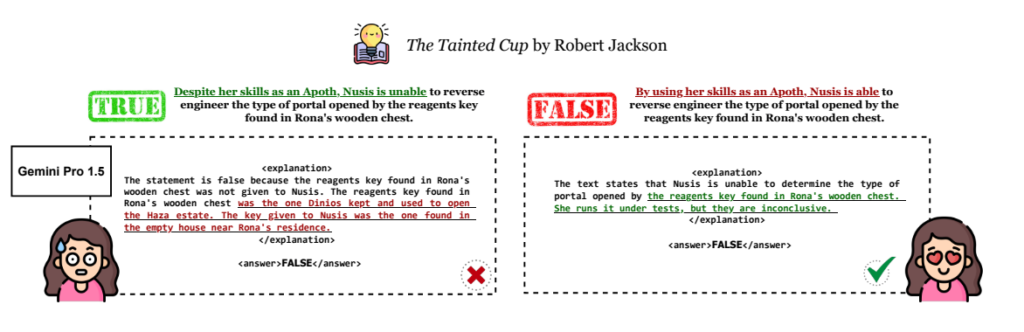

Ante la afirmación de que «Al utilizar sus habilidades como Apoth, Nusis puede aplicar ingeniería inversa al tipo de portal abierto por la llave de reactivos encontrada en el cofre de madera de Rona», Gemini 1.5 Pro y 1.5 Flash, tras haber consultado el libro pertinente, debieron determinar la veracidad de la declaración y justificar su respuesta.

Imagen: Universidad de Massachusetts Amherst.

En un estudio realizado por investigadores, se evaluó un libro con una extensión de aproximadamente 260.000 palabras, equivalente a unas 520 páginas. Se encontró que el modelo 1.5 Pro respondió correctamente a las afirmaciones de verdadero/falso en un 46,7 % de las ocasiones, mientras que el modelo Flash solo lo hizo en un 20 %. Esto indica que un enfoque aleatorio es más efectivo para responder preguntas sobre el libro que el último modelo de aprendizaje automático desarrollado por Google. Al analizar en conjunto todos los resultados obtenidos, ninguno de los modelos logró superar la precisión aleatoria al responder las preguntas planteadas.

Según Karpinska, se ha notado que los modelos enfrentan mayores dificultades al corroborar afirmaciones que implican analizar secciones extensas o incluso la totalidad de un libro, en contraste con aquellas que pueden ser confirmadas mediante la recuperación de evidencia a nivel de oración. Además, cualitativamente se ha observado que los modelos encuentran complicaciones al verificar afirmaciones que involucran información implícita evidente para un lector humano, pero que no está explícitamente expresada en el texto.

El segundo estudio, redactado por investigadores de la Universidad de California en Santa Bárbara, evaluó la capacidad de Gemini 1.5 Flash (excluyendo 1.5 Pro) para realizar procesos de razonamiento en videos, específicamente en la búsqueda y respuesta a preguntas sobre su contenido.

Los autores del estudio desarrollaron un corpus de imágenes que incluía preguntas sobre los objetos representados en ellas, como por ejemplo, una imagen de un pastel de cumpleaños con la pregunta «¿Qué personaje de dibujos animados aparece en este pastel?». Con el fin de evaluar los modelos, seleccionaron una imagen al azar y la rodearon de imágenes «distractoras» para simular una presentación de diapositivas.

Durante una prueba realizada, se observó que el rendimiento de Flash no fue óptimo al transcribir dígitos escritos a mano en una serie de 25 imágenes. En el caso de seis dígitos, la tasa de transcripciones correctas fue de aproximadamente el 50%, disminuyendo a alrededor del 30% al aumentar la cantidad de dígitos a ocho.

Según Michael Saxon, estudiante de doctorado en la UC Santa Barbara y coautor del estudio, en situaciones prácticas de responder preguntas sobre imágenes, se observa que todos los modelos evaluados encuentran dificultades. El reconocimiento de un número dentro de un marco y su interpretación parecen ser aspectos críticos que afectan el rendimiento de los modelos.

Google promete demasiado con Gemini

Ninguno de los estudios ha sido sometido a revisión por expertos, y tampoco han evaluado las versiones de Gemini 1.5 Pro y 1.5 Flash con contextos de 2 millones de tokens (ambos probaron las versiones con contextos de 1 millón de tokens). Se destaca que Flash no está diseñado para igualar la capacidad de Pro en términos de rendimiento; Google lo promociona como una opción más económica.

No obstante, ambas entidades contribuyen a la percepción de que Google ha excedido sus promesas y no ha cumplido con lo ofrecido en relación a Gemini desde sus inicios. Ninguno de los modelos evaluados por los investigadores, como el GPT-4 de OpenAI y el Claude 3.5 Sonnet de Anthropic, demostró un desempeño satisfactorio. Sin embargo, Google es el único proveedor de modelos al que se le otorga una facturación contextual en sus anuncios.

Saxon afirmó que no existe ningún inconveniente en declarar de manera directa que «nuestro modelo puede aceptar X cantidad de tokens» fundamentándose en detalles técnicos objetivos. Sin embargo, plantea la interrogante sobre la utilidad concreta que se puede derivar de esta capacidad.

La inteligencia artificial generativa está siendo sometida a un escrutinio creciente a medida que las empresas y los inversores experimentan una creciente insatisfacción con las limitaciones tecnológicas.

En dos encuestas recientes realizadas por Boston Consulting Group, se encontró que alrededor del 50% de los encuestados, todos ellos ejecutivos de alto nivel, expresaron su escepticismo sobre el potencial de la inteligencia artificial generativa para aumentar significativamente la productividad. Además, manifestaron preocupación por la posibilidad de errores y riesgos en la seguridad de los datos asociados con las herramientas basadas en inteligencia artificial generativa. Según un informe de PitchBook, se observó una disminución del 76% en los acuerdos relacionados con la inteligencia artificial generativa en etapas iniciales durante dos trimestres consecutivos, en comparación con el pico alcanzado en el tercer trimestre de 2023.

Los clientes buscan diferenciadores prometedores frente a los chatbots que resumen reuniones y generan detalles ficticios sobre personas, así como las plataformas de búsqueda de inteligencia artificial que funcionan como generadores de plagio. Google, que ha competido con sus rivales de inteligencia artificial generativa, a veces de manera torpe, se mostraba ansioso por convertir el contexto de Gemini en uno de esos diferenciadores.

Sin embargo, la decisión tomada parece haber sido anticipada.

Karpinska señaló la falta de un método establecido para verificar la presencia de un proceso de «razonamiento» o «comprensión» en textos extensos. Cada grupo que publica estos modelos desarrolla sus propias evaluaciones ad hoc para respaldar dichas afirmaciones. La autora destaca la dificultad de evaluar la veracidad de estas afirmaciones debido a la falta de transparencia sobre la duración del procesamiento de contexto, un detalle que las empresas no suelen compartir.

La solicitud de comentarios dirigida a Google no obtuvo respuesta.

Tanto Saxon como Karpinska sostienen que los antídotos a las afirmaciones exageradas sobre la inteligencia artificial generativa son mejores puntos de referencia y un mayor énfasis en la crítica de terceros. Saxon destaca que una de las pruebas más comunes para el contexto largo, conocida como «la aguja en el pajar» y citada por Google en sus materiales de marketing, evalúa únicamente la capacidad de un modelo para recuperar información específica, como nombres y números, de conjuntos de datos, sin abordar la capacidad de responder preguntas complejas sobre dicha información.

Según Saxon, «Todos los científicos y la mayoría de los ingenieros que emplean dichos modelos concuerdan en que nuestra cultura de referencia actual se encuentra deteriorada. Por consiguiente, es crucial que el público sea consciente de la necesidad de abordar con precaución los extensos informes que incluyen cifras como ‘inteligencia general en todos los puntos de referencia'».