Usuarios del Club TRPlane

¿Es factible que una Inteligencia Artificial solo se entrene con datos producidos por otra IA? Podría parecer una propuesta incoherente. Sin embargo, es algo que ha existido desde hace mucho y, a medida que resulta cada vez más complicado obtener información nueva y auténtica, ha ido adquiriendo relevancia.

Anthropic empleó información artificial para adiestrar uno de sus modelos emblemáticos, Claude 3.5 Sonnet. Meta modificó sus modelos Llama 3.1 empleando información producida por Inteligencia Artificial. Se menciona que OpenAI está recolectando datos sintéticos de entrenamiento de o1, su modelo de «razonamiento», para el próximo Orion.

Sin embargo, en primer lugar, ¿por qué la Inteligencia Artificial requiere de datos y qué datos necesita? ¿Y estos datos pueden ser reales o serán sustituidos por datos artificiales?

El valor de las anotaciones es crucial

Los sistemas de Inteligencia Artificial son dispositivos estadísticos. Formados con numerosos ejemplos, adquieren los patrones de esos ejemplos para realizar proyecciones, como un «a quién» en un email suele preceder a un «pueda interesar».

En estos ejemplos, las anotaciones, usualmente texto que identifica el significado o secciones de los datos que estos sistemas procesan, son un componente crucial. Actúan como orientadores, «enseñando» a un modelo a diferenciar entre objetos, espacios e ideas.

Considerese un modelo de categorización de fotografías donde se exhiban numerosas imágenes de cocinas marcadas con el término «cocina». Conforme se capacita, el modelo empezará a establecer conexiones entre «cocina» y las características generales de las cocinas (como que incluyan frigoríficos y encimeras). Tras el entrenamiento, frente a una imagen de una cocina que no figuraba en los primeros ejemplos, el modelo debería ser capaz de reconocerla como tal. Evidentemente, si las fotografías de las cocinas se etiquetaran como «vaca», se reconocerían como vacas, subrayando la relevancia de una correcta anotación.

El interés por la Inteligencia Artificial y la exigencia de suministrar datos etiquetados para su avance han impulsado el mercado de servicios de anotación. Un estudio de mercado de dimensiones estima que actualmente está valorado en 838,2 millones de dólares… y que ascenderá a 10.340 millones de dólares en los próximos diez años. Aunque no hay estimaciones exactas de la cantidad de individuos involucrados en el trabajo de etiquetado, para 2022, un informe ya establecía el número en «millones».

Las compañías de gran y pequeño tamaño se apoyan en los empleados de las empresas de anotaciones de datos para elaborar etiquetas para los grupos de IA. Algunos de estos empleos ofrecen un salario razonable, en particular si el puesto demanda habilidades especializadas (por ejemplo, matemáticas). Otros pueden resultar defraudantes. En países en vías de desarrollo, los anotadores reciben únicamente unos cuantos dólares por hora, sin ningún tipo de beneficio ni garantía de futuros conciertos.

Un pozo de información seco

Por lo tanto, hay motivos basados en las personas para explorar opciones distintas a las etiquetas creadas por los seres humanos. Sin embargo, también existen los que son más pragmáticos.

Los humanos solo tienen una cierta rapidez para etiquetar. Los anotadores también cometen errores que pueden aparecer en sus anotaciones y, más adelante, en cualquier modelo que haya sido entrenado por dichas anotaciones. Los anotadores cometen fallos o fallan en las indicaciones del etiquetado. Es caro contratar a las personas para estas tareas.

En general, los datos son caros. De hecho, Shutterstock está exigiendo a los proveedores de inteligencia artificial decenas de millones de dólares por el acceso a su archivo, mientras que Reddit ha obtenido cientos de millones a través de la otorgación de licencias de datos a Google, OpenAI y otros.

Finalmente, la obtención de datos también se vuelve cada vez más complicada.

La mayoría de los modelos se fundamentan en grandes cantidades de datos públicos, información que los dueños suelen ocultar cada vez más por miedo a que sus datos sean plagiados o a que no obtengan reconocimiento o atribución por parte de ellos. Más del 35% de las 1.000 páginas web más relevantes a nivel mundial actualmente bloquean el scraper web de OpenAI. Según un estudio reciente, aproximadamente el 25% de los datos de fuentes de «alta calidad» se han limitado a los principales grupos de datos empleados para entrenar modelos. Encontró que estudiar.

Si la tendencia actual de bloqueo de acceso persiste, el equipo de investigación Epoch AI desarrollará proyectos en los que los programadores se quedarán sin datos para entrenar modelos generativos de Inteligencia Artificial entre 2026 y 2032. Esto, sumado a los riesgos de demandas por derechos de autor y material sensible que pueda llegar a conjuntos de datos abiertos, ha forzado a los proveedores de Inteligencia Artificial a tomar decisiones.

Alternativas sintéticas

A primera vista, los datos artificiales parecen ser la respuesta a todas estas dificultades. ¿Requiere anotaciones? Puede crearlas. ¿Más información de ejemplo? Sin inconveniente. El cielo es la frontera.

Y hasta cierto grado, es verdad.

«Si ‘los datos son el nuevo petróleo’, los datos artificiales se muestran como biocombustibles, que pueden producirse sin las externalidades perjudiciales del producto auténtico», declaró Os Keyes, estudiante de doctorado en la Universidad de Washington que analiza el efecto ético de las tecnologías en desarrollo. «Es posible tomar un conjunto inicial reducido de datos y simular y extraer nuevas entradas a partir de este».

La industria de la Inteligencia Artificial ha adoptado el concepto y lo ha implementado.

Este mes, Writer, una compañía enfocada en la inteligencia artificial generativa, presentó un modelo, Palmyra X 004, entrenado prácticamente totalmente con datos artificiales. Writer sostiene que su desarrollo solo costó 700.000 dólares, frente a proyecciones de 4,6 millones de dólares para un modelo OpenAI de magnitud similar.

Los modelos Phi abiertos de Microsoft fueron entrenados parcialmente con datos artificiales. Los modelos Gemma de Google también lo fueron. Los modelos abiertos Phi de Microsoft se entrenaron utilizando datos sintéticos, en parte. También lo fueron los modelos Gemma de Google. Este verano, NVIDIA presentó una serie de modelos diseñados para producir datos de entrenamiento sintéticos, mientras que Hugging Face, una startup de inteligencia artificial, ha lanzado recientemente lo que sostiene es el conjunto de datos de entrenamiento de IA más grande de texto sintético.

La creación de datos sintéticos se ha convertido en un negocio autónomo, que podría tener valorarse en 2.340 millones de dólares para el año 2030. Gartner predice que este año se producirá sintéticamente el 60% de los datos empleados en proyectos de inteligencia artificial y análisis.

Luca Soldaini, investigador principal del Instituto Allen de Inteligencia Artificial, indicó que se pueden emplear métodos de datos artificiales para producir datos de entrenamiento en un formato que no se puede conseguir de manera sencilla a través de scraping, o incluso a través de licencias de contenido. Por ejemplo, al capacitar su generador de video Movie Gen, Meta empleó Llama 3 para generar subtítulos para las imágenes en los datos de entrenamiento, los cuales posteriormente fueron mejorados por los humanos para añadir más detalles, como especificaciones de la iluminación.

Además, OpenAI afirma que modificó GPT-4o empleando datos artificiales para generar la función Canvas que se asemeja a un bloque de dibujo para ChatGPT. Amazon ha afirmado que produce información artificial para enriquecer los datos reales que emplea para entrenar modelos de reconocimiento de voz para Alexa.

«Los modelos de datos artificiales pueden emplearse para expandir de manera rápida la percepción humana acerca de qué datos requieren para alcanzar un comportamiento de modelo particular», afirmó Soldaini.

Riesgos sintéticos

No obstante, los datos artificiales no constituyen una solución definitiva. Posee el mismo dilema de «introduce basura, expulsa basura» como toda la Inteligencia Artificial. Los modelos generan datos sintéticos, y si los datos empleados para entrenar estos modelos poseen prejuicios y restricciones, sus resultados estarán igualmente contaminados. Por ejemplo, los colectivos que no se representan adecuadamente en los datos base impactarán en los datos artificiales.

«La dificultad radica en que no se puede hacer mucho», afirmó Keyes. «Supongamos que solo cuentas con 30 individuos de raza negra en un conjunto de datos.» Podría ser útil extrapolar, pero si todas esas 30 personas pertenecen a la clase media o tienen piel clara, así se podrán observar todos los datos’representativos’.

Hasta este momento, 2023 un estudio de 2023 de los científicos de la Universidad Rice y Stanford hallaron que una dependencia excesiva de datos artificiales durante el entrenamiento puede generar modelos cuya «calidad o diversidad se reducen gradualmente». Según los investigadores, el sesgo de muestreo (una mala representación del mundo real) provoca que la diversidad de un modelo se deteriore tras varias generaciones de entrenamiento, aunque también hallaron que la combinación de datos del mundo real contribuye a atenuar este fenómeno.

Keyes percibe peligros extra en modelos complejos como el o1 de OpenAI, considerando que podrían generar alucinaciones más complicadas de identificar en sus datos artificiales. Esto, por consiguiente, podría disminuir la exactitud de los modelos entrenados con la información, en particular si las fuentes de las alucinaciones resultan difíciles de reconocer.

«Los modelos complejos alucinan; La información generada por estos modelos contiene alucinaciones», agregó Keyes. «Y con un modelo como o1, los desarrolladores mismos no siempre pueden justificar por qué surgen las mismas».

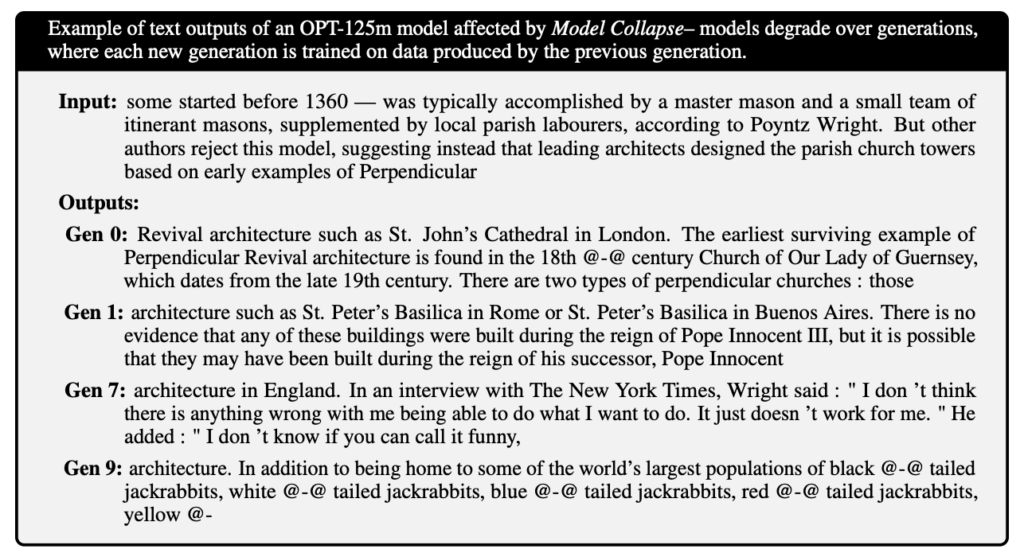

Las alucinaciones intensificadas podrían llevar los modelos a mostrar galimatías. El estudio publicado en la revista Nature muestra cómo los modelos, entrenados con datos repletos de fallos, producen aún más datos repletos de fallos y cómo este circuito de retroalimentación deteriora las futuras generaciones de modelos. Los investigadores hallaron que los modelos pierden la comprensión de saberes más esotéricos a través de las generaciones, volviéndose más universales y frecuentemente generando respuestas irrelevantes a las interrogantes que se les plantean.

Imagen proporcionada por: Ilia Shumailov y colaboradores.

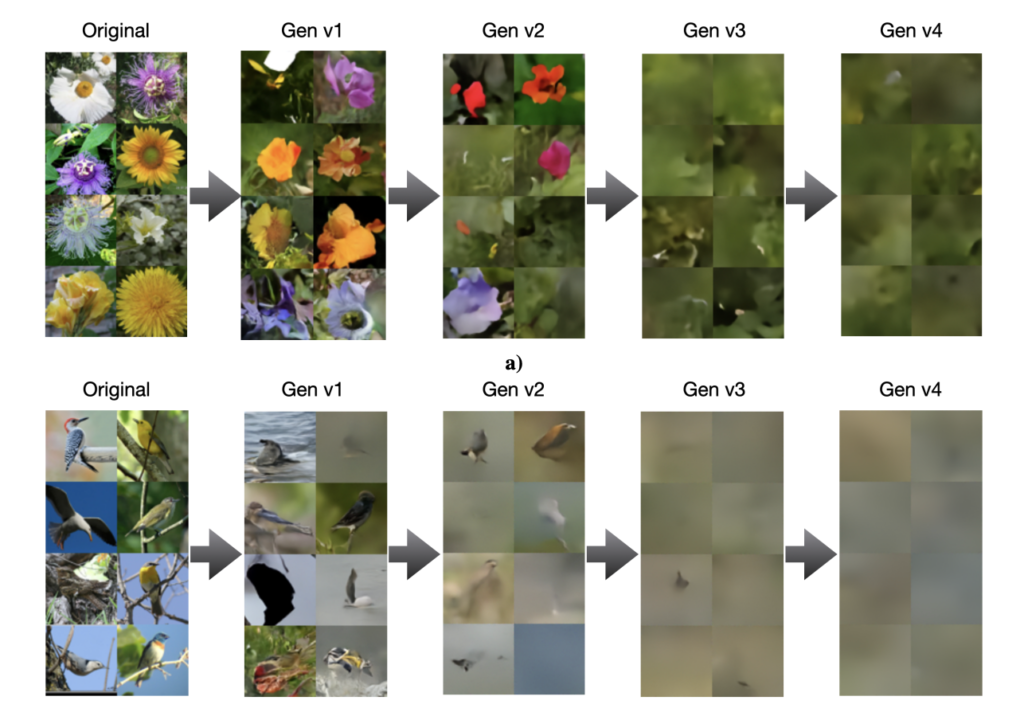

El estudio de seguimiento revela que otros tipos de modelos, como los generadores de imágenes, no están exentos a este tipo de colapso:

Imagen proporcionada por: Ilia Shumailov y colaboradores.

Soldaini concuerda en que no se puede confiar en los datos artificiales «en bruto», al menos si el propósito es prevenir el entrenamiento de chatbots olvidadizos y generadores de imágenes uniformes. Para emplearlo «de manera segura», sostiene, es imprescindible examinarlo, escogerlo y filtrarlo a fondo e, idealmente, fusionarlo con datos nuevos y auténticos, al igual que con cualquier otro conjunto de datos.

No hacerlo podría terminar conducirlo al colapso del modelo, en el que un modelo se torna menos «creativo» (y más prejuicioso) en sus resultados, lo que finalmente pone en riesgo grave su funcionalidad. A pesar de que este proceso podría ser detectado y frenado antes de que se desarrolle de manera severa, representa un peligro.

«Los científicos deben analizar los datos producidos, replicar el procedimiento de generación e identificar protecciones para suprimir puntos de datos de baja calidad», afirmó Soldaini. «Los canales de datos artificiales no son una máquina que se perfecciona por sí misma; su fabricación requiere una revisión y mejora meticulosa antes de ser empleada para su capacitación».

El director ejecutivo de OpenAI, Sam Altman, sostuvo una vez que la Inteligencia Artificial podría algún día generar datos artificiales de calidad suficiente para entrenar de manera eficaz. Sin embargo, si eso es posible, la tecnología todavía no ha llegado. Ningún laboratorio significativo de Inteligencia Artificial ha presentado un modelo entrenado basado exclusivamente en datos artificiales.

Al menos en el futuro previsto, parece que requeriremos de personas con conocimientos. en alguna parte del proceso para garantizar que el entrenamiento de un modelo no resulte inadecuado.