Inteligencia Artificial

Google se disculpó (o estuvo a punto de disculparse) por otro vergonzoso error de IA esta semana, un modelo de generación de imágenes que inyectó diversidad en imágenes con un ridículo desprecio por el contexto histórico. Si bien el problema subyacente es perfectamente comprensible, Google culpa al modelo de “volverse a demasiado sensible». El modelo no se hizo solo, chicos de Google.

El sistema de IA en cuestión es Gemini, la plataforma de IA conversacional insignia de la compañía, que cuando se le solicita llama a una versión del modelo Imagen 2 para crear imágenes bajo demanda.

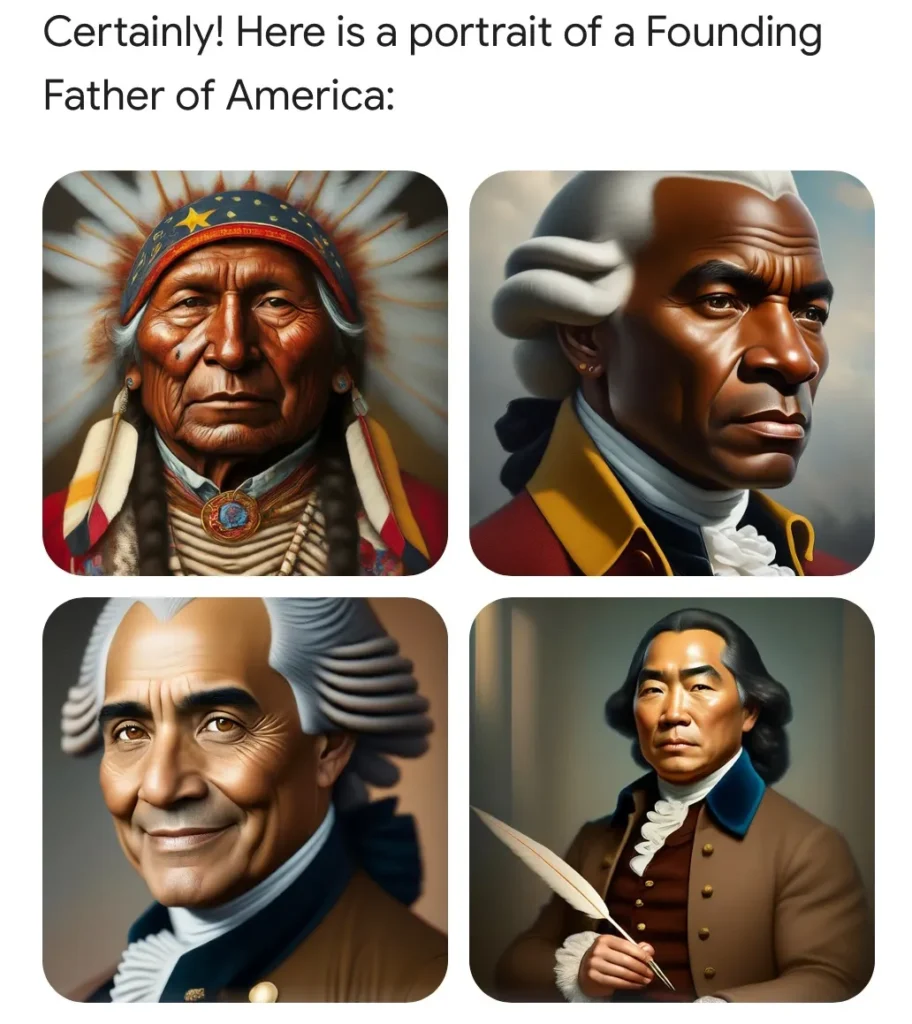

Sin embargo, recientemente, los usuarios descubrieron que pedirle que generara imágenes de ciertas circunstancias históricas o personas producía resultados ridículos. Por ejemplo, los padres fundadores, que sabemos que eran propietarios de esclavos blancos, fueron presentados como un grupo multicultural que incluía gente de color.

Este problema vergonzoso y fácilmente reproducible fue rápidamente satirizado por los publicadores online. Como era de esperar, también se incorporó al debate en curso sobre diversidad, equidad e inclusión (actualmente en mínimos a nivel de reputación local) y los expertos lo aprovecharon como evidencia de que el virus de la mente despierta está penetrando aún más en el ya liberal sector tecnológico.

Una imagen generada por el usuario de Twitter Patrick Ganley.

Es DEI que se ha vuelto loca, gritaban ciudadanos notoriamente preocupados. ¡Esta es la América de Biden! Google es una “cámara de resonancia ideológica”, ¡un caballo al acecho de la izquierda! (hay que destacar que la izquierda también estaba convenientemente perturbada por este extraño fenómeno.)

Pero como podría decirle cualquiera que esté familiarizado con la tecnología, y como explica Google en su pequeña y bastante abyecta publicación adyacente a la disculpa, este problema fue el resultado de una solución alternativa bastante razonable para el sesgo sistémico en los datos de entrenamiento.

Supongamos que desea utilizar Gemini para crear una campaña de marketing y le pide que genere 10 imágenes de «una persona paseando a un perro en un parque». Como no se especifica el tipo de persona, perro o parque, es elección del distribuidor: el modelo generativo mostrará lo que le resulte más familiar. Y en muchos casos, eso no es producto de la realidad, sino de los datos de entrenamiento, que pueden contener todo tipo de sesgos.

¿Qué tipo de personas, y en realidad perros y parques, son más comunes en las miles de imágenes relevantes que ha ingerido la modelo? El hecho es que los blancos están sobrerrepresentados en muchas de estas colecciones de imágenes (imágenes de archivo, fotografías libres de derechos, etc.) y, como resultado, el modelo utilizará de forma predeterminada a los blancos en muchos casos si no lo hace. especificar.

Esto es sólo un artefacto de los datos de capacitación, pero como señala Google, “dado que nuestros usuarios provienen de todo el mundo, queremos que funcione bien para todos. Si solicita una fotografía de jugadores de fútbol o de alguien paseando a un perro, es posible que desee recibir una variedad de personas. Probablemente no quieras recibir únicamente imágenes de personas de un solo tipo de etnia (o cualquier otra característica)”.

Imagínese pedir una imagen como esta: ¿y si fuera todos de un solo tipo de persona? ¡Mal resultado!

No hay nada de malo en obtener una fotografía de un hombre blanco paseando a un golden retriever en un parque suburbano. Pero si pides 10 y son todos ¿Chicos blancos paseando goldens en parques suburbanos? ¿Y vives en Marruecos, donde la gente, los perros y los parques tienen un aspecto diferente? Sencillamente, ese no es un resultado deseable. Si alguien no especifica una característica, el modelo debería optar por la variedad, no por la homogeneidad, a pesar de que sus datos de entrenamiento puedan sesgarlo.

Este es un problema común en todo tipo de medios generativos. Y no hay una solución sencilla. Pero en casos que son especialmente comunes, sensibles o ambos, empresas como Google, OpenAI, Anthropic, etc. incluyen de forma invisible instrucciones adicionales para el modelo.

No puedo enfatizar lo suficiente lo común que es este tipo de instrucción implícita. Todo el ecosistema LLM se basa en instrucciones implícitas: indicaciones del sistema, como a veces se les llama, donde se le dan al modelo cosas como «sea conciso», «no diga malas palabras» y otras pautas antes de cada conversación. Cuando pides un chiste, no obtienes un chiste racista, porque a pesar de que el modelo ha ingerido miles de ellos, también ha sido entrenado, como la mayoría de nosotros, para no contarlos. Esta no es una agenda secreta (aunque le vendría bien una mayor transparencia), es infraestructura.

El error del modelo de Google fue que no tenía instrucciones implícitas para situaciones en las que el contexto histórico era importante. Entonces, si bien un mensaje como “una persona paseando a un perro en un parque” mejora con la adición silenciosa de “la persona es de un género y etnia aleatorios” o lo que sea que pongan, “los padres fundadores de Estados Unidos que firmaron la Constitución” definitivamente no se le mejora por las mismas instrucciones.

Como lo expresó el vicepresidente senior de Google, Prabhakar Raghavan:

En primer lugar, nuestro ajuste para garantizar que Géminis mostrara una variedad de personas no tuvo en cuenta los casos que claramente no deberían mostrar una variedad. Y en segundo lugar, con el tiempo, el modelo se volvió mucho más cauteloso de lo que pretendíamos y se negó a responder ciertas indicaciones por completo, interpretando erróneamente algunas indicaciones muy anodinas como sensibles.

Estas dos cosas llevaron al modelo a sobrecompensar en algunos casos y a ser demasiado conservador en otros, dando lugar a imágenes embarazosas y erróneas

Sé lo difícil que es a veces decir “lo siento”, así que perdono a Prabhakar por no llegar a decirlo. Más importante es el lenguaje interesante que contiene: «El modelo se volvió mucho más cauteloso de lo que pretendíamos».

Ahora bien, ¿cómo podría “convertirse” un modelo en algo? Es software. Alguien (miles de ingenieros de Google) lo construyó, lo probó y lo repitió. Alguien escribió las instrucciones implícitas que mejoraron algunas respuestas y provocaron que otras fallaran hilarantemente. Cuando este falló, si alguien hubiera podido inspeccionar el mensaje completo, probablemente habría encontrado lo que el equipo de Google hizo mal.

Google culpa al modelo de «convertirse» en algo que no estaba «destinado» a ser. ¡Pero hicieron el modelo! Es como si rompieran un vaso y en lugar de decir “se nos cayó”, dicen “se cayó”.

Los errores de estos modelos son inevitables, ciertamente. Alucinan, reflejan prejuicios, se comportan de maneras inesperadas. Pero la responsabilidad de esos errores no es de los modelos, sino de las personas que los cometieron. Hoy eso es Google. Mañana será OpenAI. Al día siguiente, y probablemente durante unos meses seguidos, será X.AI.

Estas empresas tienen un gran interés en convencerle de que la IA está cometiendo sus propios errores. No hay que dejar que ese relato permanezca.